Hi-fi

Pour les articles homonymes, voir High fidelity (homonymie) et Hi-fi (homonymie).

Hi-fi ou hifi est l'abréviation du terme anglophone « high fidelity », qui signifie en français « haute-fidélité », utilisé dans l'électronique grand public ou l'électroacoustique. Ce terme est censé indiquer que le matériel paré de cette qualification offre une qualité supérieure aux équipements courants. Le but étant d'obtenir une reproduction sonore aussi proche que possible de l'original. Contrairement à une opinion largement répandue, les appareils « hi-fi » ne doivent pas répondre impérativement à des « normes hi-fi » : si des tentatives pour imposer des normes ont existé dans le passé, aucune vérification des performances n'est réalisée par un organisme officiel. L'idée même de « norme Hi-fi » est peu satisfaisante : le but des normes est généralement d'assurer la sécurité et l'interopérabilité des équipements, d'indiquer des méthodes de mesure, pas d'exiger un niveau de performance, ici difficile à définir et devant être réactualisé sans cesse. Le terme « hifi » peut donc être utilisé pratiquement sans contrainte par les fabricants, distributeurs, revendeurs. Les normes pouvant être invoquées sont soit obsolètes soit ne pouvant s'imposer en France car émanant d'organismes étrangers.

L'idée majeure de la haute-fidélité, contenue dans son nom même, est de reproduire un enregistrement de façon à obtenir une diffusion sonore aussi parfaitement conforme que possible à l'original. L'original étant la prestation d'artistes (musiciens, chanteurs, etc.) et l'enregistrement ou la retransmission qui en sont faits. Dans la pratique, la haute-fidélité se définit avant tout comme des équipements domestiques grand public destinés à la reproduction d'enregistrements disponibles dans le commerce. Elle diffère donc aussi bien de la création musicale que de la sonorisation et autres « renforcements sonores ». On peut d'ailleurs remarquer que le terme « haute-fidélité » est absent des ouvrages scientifiques et techniques portant sur le domaine dont elle relève1. En effet, la haute-fidélité peut aussi se définir comme une activité commerciale et un loisir, avec de nombreuses dérives2, auxquels les scientifiques et les professionnels du son ne souhaitent surtout pas être associés.

Histoire

En 1906, Lee De Forest un ingénieur de Bell Labs invente l'audion qui permet de réaliser les premiers amplificateurs électroniques. Cette invention améliore la qualité et la fidélité sonore des enregistrements radio. Lors de la Première Guerre mondiale, Le gouvernement américain crée la Radio Corporation of America qui va monopoliser de ces nouvelles technologies pour améliorer les transmissions radios dans les zones de guerre. Au début des années 1920, Major Armstrong, un autre ingénieur de Bell Labs, apporte une meilleure compréhension de cette nouvelle technologie. Ce développement va améliorer la qualité des appareils d’enregistrement et va permettre aux radios publiques de diffuser un son de bien meilleure qualité. Cette innovation popularise la radio car la musique peut maintenant être écoutée comme si on l’écouterait dans une salle de concert. Ces avancées vont aussi améliorer les appels téléphoniques à plus longue distance3.

Dans les années 1930, l’industrie du cinéma américain remarque que la fidélité de la bande audio de leurs films apporte à ceux-ci une nouvelle dimension émotionnelle aux spectateurs et que cela devient alors un argument commercial important. La fidélité sonore permet une meilleure et nouvelle sensation d'immersion dans les films. Cette nouvelle demande du public va placer la qualité des bandes-son cinématographiques comme le principal défi de l’électronique à cette époque. Bell Labs et RCA sont alors en compétition pour développer la technologie qui aura le meilleur rendu sonore pour le cinéma. Cette compétition va amener, jusque’à la fin des années 1930, de nombreuses améliorations et nouvelles technologies qui vont poser les fondations de l'industrie moderne de la Hi-fi. Le développement de l'audio va alors stagner durant la Seconde Guerre mondiale car les ingénieurs en électronique vont se concentrer sur d'autres domaines importants pour la guerre comme l'amélioration des radars. C’est après le conflit, à la fin des années 1940, que de nouvelles avancées ont lieu dans le domaine avec la création par David Theodore Nelson Williamson (en) d'un nouvel amplificateur nommé « Williamson ». Ce dernier améliore la fidélité des basses3.

Au début des années 1950, l’arrivée de nouveaux formats de LP par Columbia Records et RCA ainsi que la création de nouvelles stations FM de haute qualité va faire naître une industrie de la Hi-fi. Cette période, nommée l’« âge d’or de l’audio » par certains, va durer jusqu’au milieu des années 1960, et va voir l’arrivée de nombreux nouveaux acteurs dans le domaine3.

Dès la fin d’année 1960, le passage à la stéréo, l’invention des cassettes puis du CD (commercialisé depuis le début des années 1980) vont contribuer au changement des pratiques sonores. La baisse des coûts et la numérisation des matériels d'écoute vont privilégier la quantité à la qualité du son. Ces changements vont alors causer un certain déclin de la Hi-fi selon certains spécialistes4.

Dans le sillage du succès des DVD (début des années 2000), la généralisation actuelle des liaisons sans fil (wifi, Bluetooth) et des appareils connectés à Internet imposent une nouvelle forme de domotique sonore dans les foyers. On constate ainsi une évolution inéluctable de la Hi-fi vers une forme de plus en plus intégrée et qui tend vers le tout numérique.

Les systèmes multi-canaux nécessaires pour exploiter pleinement les disques SACD, DVD audio et autres Blu-ray musicaux (auxquels il faut ajouter les films et les jeux vidéo) sont devenus pratiquement incontournables.

Encore plus récemment, la dématérialisation des sources musicales5 liée aux gains en puissance permanents de l’informatique domestique séduit de plus en plus d’adeptes, y compris parmi les puristes audiophiles.

Seul le domaine de la reproduction acoustique proprement dite se trouve peu affecté par cette (r)évolution et le marché des enceintes acoustiques classiques demeure aussi international que pléthorique.

En parallèle avec l’équipement traditionnel (l’inamovible trilogie lecteur-ampli-paire d’enceintes) plutôt situé en haut de gamme mais toujours disponible — on observe même un regain d’intérêt significatif pour le « vinyle »6 — une offre considérable de nouveaux équipements soutient cette tendance : processeurs audio-vidéo, lecteurs réseaux dédiés (en concurrence avec les sites de streaming musical), convertisseurs de tous formats, barres de son, systèmes « multi-rooms », casques et enceintes sans fil ont ainsi envahi les allées des salons spécialisés.

Principes de base

La définition la plus courante, bien qu'elle soit trop connotée « électronique » est « un fil droit avec du gain ». Ce qu'on pourrait traduire en termes plus courants par « reproduction à l'identique avec la puissance nécessaire ». Suivant cette définition, la haute-fidélité s'interdirait toute modification du signal original. Il s'agit toutefois d'une sorte de déclaration de principe, loin d'être toujours suivie.

- La stéréophonie : même si rien n'interdit une haute-fidélité monophonique, la haute-fidélité a été indissolublement associée à la stéréophonie, couramment nommée « stéréo ». En effet son développement technique et commercial a été contemporain de l'apparition puis de la diffusion du vinyle stéréo au cours des années 1960. La stéréo a aussi l'intérêt de permettre une restitution réaliste de l'espace sonore (placement des instruments et des artistes sur une scène par exemple) qui permet donc de se rapprocher de la prestation originale7.

- La bande passante : l'exigence sans doute la plus difficile à remplir pour reproduire fidèlement un message musical est la restitution sans atténuation ni accentuation de toutes les fréquences du spectre audible. Les équipements audio traditionnels se contentent d'en restituer l'essentiel soit, très souvent, la simple bande téléphone (300 Hz - 3 400 Hz). Le grave et les sons les plus aigus sont sacrifiés. La haute-fidélité entend naturellement les reproduire ou du moins en reproduire l'essentiel8.

- La dynamique : une musique peut contenir des passages très forts et d'autres très faibles. La différence entre les deux est appelé dynamique. Pour la reproduire, il faut naturellement que le système haute-fidélité reproduise les passages les plus faibles au-dessus du bruit de fond. Il devra alors être capable de reproduire les passages les plus forts à un niveau conforme à la dynamique de l'enregistrement. De ce fait, une chaîne haute-fidélité doit impérativement (pour utiliser un terme courant) être puissante (par rapport aux équipements courants) et (plus exactement) avoir des capacités dynamiques élevées9.

- La distorsion : toute modification autre que le gain entre le signal d'entrée et le signal de sortie est évidemment à proscrire. Il existe de multiples formes de distorsion, la plus connue étant la distorsion harmonique. Les exigences pour la haute-fidélité varient mais se situent à des valeurs inférieures à 1 % pour le taux de distorsion harmonique (THD). En dessous de cette valeur, l'audibilité de la distorsion est très discutable10. Pour une très bonne qualité d'écoute, il faudrait envisager un THD inférieur à 0,1 %.

Normes et leurs caractéristiques

Il existe différentes normes (NF, DIN, ISO, CEI, JIS, etc.) censées assurer que l'on peut bien appliquer l'étiquette « haute-fidélité » à un équipement. Certaines sont anciennes et obsolètes, les autres se rejoignent dans les grandes lignes, mais diffèrent dans les détails. Par exemple, certaines de ces normes ne se contentent pas de garantir une large gamme de fréquence, mais incorporent des règles relatives au rapport signal sur bruit, à la compression sonore, etc. Toutes les normes utilisées actuellement incluent la stéréophonie dans leurs caractéristiques de base.

La norme allemande DIN 45500, qui est la plus connue en France et sert souvent de référence, date des années 1960. Complètement obsolète, elle a été remplacée, en Allemagne, par la norme DIN EN 61305 qui dispose d'une déclinaison française NF EN 61305.

Les normes à caractère national ont souvent été utilisées pour protéger un marché intérieur en rendant plus difficile l'importation et la diffusion de matériels venus d'autres pays. Même si cette époque semble largement révolue, il faut s'en souvenir et ne pas attacher trop d'importance à certaines normes qui correspondent plus à une époque et des circonstances qu'à des logiques scientifiques et techniques.

Chaîne haute-fidélité

Pour restituer le son d'un enregistrement, il faut réunir un certain nombre d'équipements : au minimum, l'appareil lecteur (source), l'amplificateur (qui amplifie le signal issu de la source et fournit la puissance) et les haut-parleurs, enceintes ou casque (qui transforment le signal électrique en ondes sonores). Ces équipements sont reliés les uns aux autres et forment donc une chaîne. Ce terme en est venu à désigner, surtout pendant une période, l'ensemble des équipements haute-fidélité dont on disposait11.

Sur le plan technique, l'interconnexion d'un nombre, plus ou moins grand, d'éléments séparés se justifiait pleinement aux débuts de la haute-fidélité, les circuits utilisés pouvant faire l'objet d'interférences par d'autres circuits trop proches et bon nombre d'entre eux étant susceptibles de dégager une chaleur importante. En revanche, les progrès de l'électronique ont rapidement permis de réunir dans un même appareil un grand nombre de fonctions sans réel inconvénient. Cette possibilité n'a cependant pas réellement conquis le monde de la haute-fidélité. D'une part le fait de pouvoir choisir un par un les éléments formant la chaîne était regardé comme important par les passionnés et d'autre part, c'était un atout pour le commerce des équipements haute-fidélité, chaque revendeur pouvant se singulariser par le choix des éléments proposés. Toutefois des ensembles « tout en un » étaient évidemment une option intéressante pour le grand public, offrant à la fois une plus grande simplicité de mise en œuvre, un encombrement et un coût réduit. D'autant plus qu'à la chaîne haute-fidélité classique (souvent au format 19 pouces ou approchant) se sont ajoutées les chaînes « Midi » puis « Mini » et enfin « Micro » de taille de plus en plus réduite12. Sur ces réalisations, le terme de « chaîne » est d'ailleurs souvent abusif : ces ensembles ont l'aspect d'éléments séparés (censés être plus prestigieux) mais, sur le plan technique, leurs éléments sont indissociables. Quand ils ne sont pas contenus dans un unique coffret, ils partagent des éléments techniques (comme l'alimentation) et sont interconnectés par des liaisons propriétaires : ils ne peuvent fonctionner séparément.

Sources Hi-fi

Le problème premier de la haute-fidélité a toujours été celui de la source d'enregistrements et, plus largement, de musique de qualité. Naturellement, il ne s'agit pas de goûts musicaux mais de qualité technique.

- Le disque microsillon : introduit à partir des années 1950 et devenu stéréophonique à partir de 1958, il a longtemps été le seul support possible pour la hi-fi. Il est resté le support principal jusqu'à l'arrivée sur le marché du disque compact (CD) en 1983. La recherche d'une lecture optimale de ses disques a été un souci constant de la part de l'amateur.

- Le tuner FM est un récepteur radio sans amplification ni haut-parleur, à raccorder sur un amplificateur hi-fi. Dès les années 1950, la Radiodiffusion-télévision française (RTF) commençait des émissions en modulation de fréquence (FM) monophoniques puis stéréophoniques. Pendant longtemps, la radio FM fut la seule source hi-fi permettant d'accéder à de la musique dont on ne possédait pas l'enregistrement. Le tuner FM a donc fait partie des éléments importants d'une chaîne hi-fi. En France, son importance s'est d'ailleurs accrue à partir de 1981 avec la fin du monopole étatique sur la radiodiffusion et le phénomène des « radios libres ».

- Les magnétophones et la cassette : les magnétophones à bande, utilisés pour les enregistrements professionnels, ont connu des déclinaisons grand public et des modèles hi-fi. Toutefois, leur coût et leur encombrement en ont fortement limité la diffusion. Une solution de remplacement a été trouvée avec la cassette qui n'était en rien prévue pour la hi-fi mais qui a été adaptée pour cet usage par une amélioration de sa qualité et de celle des appareils. La « platine cassette » est ainsi vite devenue un élément essentiel de la « chaîne », même si nombre d'amateurs lui ont toujours dénié le qualificatif de « haute-fidélité ». C'était, en effet, le seul outil pratique pour enregistrer (par exemple la radio FM) et pour dupliquer un disque.

- le CD est arrivé sur le marché à partir de 1983 ; il est rapidement devenu, en dépit des réticences de nombre d'amateurs peu enclins à faire le saut vers le numérique, la source de référence de la hi-fi13. Offrant à la fois une utilisation beaucoup plus pratique et sûre que le « vinyle » et des performances techniques bien meilleures, il s'est d'autant plus imposé que le coût des lecteurs de CD n'a cessé de diminuer au fil des années.

Limites techniques et solutions

Spectres sonores réels

Le spectre sonore est souvent divisé, par convention, en trois sections. Le grave, le médium et l'aigu, avec respectivement des gammes de fréquences approximatives variant de 20 à 150 Hz, de 150 Hz à 2 kHz et de 2 à 20 kHz. Des divisions plus fines sont souvent utilisées par les spécialistes, telles qu'extrême-grave, bas-médium, haut-médium, extrême-aigu. Dans tous les cas il s'agit de conventions, une approche plus technique se référant à l'échelle des fréquences. On retrouve logiquement la gamme de fréquences 20 Hz - 20 kHz que l'oreille humaine jeune perçoit. Le spectre sonore est représenté suivant une échelle logarithmique sur un diagramme de Bode afin d'offrir une correspondance avec les sensations de l'audition humaine.

Problèmes

Les matériaux utilisés pour l'enregistrement à partir de microphones et pour la restitution sonore à l'aide de haut-parleurs ne permettent pas facilement de travailler sur un signal de qualité hi-fi.

La restitution du numérique pose principalement trois problèmes :

- la définition du standard de conversion qui ne peut plus être améliorée ensuite ;

- la constitution du signal à l'enregistrement qui est une conversion analogique → numérique ;

- la restitution du signal à l'écoute qui est une conversion inverse numérique → analogique.

Le transport quant à lui est en général très largement maîtrisé, tant que l'on reste sur la partie numérique.

La restitution du signal analogique pose principalement quatre problèmes :

- le transport qui est pollué par tout l'environnement électromagnétique ;

- les systèmes de lectures qui sont influencés par leur environnement ;

- le couplage entre amplificateur et enceintes, qui réagissent entre eux ;

- le couplage des enceintes avec leur environnement.

En conclusion, l'introduction du numérique permet d'optimiser le transport du signal analogique initial, il suffit de repousser la conversion au plus près de l'appareil de restitution final (l'amplificateur et les enceintes), et la conversion inverse au plus près des instruments. Mais s'il élimine une bonne partie des défauts liés à l'environnement, il crée ses propres défauts que l'on retrouve aux deux extrémités dans les conversions analogique-numérique et inversement.

Techniques de restitution

À partir d'une source (numérique ou analogique), un signal électrique est créé, il est ensuite amplifié et envoyé vers des haut-parleurs qui transforment le signal électrique en ondes sonores qui voyageront jusqu'à l'oreille de l'auditeur. Chacune de ces étapes doit être réalisée avec soin, chaque élément étant source de dégradation possible. C'est ainsi qu'est née la notion de chaîne haute-fidélité ou chaque élément fait partie d'une chaîne.

Le processus de restitution du son était relativement stable jusqu'à l'arrivée de l'informatique, qui offre des possibilités très diverses dans la restitution du son. (Voir Son numérique.)

Historiquement, la restitution du son se faisait avec la voix ou avec des instruments dédiés qui produisaient leur propre son (bâton de pluie). En 1877, Edison a déposé le brevet d'un outil permettant de graver le son : le phonographe (littéralement). L'appareil consiste en quatre éléments : un système d'amplification, un système de captation du son, un outil d'écriture et un support d'enregistrement. Dans les faits, on a un cornet, un diaphragme, une aiguille et un cylindre sur lequel on grave le son. Ce système est réversible.

Ces éléments sont toujours valables de nos jours, mais, de la même manière que l'on a des cordes vocales et une oreille, la technologie a préféré optimiser ces éléments pour chaque activité : enregistrement sonore et reproduction.

L'arrivée de l'électricité a été une formidable aide dans l'enregistrement et la reproduction sonore. En effet, l'élément critique de la chaîne est le couple diaphragme/aiguille qui est très peu efficace car de très faibles énergies sont en jeu, ce qui rend la gravure difficile et peu fidèle à l'original. La restitution est également d'un niveau très faible. L'électricité a permis de capter les vibrations du diaphragme (via un couple aimant/bobine), de les amplifier et ainsi de bouger l'aiguille de manière plus précise et plus fidèle (via un couple aimant bobine aussi). Le support est finalement devenu un disque (pour des raisons de capacité de stockage). La restitution du son possède le même étage d'amplification électrique mais à l'envers : le signal électrique produit par la bobine est amplifié puis transmis à un haut-parleur. Finalement, le diaphragme a évolué en une très fine et petite membrane pour le microphone, et en une membrane plus large pour ce que l'on appelle « haut-parleur ». Finalement, on se retrouve face au triplet microphone - platine tourne-disques - haut-parleur.

Il reste deux évolutions : la préamplification et la numérisation.

- La préamplification consiste à amplifier directement à la source le signal électrique produit par le microphone ou l'aiguille de la platine tourne-disques afin de limiter les parasites (soufflement et autres). En effet, le signal est tellement faible (mesuré en microvolts) qu'il est très facilement parasitable. Le signal est donc amplifié jusqu'à un ordre de grandeur proche du volt, beaucoup plus robuste et ainsi beaucoup plus facilement manipulable.

- Enfin, la numérisation permet une conservation parfaite du signal du moment qu'il a été numérisé : même avec tous les progrès réalisés, l'enregistrement et la lecture par une aiguille sont toujours restés les points critiques, détériorant plus ou moins le son. La numérisation consiste à mesurer très souvent (44 100 fois par seconde pour un disque compact) l'intensité du signal électrique provenant du microphone, et de lui attribuer une valeur entière (entre −32 768 et 32 767 pour un enregistrement 16 bits, comme sur un CD). Ces nombres sont enregistrés sur un support numérique (bande, puis disque laser, puis clé USB). En stéréo, cela fait 2 × 44 100 × 16 bit/s, soit 635 mégaoctets par heure. C'est ce qui explique que sur un CD, on ne puisse coder qu'environ 74 min de musique.

Aujourd'hui, différents effets et filtres sont venus s'intercaler entre les différents éléments de cette chaîne sonore afin d'optimiser le son. De plus des formats de compression numériques sont arrivés pour faire prendre moins de place à la musique, souvent avec une perte du signal minimisée (MP3, WMA, etc.).

Fidélité sonore

Définition

La fidélité sonore et la hi-fi sont nées du désir de capturer le monde et de le reproduire le plus fidèlement possible afin de moins en moins être capable de distinguer l’original de la copie14.

Analogique et numérique

Au milieu des années 1980, les audiophiles débattent quant à la supériorité de l'analogique sur le numérique et plus spécifiquement du vinyle sur le disque compact (CD). Ils reprochent au son numérique d’être stérile, froid et dépourvu d’émotion, en contraste avec l’analogique qui retransmet un son plus riche. Durant les deux décennies qui suivent, les ingénieurs réussissent à améliorer le rendu sonore des CD, mais il manque toujours de cohésion, d’intégrité et de musicalité selon ses détracteurs15.

Les formats audio numériques haute définition modernes, PCM et DSD, offrent toutefois aujourd'hui des performances qui peuvent largement dépasser celles constatées lors des débuts de l'audio numérique. À tel point que le débat les concernant porte aujourd'hui sur l'utilité d'encoder de manière encore plus précise le signal audio numérique, dans la mesure où l’ouïe humaine semble dépassée au-delà de certaines fréquences d’échantillonnage et profondeurs de bit16.

Les composants utilisés dans les convertisseurs numériques-analogiques (DAC) ont également bénéficié des progrès de la micro-informatique, avec des puces DAC toujours plus puissantes, des filtres numériques de meilleure qualité, et un soin porté à la conception des circuits d'alimentation et à l'isolation plus poussé. Ces améliorations qualitatives permettent de préserver la pureté du signal audio numérique à chaque étape du transport dans les appareils de bonne facture17.

Enfin, l'enregistrement et la manière dont le processus de mixage et de mastering ont été réalisés ont également un effet notable sur la fidélité de la reproduction sonore offerte par une chaîne hi-fi17.

Selon Eric Rothenbuhler et John Peters, deux professeurs de l’histoire des médias, l'analogique serait plus proche du son original car les bandes magnétiques utilisées garderaient une trace de la musique. Cette trace est matérialisée par les bosses et les creux que laisse l’enregistrement du son sur les bandes magnétiques. Ces reliefs sont même visibles à l’aide d’un microscope et d’un liquide spécial. Selon eux, il y a alors un lien physique et un rapport de fidélité entre le son d’origine et la copie sur bandes. Au contraire, ils pensent que le numérique ne fait que convertir le signal en binaire et serait donc plus éloigné et moins fidèle du son de départ. Ainsi l’enregistrement ne serait plus qu’une donnée et non plus de la musique18.

Ethnographie des audiophiles

Aujourd’hui, il existe une classe d’auditeurs qui investissent beaucoup d’argent pour acheter des équipements d’une fidélité extrême pour écouter de la musique. Souvent ils installent leurs propres espaces dédiés à l’écoute de musique, par exemple dans leur cave19.

On distingue alors deux groupes d’auditeurs :

- les « golden ears » ou « oreilles d’or », qui vont plutôt faire confiance à leur oreille et investir dans des installations sonores qui selon eux ont une bonne fidélité sans en considérer les caractéristiques technologiques ;

- les « meter readers » ou les « mesureurs », qui vont plutôt mesurer et utiliser les caractéristiques techniques à la recherche du meilleur son.

Références

- Mario Rossi, Électro-acoustique, Dunod, (ISBN 2-04-016532-0)

- Hifi Book 1981 : Tout ce qu'il faut savoir de la hifi, La Courneuve/Bondoufle, Pietri, , 187 p. (ISBN 2-903538-01-8), p. 15

- « A Tiny History of High Fidelity, Part 1 » [archive], sur www.nutshellhifi.com (consulté le )

- « A Tiny History of High Fidelity, Part 2 » [archive], sur www.nutshellhifi.com (consulté le )

- « Exploiter la Musique Dématérialisée - Mode d'Emploi - CTA-HIFI » [archive], sur www.cta-hifi.com (consulté le )

- « Musique : à l'heure du streaming, le vinyle confirme son grand retour », Le Figaro, (lire en ligne [archive], consulté le )

- Condamines R., Stéréophonie, Masson, Paris, 1978, (ISBN 2-225-49577-7)

- Hifi Book 1981 : Tout ce qu'il faut savoir de la hifi, La Courneuve/Bondoufle, Pietri, , 187 p. (ISBN 2-903538-01-8), p. 37

- Hifi Book 1981 : Tout ce qu'il faut savoir de la hifi, Pietri, (ISBN 2-903538-01-8), p. 40

- Le Livre des Techniques du Son, t. 2, Dunod, Paris, (ISBN 2-903055-21-1)

- Définition de « chaîne » [archive], sur larousse.fr

- Hifi Book 1981 : Tout ce qu'il faut savoir de la hifi, Pietri, (ISBN 2-903538-01-8), p. 28

- Bourreau Marc et Labarthe-Piol Benjamin, « Le peer to peer et la crise de l'industrie du disque » [archive], sur www.cairn.info, Réseaux 3/2004, no 125, p. 17-54, DOI:10.3917/res.125.0017

- Jonathan Sterne (trad. Maxime Boidy), Une histoire de la modernité sonore, La Découverte, (ISBN 978-2-7071-8583-9, OCLC 922873283, lire en ligne [archive])

- (en) Evens Aden, Sound ideas music, machines, and experience, University of Minnesota Press, (ISBN 0-8166-4536-1, OCLC 748859003).

- (en) Joshua D. Reiss, « A Meta-Analysis of High Resolution Audio Perceptual Evaluation », Journal of the Audio Engineering Society, vol. 64, no 6, , p. 364–379 (DOI 10.17743/jaes.2016.0015, lire en ligne [archive], consulté le ).

- Paul, « L'audio numérique haute définition face à l'analogique » [archive], sur Concert Home, (consulté le ).

- (en) Eric W. Rothenbuhler et John Durham Peters, « Defining Phonography: An Experiment in Theory », The Musical Quarterly, .

- (en) Trevor Pinch et Karin Bijsterveld, « Sound Studies: New Technologies and Music », Social Studied of Science, .

Voir aussi

Articles connexes

- Chaîne haute-fidélité

- Son stéréophonique

- Acoustique

- Gammes et tempéraments dans la musique occidentale

- Dolby

Liens externes

- Hyperbol, Capacités dynamiques d'un système audio [archive]

- Portail de la musique

- Portail de la physique

- Portail de l’électricité et de l’électronique

Baladeur

Walkman Sony WM-GX302 (1995).Walkman NWZ-S618F (2008).Un baladeur est un appareil électronique portable de très petit format (de poche) destiné à l'écoute de musique. Certains modèles permettent l'enregistrement, ou sont munis d'un écran permettent la visualisation de contenus multimédias.

Histoire

Le prototype, nommé Stereobelt (en), a été inventé par Andreas Pavel. Il dépose le brevet en 1976. La plupart des industriels ne sont pas convaincus. Sony rachète finalement les droits et commercialise le le TPS-L2, le premier Walkman, qui permet de lire les cassettes audio. Le produit remporte un grand succès et se vend à 1,5 million d'exemplaires en deux ans1.

Les concurrents suivent très vite et les années 1980 voient diverses améliorations, notamment une perte du poids et une diminution de la consommation électrique1.

Le premier baladeur numérique est commercialisé en 19981.

Depuis, le baladeur a évolué en fonction des avancées technologiques : baladeur cassette, baladeur CD, baladeur numérique, smartphone.

Le marché atteint un pic en 2008 avant de décliner, concurrencé par les smartphones2.

Étymologie et terminologie

Le mot « baladeur » est le terme recommandé en France par la DGLFLF3 et au Canada par l'OQLF. Il évoque la balade, c'est-à-dire la promenade.

Dans la langue parlée, il fut longtemps en concurrence avec le terme Walkman, marque commerciale de Sony qui avait semblé s'imposer dans un premier temps car c'était la première marque à proposer ce genre d'appareil en 1979.

« Baladeur » s'est peu à peu implanté dans les dénominations commerciales et supports publicitaires, grâce à sa promotion par une grande entreprise de distribution, la Fnac, et sa revue mensuelle d'information Contact. L'usage du terme semble tout à fait généralisé dans la langue écrite (annonces publicitaires, catalogue de VPC, prospectus des grandes surfaces mis dans les boîtes aux lettres, etc.) en 19874. Cette évolution a été facilitée par le fait que les autres fabricants de lecteurs portables avaient besoin d'un terme générique, « Walkman » étant la propriété de Sony5.

Dans les années 2000, devant la généralisation des baladeurs numériques, c'est le terme impropre « lecteur MP3 » ou simplement « MP3 » qui prédomine dans le langage parlé en France.

Description

Le Walkman, dans sa désignation commerciale, est une gamme d'appareils électroniques conçus et commercialisés par Sony en 1980. C'était, jadis, un lecteur portatif de cassettes audio, de dimensions réduites, alimenté par piles et permettant d'écouter de la musique au moyen d'écouteurs.

Aujourd'hui, les baladeurs sont numériques, plus compacts, et peuvent comporter un écran pour pouvoir regarder des images fixes ou animées (photos, films, vidéos). Ils sont désormais fréquemment remplacés par des smartphones, qui permettent d'embarquer un volume important de contenu multimédia (images et sons) ou d'y accéder sur l'Internet. L'apparition de petits haut-parleurs de poche, à piles ou batteries, connectés sans fil au baladeur ou au smartphone, offre également la possibilité d'écouter de la musique sans écouteurs individuels, voire d'utiliser le baladeur comme un appareil de restitution sonore domestique, en lieu et place d'un appareil fixe.

Prévention des risques auditifs

Durant une écoute à forte intensité sonore et prolongée, l'exposition peut aboutir à un traumatisme auditif. Il se manifeste par des pertes auditives partielles ou totales, des acouphènes et de l'hyperacousie. Les conséquences sont parfois dramatiques dans la vie de l'individu car ces pathologies sont irréversibles6.

Référence

- Didier Forray, « Du Walkman à l'iPod, 30 ans de balade » [archive], sur 01net.com, (consulté le ).

- Étienne Froment, « Les lecteurs MP3 ne sont plus à la mode » [archive], sur lesoir.be, (consulté le ).

- Journal officiel du 22 septembre 2000, voir FranceTerme.

- Loïc Depecker, en collaboration avec Gina Mamavi, La Mesure des mots : cinq études d'implantation terminologique [archive], Publications de l'Université de Rouen, Le Havre, 1997, 528 pages, p. 161 : « Cependant la direction de la Fnac décidera de "lancer" le terme baladeur. Selon les informations qui nous ont été données par le service commercial, elle fera des recommandations pour que le terme soit utilisé dans les textes d'information, dans les annonces de publicité, etc. »

- Loïs Depecker, op. cit., p. 162.

Voir aussi

Vinyle

Pour l’article homonyme, voir Disque microsillon.

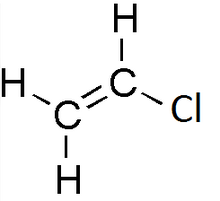

Le vinyle est, selon l’Union internationale de chimie pure et appliquée, l’autre nom qui est donné à l’éthényle de formule développée suivante :

(où R est le reste de la chaîne carbonée à laquelle l’alkyle « vinyle » est rattaché).

Le polychlorure de vinyle est une matière plastique très utilisée. Elle est obtenue par la polymérisation du chlorure de vinyle.

Le chlorure de vinyle est un gaz incolore préparé à partir de l’acétylène, susceptible de subir une polymérisation sous l’action de la lumière ou de divers catalyseurs, utilisé dans l’industrie des matières plastiques, en synthèse organique ou comme agent réfrigérant

Les applications les plus connues sont celles du disque vinyle ou comme revêtement de sol plastique, composé de plusieurs couches.

Le vinyle est aussi gravé sur du tissu pour être utilisé dans l'habillement.

Textiles

En tant que textile, il est composé de deux couches : une base qui est soit tissée en chaine et trame, extensible ou non, soit en maille, donc très élastique. Sur cette base est collée la pellicule de vinyle. Cela donne un tissu laqué imperméable reflétant énormément la lumière. C'est une matière non respirante, contrairement à la plupart des textiles.

Figurines

Le vinyle est également utilisé pour de nombreuses figurines, ainsi de nombreuses marques s'en servent pour créer leurs figurines à collectionner. On peut noter les figurines Vinylmation (Disney), les figurines Kidrobot, ou encore une multitude de figurines de la marque Funko (Pop Vinyl !, Mystery Minis, Blox…)

Voir aussi

- Portail de la chimie

Cassette audio

Cassette audio 60 min de la marque TDK.La cassette audio, Compact Cassette selon sa désignation officielle, appelée encore minicassette ou musicassette — couramment abrégé en français par l'allographe K7 — est un support d'enregistrement magnétique inventé par Lou Ottens, breveté et mis sur le marché en 1963 par Philips après plusieurs années de recherche et de développement. Elle contient deux bobines autour desquelles s'enroule une bande magnétique. Elle permet d'enregistrer et d'écouter de la musique ou tout autre type de son. Elle s'utilise avec un magnétophone spécialement conçu appelé « magnétocassette » ou « magnétophone à cassette ». Cet élément peut être intégré dans un appareil plus complexe comme un radiocassette, un combiné autoradio ou une chaîne haute-fidélité.

Principe

Lecteur-enregistreur à cassettes haut de gamme Nakamichi, avec système de retournement physique de la cassette pour une lecture automatique des deux côtés.Quatre canaux (pistes) sont écrits en parallèle sur la bande. Deux sont enregistrés lorsque la bande se trouve sur un côté dans l'enregistreur et deux autres lorsqu'elle est retournée.

Certains lecteurs de cassette peuvent lire successivement les deux côtés de la cassette sans nécessiter que l'utilisateur retourne la cassette manuellement : on parle alors, selon un terme d'origine anglaise, d'« auto-reverse ». Généralement, cela est possible grâce à une tête de lecture double ou pivotante, et par l'inversion du sens de défilement de la bande, mais certains lecteurs retournent réellement la cassette.

Historique

C'est le Néerlandais Lou Ottens (1926-2021), directeur de Philips Audio, qui dirigea la création de la cassette compacte et du magnétophone à cassette en 19631 dans la filiale belge de l'entreprise, à Hasselt.

La cassette connaît un très grand succès et constitue la norme d'enregistrement audio domestique jusqu'à l'apparition des disques compacts enregistrables. Elle supplante en deux décennies le format américain de la cartouche audio à quatre ou huit pistes qui s'est bien développé sur le marché national, tant dans les chaînes hifi que les autoradios.

Musicassette de More du groupe Pink Floyd, commercialisée par EMI.Jusqu'à 1983 et l'apparition du disque compact audio, les enregistrements commerciaux ont été diffusés sous forme de disques microsillon et de cassettes dites musicassettes2. La musicassette a perduré bien au-delà de l'apparition du CD, en particulier aux États-Unis. À partir de 1983, les ventes de musicassettes ont largement dépassé celles des disques analogiques 33 tours vinyles3, car les appareils portables et l'autoradio offraient à la cassette des domaines d'utilisation privilégiés. La cassette fut aussi à la base du succès mondial du Walkman (baladeur), le lecteur de cassette ultra-portable commercialisé en 1979 par Sony.

Alors que la cassette audio était déjà en perte de vitesse depuis la commercialisation du CD audio, la grande popularité des baladeurs numériques depuis le début des années 2000 lui fait perdre un des derniers marchés où elle conservait un avantage sur le CD : les appareils portatifs soumis à des chocs ou vibrations (pour les sports tel que le jogging, par exemple).

Vers le milieu des années 2000, à l'instar des VHS, on ne trouve plus en vente que des cassettes audio vierges, entre autres pour les personnes ayant encore dans leur voiture des auto-radios avec lecteur de cassettes et également pour enregistrer des extraits radio, cela étant impossible avec un CD ou sans ordinateur (pour les podcasts). Il reste aussi, tout comme pour le disque analogique 33 tours vinyle, des passionnés audiophiles utilisant encore ce support du fait qu'il est analogique. Des appareils haut de gamme sont capables de délivrer une restitution sonore d'excellente qualité.

Fin 2010, reviennent à nouveau en vente des lecteurs de cassettes sur matériel audio grand public (exemples : postes radio CD MP3 cassettes portables, nouvelles platines K7)4,5. Fait surprenant, de plus en plus de gens utilisent de nouveau ce support afin d'y enregistrer leurs albums, comme cela se faisait dans les années 1970 et 806. Il s'agit toutefois d'un phénomène très marginal.

Bien que le CD ait supplanté la cassette audio, on peut encore en trouver des exemplaires vierges à un coût très raisonnable dans beaucoup d'enseignes.

Début 2013, certains artistes comme les groupes Archive et Daft Punk souhaitent ressortir leurs albums dans ce format. Le groupe français Daft Punk a édité son dernier album Random Access Memories en cassette, mais seulement pour sa promotion.

De plus, de nombreux albums originaux parus avant 1992 ne sont pas sortis sur CD et ne sont donc disponibles qu'en format LP 33 tours, 45 tours ou cassette.

Types

Cassettes types IEC I, II, et IV.Cassette type IEC III.Afin d'améliorer les performances, les fabricants ont utilisé diverses formules pour la bande magnétique contenue dans les cassettes. Avec toutefois l'inconvénient de devoir utiliser un magnétocassette adapté à ces nouvelles cassettes. Un véritable bond dans les performances s'est effectué, au début des années 1970, avec la cassette au dioxyde de chrome (CrO2) cette nouvelle cassette exigeant un appareil pourvu d'une position spéciale « Chrome ». Les choses se sont compliquées avec l'apparition de cassettes double couche (oxyde de fer plus dioxyde de chrome), dites « ferrichrome », puis au début des années 1980 avec l'introduction de la cassette métal. Pour remédier à une évidente complexité d'utilisation, une normalisation IEC a été adoptée : chaque modèle de cassette devait se classer dans un des quatre types existants.

- Type I : cassettes dites « normales », moyenne linéaire 20 Hz-18 kHz (max 10 Hz-21 kHz).

- Type II : cassettes dites « chrome », moyenne linéaire 20 Hz-19 kHz (max 10 Hz-23 kHz).

- Type III : cassettes dites « ferrichrome », moyenne linéaire 20 Hz-19 kHz (max 10 Hz-23 kHz).

- Type IV : cassettes dites « métal », moyenne linéaire 20 Hz-20 kHz (max 10 Hz-30 kHz)7,8,9.

Les magnétocassettes ont d'abord été équipés de quatre touches correspondant aux quatre types de cassette puis un codage mécanique par encoches au dos de la cassette a été adopté : les appareils disposant de ce système adoptaient automatiquement les réglages adaptés à la cassette introduite dans leur mécanisme.

Dans la pratique, les cassettes type I et II ont constitué l'essentiel du marché. En effet, les cassettes de type III n'ont pas rencontré beaucoup de succès et peu de marques en ont commercialisé. Les cassettes les plus performantes, type IV, étaient onéreuses et trouvaient surtout un intérêt pour la prise de son.

Longueurs et durées

La cassette a été disponible en une grande variété de longueurs de bande et donc de durées d'enregistrement ou de lecture. La durée en minutes (à la vitesse standard de 4,75 cm/s) sert à désigner la cassette pour les modèles vierges. Les durées les plus courantes étaient les C60 (30 min par face) et les C90 (45 min par face), mais d'autres ont été disponibles : les C46 et les C120, puis diverses durées, soit très courtes pour les utilisations informatiques ou publicitaires, soit intermédiaires comme les C80 ou C100. Le but était souvent de s'adapter à la durée des albums (vinyles ou CD) afin de pouvoir en enregistrer un par face. Les cassettes C120 (deux heures) utilisaient une bande magnétique très fine et ont eu mauvaise réputation : elles exigeaient une mécanique au fonctionnement parfait (donc généralement onéreuse) sinon elles se froissaient et devenaient inutilisables. La marque TDK a commercialisé des cassettes de 180 min (deux fois 90 min), des D180 extrêmement fragiles. Les cassettes utilisées pour l'édition musicale (musicassettes) étaient naturellement de longueur variable, en fonction des enregistrements qu'elles contenaient.

Vitesses de défilement

La vitesse de défilement standard de la bande magnétique est de 4,762 5 cm/s, limitant ainsi la qualité sonore, surtout dans les hautes fréquences. Pour réduire le souffle et augmenter la dynamique audio, beaucoup d'enregistreurs à cassette sont équipés d'un système de réduction de bruit de fond, en général du type Dolby NR B ou C.

Il a toutefois existé de petits magnétophones quatre voire huit pistes utilisant la minicassette pour réaliser des maquettes, dans lesquels la bande défilait deux fois plus vite, à 9,5 cm/s (pour améliorer la dynamique et la bande passante). Le plus célèbre, utilisé dans les années 1970 à 1990 par les groupes à petit budget, était le Portastudio de Tascam-TEAC. Des platines cassette haute fidélité utilisant cette même vitesse ont aussi été mises, assez brièvement, sur le marché.

Cette vitesse de défilement doublée, en plus de n'être compatible qu'avec un nombre très restreint d'appareils, réduisait aussi par deux la durée de la cassette, par exemple à un maximum de 22 min 30 pour une cassette de 2 × 45 min. Ces appareils utilisant toute la largeur de la bande afin de répartir les quatre pistes (ou six, ou huit selon les modèles), la cassette ne pouvait être utilisée que sur une seule « face ».

Il a également existé des magnétocassettes disposant d'une vitesse de défilement réduite de moitié (2,38 cm/s) permettant une très longue durée d'enregistrement ou de lecture10. Comme pour les modèles à 9,5 cm/s, l'absence de compatibilité avec la plupart des appareils existants a amené leur disparition rapide.

Autres utilisations

La cassette a été utilisée comme moyen de stockage informatique sur les premiers ordinateurs personnels. L'enregistrement se faisait de manière analogique (les signaux numériques étaient transformés en modulation sonore) et la restitution était peu fiable. Aucune correction d'erreur n'était possible et le volume de données enregistrées très réduit. Ce support a vite été abandonné au profit de la disquette lorsque les prix sont devenus plus abordables pour le grand public. Le dernier ordinateur utilisant les cassettes fut le CPC 464+ d'Amstrad en 1990.

Un lecteur de cassette peut aussi servir d'adaptateur pour connecter d'autres sources sonores. En effet, il existe des câbles munis d'une fausse cassette audio à l'extrémité et une prise jack à l'autre afin de pouvoir passer les sons de son lecteur MP3 via le lecteur cassette à l'aide de sa tête de lecture captant les informations converties.

Autres formats dérivés de la cassette

Dans le but d'améliorer la qualité sonore (dynamique et bande passante) et de conserver une durée d'écoute suffisante, Sony a développé le format Elcaset. Commercialisé en 1976, c'était une cassette de grande taille où la bande tournait à 9,5 cm/s. Sony espérait ainsi combiner la qualité des enregistreurs à bande utilisant des bobines encombrantes et un format de taille réduite (quoique plus grand que la cassette standard) facilement manipulable (sans la difficulté de monter une bobine et de faire passer manuellement la bande près des têtes).

Malgré sa qualité supérieure, le format Elcaset fut un échec commercial total. Le prix supérieur des enregistreurs et des Elcasets, que peu de fabricants commercialisaient, et la taille trop encombrante pour le grand public ont fait que seuls quelques audiophiles s'en sont équipés. Le fait que le format Elcaset soit trop grand pour les appareils portables et les autoradios a aussi joué en sa défaveur. De plus, la qualité de la cassette audio standard avait progressé avec l'adoption des bandes au dioxyde de chrome et les réducteurs de bruit de fond, et était devenue suffisante pour beaucoup de personnes11.

Le système Elcaset a été abandonné en 1980 et les derniers équipements vendus en Finlande11.

Comparaison d'une microcassette à une cassette audio classique.En sens inverse, Philips a commercialisé en 1967 la mini-cassette pour les appareils de dictée. De conception très simple12, le lecteur-enregistreur ne pouvait pas assurer un défilement régulier de la bande, la vitesse fluctuant à environ 2,4 cm/s.

Olympus a sorti le format microcassette en 1969, développée également pour les « appareils de dictée » et connu sous le nom de « format Dictaphone ». Les microcassettes ont une qualité sonore trop médiocre pour l'enregistrement musical, mais suffisante pour la voix. Les microcassettes ont également été utilisées pour les répondeurs téléphoniques jusqu'à l'avènement de l'enregistrement numérique sur puces mémoire et ensuite sur serveurs distants (messageries), comme pour les téléphones mobiles.

La société Dictaphone a développé avec JVC, en 1985, un format encore plus réduit : la picocassette, spécialement conçue pour des systèmes de dictée extrêmement compacts. La bande a 2 mm de largeur et défile à 0,9 cm/s. La picocassette ne pesait que 3 g et pouvait contenir 60 min de parole. Ce système était très cher : entre 395 et 550 $ pour l'appareil et 20 $ pour un ensemble de trois picocassettes13.

De ces trois formats spécialement conçus pour l'enregistrement de la voix, le format microcassette d'Olympus est celui qui a eu le plus de succès. Il reste courant actuellement malgré l'avancée du numérique.

En 1992, Philips, avec Matsushita, a essayé de reproduire le succès commercial de la cassette en sortant la cassette compacte digitale ou DCC. Cette cassette digitale était du même format que l'ancienne musicassette, les appareils DCC étant capables de lire les cassettes analogiques. Leur qualité de son s'avérait assez moyenne du fait d'un mode de compression dénommé PASC, basé sur le MPEG1 qui était déjà bien dépassé par l'ATRAC, compression utilisée pour le MiniDisc de Sony, qui lui, a rencontré un bon succès du fait de sa qualité et de son format réduit, très pratique à utiliser. Le DCC n'a pas connu de succès commercial, le grand public s'orientant de plus en plus vers les disques compacts enregistrables (CD-R et CD-RW) et les professionnels étant déjà majoritairement équipés de lecteurs-enregistreurs DAT.

Renaissance

En 2016, National Audio Company (NAC) produit des cassettes audio vierges14.

La même année, RecordingTheMasters (RTM) produit de nouvelles cassettes Type I15.

En 2019, Mulann Industries, une PME française, se lance dans la production de cassettes audio vierges16.

En 2021, ATR Magnetics et NAC produisent de nouvelles cassettes Type II17,18.

Notes et références

- « Lou Ottens, l'inventeur de la cassette, est décédé », La Libre Belgique, (lire en ligne [archive], consulté le ).

- « Définitions : musicassette - Dictionnaire de français Larousse » [archive], sur larousse.fr (consulté le ).

- « http://www.cairn.info/revue-reseaux-2004-3-page-17.htm »(Archive.org • Wikiwix • Archive.is • http://www.cairn.info/revue-reseaux-2004-3-page-17.htm" rel="nofollow" class="external text">Google • Que faire ?).

- « Actu culture » [archive], sur Marie Claire (consulté le ).

- « Musique. Ressortez vos Walkman ! » [archive], sur Courrier international, (consulté le ).

- (en-US) Lily Rothman, « Rewound », Time, (ISSN 0040-781X, lire en ligne [archive], consulté le ).

- « Technics RS-B100 Three Head Cassette Deck Manual » [archive], sur hifiengine.com (consulté le ).

- « Pioneer CT-S920S Stereo Cassette Deck Manual » [archive], sur hifiengine.com (consulté le ).

- « Pioneer CT-95 » [archive], sur hifiengine.com (consulté le ).

- HIFI Book 1981 : Tout ce qu'il faut savoir de la HiFi, La Courneuve/Bondoufle, Pietri, , 187 p. (ISBN 2-903538-01-8), p. 128.

- (en) Kees Stravers, « The end of the Elcaset » [archive], The Sony Elcaset cassette tape machine (consulté le ).

- « Les différents formats de cassettes »(Archive.org • Wikiwix • Archive.is • http://home.comcast.net/~trafficgard/Micro-mini-cassette.htm" rel="nofollow" class="external text">Google • Que faire ?).

- (en) Technology: The Tiniest Tape Ever [archive], Time, 27 mai 1985.

- (en-US) appx, « National Audio Company » [archive], sur National Audio Company (consulté le ).

- (en) « Audio cassettes » [archive], sur recordingthemasters.com.

- « En Bretagne, une entreprise ressuscite la cassette audio », Le Monde, (lire en ligne [archive], consulté le ).

- (en) « ATR Magnetics Cobalt Gold Series - Type II Cassette » [archive], sur atrtape.com.

- (en) « C756 Cobalt Cassettes Type II » [archive], sur nationalaudiocompany.com.

Voir aussi

Articles connexes

Liens externes

-

Notice dans un dictionnaire ou une encyclopédie généraliste

- Portail de la musique

- Portail des technologies

Cassette vidéo

Cassette vidéoType Bande magnétique, support lisible par machine (en), périphérique de stockage d'informationUtilisation Utilisateurs Video tape recorder (en), Magnétoscope, caméscopeLa cassette vidéo, aussi appelée vidéocassette, voire parfois K7, est un support magnétique pouvant être enregistré ou visionné à l'aide d'un magnétoscope. Ce support contient un vidéogramme. La vidéocassette comprend une bobine de bande magnétique pouvant défiler et lire ou enregistrer les signaux vidéo et audio. Lors de la lecture ou de l'enregistrement, la bande est généralement enroulée autour d'un tambour rotatif qui comporte les têtes de lectures. Les pistes sont le plus souvent enregistrées sur le modèle hélicoïdal sur la bande, c’est-à-dire en tranches obliques. Le plus souvent, une tranche correspond à une demi-image ou trame du signal vidéo. L'enregistrement peut être analogique (FM) ou numérique.

Les premiers prototypes – U-matic – furent développés par Sony à partir de 1969.

Depuis le début des années 2000, la cassette vidéo n'est plus d'usage, au même titre que la cassette audio. Elle a été remplacée par le DVD qui présentait de nombreux avantages : pas de rembobinage, une meilleure qualité audio et vidéo et une plus grande capacité de stockage, qui tend à disparaître à son tour pour laisser place au disque Blu-ray voire à d'autres modes de stockage et de visionnage, comme par exemple le téléchargement ou la diffusion en flux continu.

La fin de production des dernières cassettes vidéo s'est effectuée en juillet 2015 pour les VHS1 et le pour les cassettes Betamax2.

Formats

Il existe plusieurs formats de cassette vidéo :

Notes et références

- Monique Marczynke, « Les cassettes VHS – la fin d'un grand succès » [archive], sur MAGIX Magazine, (consulté le ).

- Guillaume -, « Appareils insolites disparus #4 : Le Betamax » [archive], sur Blog Cobra, (consulté le ).

Enceinte (audio)

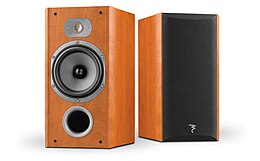

Une paire d'enceintes acoustiques de type bibliothèque, de la marque française Focal JMlab.Structure d'une enceinte acoustique basique.Une enceinte est un coffret comportant un ou plusieurs haut-parleurs, permettant la reproduction du son à partir d'un signal électrique fourni par un amplificateur audio1. La partie amplification peut être intégrée ou non à l'enceinte, et des dispositifs électroniques comme des filtres sont souvent incorporés.

Principes de base

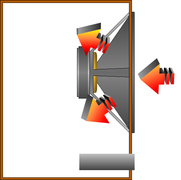

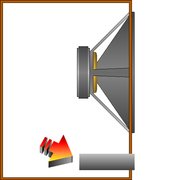

Enceinte acoustique 3 voies de marque JBL.On désigne souvent une enceinte par le terme anglais de baffle2. Cette appellation est une métonymie (la partie pour le tout) puisque le baffle désigne en réalité le support plan, plaque généralement en bois voire en plastique, sur lequel est fixé le haut-parleur, et non l'enceinte dans sa totalité. Le baffle permet d'éviter que les ondes sonores émises par l’arrière du haut-parleur ne viennent interférer, voire annuler, les ondes sonores émises par l’avant du haut-parleur. Lorsqu'il est refermé sur lui-même en encerclant un certain volume d'air, il forme une enceinte.

Lorsqu'un haut-parleur est mis en fonctionnement, la membrane de celui-ci fait vibrer l'air devant, mais aussi derrière. Au moment de la vibration où la membrane avance, la pression de l'air augmente devant, mais diminue derrière, et inversement au moment où la membrane recule : On dit que l'onde arrière est déphasée de 180°. Les variations de pression de l'air - le son - ne sont donc pas correctement transmises à l'air environnant puisque l'air a tendance à circuler entre l'avant à l'arrière de la membrane pour égaliser les pressions. C'est le phénomène dit du court-circuit acoustique. Il est donc nécessaire de supprimer (ou du moins de gérer au mieux) les vibrations arrières. Dans la pratique, on appelle charge acoustique la façon dont on va gérer ce problème. La solution théorique idéale consiste à fixer le haut-parleur sur un « baffle infini », c'est-à-dire une plaque de très grande dimension. Cette solution étant peu praticable, les spécialistes ont trouvé une multitude de manières, plus ou moins complexes, de le faire3.

Une enceinte contient en général non seulement le ou les haut-parleurs, mais aussi les éventuels filtres, modules d'amplification, boutons de mise sous tension ou de réglage, grilles de protections, ou encore des évents pour le cas d'une enceinte bass-reflex. Enfin, elle est équipée de connecteurs destinés à brancher un amplificateur ou autre source de modulation contenant l'information sonore à diffuser. Certaines enceintes dites « sans fil » peuvent se passer d'une telle connexion, la modulation arrivant par transmission radio (actuellement Bluetooth le plus fréquemment pour les produits grand public) ou parfois infrarouge. De telles enceintes sont souvent alimentées par piles ou batterie en faisant ainsi des appareils mobiles.

Il existe une multitude de types d'enceintes acoustiques correspondant d'une part à des usages très variés, et d'autre part à des niveaux de qualité différents, étant généralement considéré que les enceintes sont le maillon faible de la chaîne de restitution sonore avec le local d'écoute. L'usage que l'on souhaite en faire est donc primordial : sonorisation, monitoring, Hi-Fi ou encore home cinema. Le genre musical n'a, contrairement à une idée reçue largement répandue, rien à voir avec l'enceinte à choisir : une enceinte de bonne qualité doit être capable de restituer correctement n'importe quel type de son. Cela fait même partie des critères et techniques de sélection d'une enceinte4. Cependant, l'application visée détermine les critères à sélectionner, ainsi on n'utilisera pas les mêmes solutions pour diffuser de la musique en grande surface, et pour sonoriser un concert en extérieur.

Histoire

À gauche un phonographe à cylindre d'Edison, à droite un gramophone datant de 1910. Le premier dispositif permettant au grand public d'écouter de la musique chez lui est le phonographe, breveté par Thomas Edison le . Il fut suivi par le gramophone inventé par Émile Berliner en 1888, qui utilisait des supports en forme de disques. Dans ces deux appareils, il n'y a pas d'« enceinte » à proprement parler : le son est émis par une membrane liée à l'aiguille au contact du support, et amplifié uniquement grâce à un pavillon. Le principe du pavillon acoustique5 consiste à réaliser une adaptation d'impédance entre la membrane émissive et l'air ambiant. On obtient ainsi une amélioration spectaculaire de l'efficacité si bien que les pavillons restent, au moins pour les fréquences médium et aigu, presque universellement utilisés dans le domaine de la sonorisation de puissance. Pour le grave, la taille du pavillon devient le plus souvent prohibitive ainsi cette solution reste rare mais il faut citer l'enceinte Klipschorn de Klipsch, créée dans les années 1940, qui utilise un pavillon dans le grave grâce à l'exploitation des murs de la salle en étant positionnée en encoignure6.

L'un des premiers haut-parleurs à bobine mobile, inventé par Rice et Kellogg en 1924.Les premières réalisations de haut-parleur quant à elles, remontent au XIXe siècle. Mais les véritables débuts du haut-parleur à bobine mobile tel qu'on le connaît datent de 1924, date à laquelle Chester W. Rice et Edward W. Kellogg en déposèrent le brevet, en même temps qu'un amplificateur capable de fournir une puissance de 1 watt pour leur dispositif. Ce dernier, le Radiola Model 104, avec amplificateur incorporé, fut mis sur le marché l'année suivante. On parle de haut-parleur de Rice-Kellogg pour désigner cette première réalisation. La paternité est toutefois contestée, des travaux similaires ayant eu lieu dans les principaux pays développés dont la France7.

Les haut-parleurs utilisent toujours le même principe de base et ont pris assez rapidement leur forme définitive mais les évolutions n'en sont pas moins très importantes : matériaux utilisés, conception et test à l'aide de systèmes informatiques font que les performances ont connu des progrès considérables, y compris sur les modèles de grande diffusion.

Longtemps, l'utilisation des haut-parleurs s'est effectuée par simple montage sur un baffle plan ou un coffret ouvert à l'arrière (baffle replié) mais une étape importante a été franchie en 1954 par l'Américain Edgar Villchur (en) qui a monté un haut-parleur à suspension souple dans un coffret clos de taille réduite : c'est la technique dite de la « suspension acoustique ». Commercialisé par Acoustic Research (AR), le modèle AR 3 a connu un grand succès pendant de nombreuses années8,9.

L'idée d'exploiter l'émission arrière du haut-parleur semble remonter à la fin des années 1920 et le premier brevet déposé en ce sens est dû à Albert L. Thuras (et non à A.C. Thuras comme on peut lire assez souvent) en 193210. Ce principe général deviendra la charge connue sous le nom de « bass-reflex ». Ce sont les travaux des chercheurs Neville Thiele (en) en 1961 et Richard H. Small (en) en 1973 qui marqueront une avancée déterminante dans la modélisation permettant l'exploitation efficace de ce type de charge. À tel point que les paramètres électromécaniques des haut-parleurs sont désormais associés à leur nom sous la dénomination de « paramètres de Thiele et Small » (en) ou « paramètres T/S »11.

Les premières chaînes hifi, permettant à l'époque d'écouter des disques microsillons, apparaissent dans les années 1950 ; et la première enceinte active multi-amplifiée a été réalisée par le Français Cabasse en 1958.

Pour la construction de l'enceinte proprement dite, si le bois reste largement utilisé, le plastique l'est de plus en plus. Outre ses qualités propres, il permet de réaliser des formes complexes, mieux adaptées à un bon rendu acoustique qu'un parallélépipède, ce qui était impossible à un prix raisonnable avec les matériaux traditionnels.

Caractéristiques et spécifications d'une enceinte

Puissance admissible

La puissance électrique admissible ne représente pas sa capacité en terme d'énergie sonore. Il s'agit de sa capacité à encaisser sans dommage une puissance électrique. Le haut-parleur, qui est un transducteur, transforme cette énergie électrique en énergie acoustique, son rendement détermine le niveau sonore obtenu. Ainsi, la puissance admissible d'une enceinte ne représente pas le niveau sonore émis par celle-ci. Ce n'est pas non plus une garantie de qualité sonore.

Dans la pratique, définir la puissance admissible d'une enceinte acoustique est difficile. En effet, une enceinte est destinée à reproduire de la musique dans des conditions variées et non un signal parfaitement défini et stable dans un laboratoire. La meilleure démonstration de ces faits est la multiplicité des manières de définir (et éventuellement de mesurer) la puissance admissible d'une enceinte acoustique : puissance nominale, puissance musicale, puissance programme, puissance en crête, etc. Il existe des normes comme IEC 268-5, AES2-1984 ou, plus ancienne, AFNOR NFC 97-330 mais le consensus est difficile à trouver.

La compréhension et une bonne interprétation de ces normes n'est pas à la portée du grand public. Pour ce dernier, la meilleure indication et la plus facilement compréhensible est une recommandation, par le constructeur, de la puissance d'amplification à associer à une enceinte : par exemple « Amplification recommandée : 50 à 150 W efficaces ».

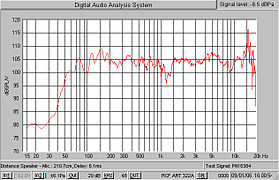

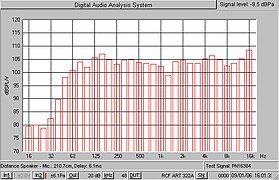

Réponse en fréquence

La réponse en fréquence permet de déterminer quelles fréquences sonores seront reproduites par l'enceinte et avec quelle erreur par rapport au niveau de référence (généralement le niveau à 1 kHz). Elle peut être mesurée rapidement à l'aide d'un analyseur de spectre12. La réponse en fréquence est souvent indiquée sous une forme chiffrée simplifiée : typiquement limite basse (en Hz) - limite haute (en Hz ou kHz), erreur acceptée (en décibels). Cela donne, par exemple, 40 Hz −18 kHz, −6 dB. Une réponse dépourvue d'indication de l'erreur acceptée n'est d'aucune utilité, cette erreur pouvant être considérable.

L'indication d'une réponse en fréquence sous forme chiffrée ne donne toutefois que peu d'informations. On lui préfère une courbe de réponse, tracée sur un diagramme de Bode. C'est toutefois (pour une enceinte acoustique) un document complexe qui demande à être interprété par des personnes compétentes pour en tirer des informations pertinentes. Par ailleurs, une interprétation correcte exige de connaître dans quelles conditions et avec quels paramètres techniques elle a été relevée. Généralement, l'abscisse du graphe représente la fréquence et s'étend de 20 Hz à 20 000 Hz, et l'ordonnée représente le niveau en dB12.

Dans la pratique, il faut distinguer les courbes de réponse à destination d'un public relativement large qui sont des versions simplifiées donnant une idée globale de la réponse d'une enceinte et les courbes destinées aux ingénieurs et techniciens, beaucoup plus détaillées mais aussi plus complexes. À la limite, les courbes simplifiées deviennent une sorte d'illustration voire un document publicitaire : ce type de document a connu une grande vogue dans les années fastes de la haute fidélité13. Il existe néanmoins des courbes de réponse relativement simples à comprendre et à interpréter : les courbes par tiers d'octave. Elles tentent de correspondre aux réelles capacités auditives de l'oreille humaine.

Relever et tracer la courbe de réponse d'une enceinte a longtemps été une opération complexe, souvent longue et faisant appel à un matériel onéreux avec, si possible, une chambre anéchoïque. La disponibilité d’ordinateurs puissants et peu onéreux et le traitement numérique du signal, ont sensiblement changé les choses : les mesures font typiquement appel à un ordinateur associé à une interface et un logiciel spécialisé (certains sont gratuits). Un tel système permet de réaliser (sous certaines conditions et dans certaines limites) des mesures comparables à celles obtenues dans une chambre anéchoïque avec une grande rapidité14.

Impédance

Courbe d'impédance d'une enceinte acoustique.L'impédance est une caractéristique essentielle d'une enceinte acoustique. Elle s'exprime en ohms. Elle doit être connue (du moins approximativement) pour une bonne adaptation à l'amplification utilisée. Pour cela, les constructeurs spécifient une impédance normalisée ou impédance nominale pour leurs enceintes acoustiques. Les valeurs les plus courantes sont de 4 et 8 Ω mais d'autres valeurs sont possibles. En principe, les spécifications de l'amplificateur utilisé indiquent quelles valeurs d'impédances sont acceptables : c'est l'impédance de charge. Il ne s'agit, en aucun cas, d'une adaptation d'impédances mais d'indiquer une compatibilité entre équipements.

En réalité, l'impédance d'une enceinte acoustique est une donnée complexe qui ne se résume pas à un seul chiffre. En effet, l'impédance ou, plus exactement, le module d'impédance varie avec la fréquence. Pour l'étude d'une enceinte acoustique, on relève donc sa courbe d'impédance, la variation de l'impédance en fonction de la fréquence. Cette courbe permet d'obtenir un certain nombre de renseignements techniques, de vérifier que certains défauts de construction ont été évités mais aussi de déterminer la valeur qu'il conviendra d'indiquer pour l'impédance nominale.

Rendement et efficacité

Le rendement d'une enceinte exprime le rapport entre la puissance acoustique délivrée et la puissance électrique consommée. Le rendement s'exprime en % et se calcule de la manière suivante : Rendement = Puissance acoustique délivrée/Puissance électrique absorbée. Dans les faits, le rendement est fort rarement mesuré et utilisé car sans beaucoup d'utilité pratique. Dans le langage courant, il est fréquent de constater une confusion entre rendement et efficacité, le « rendement » indiqué étant en fait l'efficacité. Le rendement des enceintes se situe généralement entre 0,3 et 3 %15. Il convient de noter que ce rendement est variable suivant la fréquence de mesure ce qui complique son appréciation, sans tenir compte d'autres paramètres plus complexes. Son utilité et son appréciation ne sont donc pas du domaine grand public mais réservés aux ingénieurs et chercheurs.

L'efficacité (parfois appelée à tort sensibilité) indique la pression acoustique (en dB SPL) obtenue à 1 m quand on applique une tension de 2,83 V à l'entrée de l'enceinte (2,83 V sur une impédance nominale de 8 Ω soit une puissance de 1 W : P = U2/R = 2.832/8 = 1 W). Elle est généralement indiquée sous la forme : dB/2,83 V/1 m car les amplificateurs audio sont assimilables à des générateurs de tension et il est possible de ne pas tenir compte de l'impédance donc de la puissance réellement absorbée. Là encore la mesure est une opération complexe, le résultat pouvant être influencé par de nombreux paramètres comme le signal utilisé pour la mesure.

Bien que l'expression précédente soit la plus correcte sur le plan technique, l'efficacité est souvent exprimée en dB/1 W/1 m : pression acoustique en dB SPL, pour une puissance absorbée de 1 W, la pression étant mesurée en champ libre à 1 m de distance. Dans la pratique, la puissance réellement absorbée est très rarement mesurée et cette expression est trompeuse.

Connaissant l'efficacité, l'impédance de l'enceinte et la tension appliquée, il est possible de calculer le niveau de pression acoustique à 1 m : Pression en dB SPL = sensibilité + (10logU2/Z), U étant la tension et Z l'impédance. Pour d'autres distances il faut retrancher 20*log(distance en mètres). Ceci vaut uniquement pour un rayonnement sphérique en champ libre, soit 4 pi stéradian et correspond à 6 dB d'atténuation à chaque fois que la distance double. Il s'agit donc de valeurs théoriques, le plus souvent assez éloignées des valeurs pratique qui dépendent des réflexions dans l'environnement de l'enceinte.

Par exemple, si l'on applique un signal d'une amplitude 32 volts efficaces à une enceinte ayant une efficacité de 90 dB/1 W/1 m et une impédance nominale de 8 Ω, la pression à 1 m sera 90 + 10*log (322/8) = 111 db SPL. À 7 m, la pression sera 111 - 20*log 7 = 94,1 dB SPL. Insistons sur le fait qu'il s'agit d'un calcul théorique, les conditions de champ libre n'étant jamais réunies dans le monde réel.

L'efficacité des enceintes acoustiques s'étage en général entre 85 dB et 105 dB. La plupart des modèles grand public ont une efficacité qui environne 90 dB/2,83 V/1 m.

Directivité

Diagrammes de directivité pour six fréquences d'une enceinte colonne Bosch.Il est aisé de constater, en se déplaçant par rapport à l'axe de diffusion d'une enceinte, que le son se modifie au fur et à mesure qu'on s'éloigne de cet axe. Une mesure de la réponse en fréquence en dehors de l'axe permet de constater qu'elle est différente du résultat obtenu dans l'axe. Cette modification est plus ou moins importante suivant la conception de l'enceinte. Elle se traduit généralement par une diminution progressive du niveau de l'aigu (car la directivité augmente avec la montée en fréquence) mais d'autres modifications sont possibles. Ce phénomène fait que l'écoute n'est vraiment conforme aux attentes que sous un angle donné par rapport à l'axe ; pour cette raison il est préférable que l'auditeur soit placé le plus en face possible des enceintes.

La directivité est rarement indiquée pour les enceintes grand public mais fait partie des spécifications essentielles des modèles professionnels. Le constructeur indique l'angle sous lequel l'enceinte est utilisable, et avec quel niveau d'atténuation. Il ne s'agit là que de la directivité horizontale mais un phénomène similaire se produit dans l'axe vertical : la directivité est donc indiquée sous les deux angles. Par exemple 60° × 40° : soixante degrés horizontalement et quarante degrés verticalement, pour une atténuation de 6 dB par rapport à la réponse dans l'axe.

Niveau sonore maximal

Niveau sonore obtenu pour une enceinte offrant une efficacité de 90 dB/1 W/1 m et une puissance maximale de 100 W. La zone rouge indique le risque de destruction de l'enceinte.Le niveau sonore maximal à 1 mètre, parfois appelé par abus de langage « SPL max », n'est pratiquement jamais indiqué pour les enceintes grand public mais est un élément important pour les enceintes professionnelles, pour le cinéma ou le home cinéma. Il permet en effet à l'utilisateur d'évaluer et éventuellement de calculer s'il disposera d'un niveau sonore conforme à ses besoins. Le niveau maximal théorique pouvant être obtenu peut être calculé à partir de l'efficacité et de la puissance admissible, cependant d'autres facteurs interviennent dans le niveau effectivement fourni, par exemple la directivité et la compression thermique. La valeur calculée n'est donc pas exacte en pratique. L'indication du niveau maximal est donc une sorte d'engagement du constructeur permettant à l'utilisateur une évaluation rapide des possibilités offertes dans ce domaine.

Nombre de voies

Une enceinte trois voies, dont les trois haut-parleurs du bas sont réservés au graves.Pour reproduire correctement l'ensemble du spectre audible, un seul haut-parleur se révèle peu performant. On est donc conduit à utiliser plusieurs haut-parleurs dans une même enceinte acoustique, chacun spécialisé dans une partie du spectre audible : grave, médium, aigu. Chaque division du spectre est appelé voie, la division étant réalisée par un filtre : on obtient ainsi couramment des enceintes deux voies (minimum de deux haut-parleurs) ou trois voies (minimum de trois haut-parleurs). Il peut exister un plus grand nombre de voies (quatre ou plus) mais ces formules complexes sont rares.

Il faut remarquer que le nombre de haut-parleurs et le nombre de voies ne sont pas forcément identiques : par exemple une enceinte peut utiliser plusieurs haut-parleurs (généralement identiques) pour la restitution d'une même voie (voir image ci-contre). Cette technique est souvent utilisée pour la restitution du grave afin de permettre, par exemple, l'utilisation de haut-parleurs de faible diamètre sans que le niveau sonore ne devienne trop faible.

Le dernier type de filtrage est la « demi-voie », la configuration la plus courante étant deux voies et demie. Le principe consiste à utiliser deux haut-parleurs identiques pour la voie basse du spectre, l'un des deux haut-parleurs étant filtré par un passe-bas avec une fréquence de coupure plus précoce que l'autre. L'objectif est d'améliorer le niveau dans le grave tout en évitant les interférences entre deux transducteurs dans le médium.

Passives / actives

Chaque haut-parleur ne doit recevoir que la plage de fréquences qui lui est destinée. Pour cela, on peut filtrer le signal soit avant l'amplification (filtrage dit actif) soit après l'amplification (filtrage dit passif). Dans tous les cas, l'amplification peut être intégrée dans l'enceinte (dite alors active) ou non (passive). Pour cela on peut répartir en cinq grandes familles les enceintes :

- les enceintes passives (avec un filtre passif intégré). Elles ne nécessitent que l'arrivée d'un signal sonore amplifié ;

- les enceintes passives avec filtrage externe. Elles nécessitent donc l'utilisation d'un filtre actif, travaillant sur le signal niveau ligne, c'est-à-dire avant même l'étage d'amplification (qui est externe également). Par exemple, un crossover divise le signal et route le sous-signal basses-fréquences vers un canal de l'amplificateur pour reproduction par un subwoofer passif, puis le sous-signal hautes-fréquences vers un autre canal de l'amplificateur pour reproduction par des enceintes passives dites satellites ;

- les enceintes actives (avec filtre actif interne). Elles intègrent l'amplification et le filtrage actif dans le coffret et nécessitent donc une alimentation électrique. L'entrée audio s'effectue au niveau ligne. Suivant le nombre de voies, cela donne les terminologies suivantes : deux voies = bi-amplifiée, trois voies = tri-amplifiées, etc. Chaque voie possède une amplification dédiée. Il existe toutefois des enceintes actives possédant une partie passive. Par exemple une enceinte trois voies bi-amplifiée utilisant un filtrage passif entre médium et aigu ;

- les enceintes actives (avec filtre passif interne). Ici l'amplification et le filtrage sont toujours intégrée à l'enceinte mais le filtrage s'effectue sur le signal amplifié ;

- les enceintes actives avec filtrage externe. Ces enceintes peuvent posséder des amplificateurs intégrés au coffret ou utiliser une amplification externe. Tout comme les enceintes passives avec filtrage externe, ce type d'enceinte est principalement utilisé dans le domaine professionnel (sonorisation).

Filtre passif

Filtre passif complexe d'une enceinte acoustiqueJusqu'à une date relativement récente[Quand ?], la très grande majorité des enceintes acoustiques utilisaient un filtrage passif. Ce filtre, inséré entre l'entrée de l'enceinte et les haut-parleurs assure la répartition des fréquences sonores vers les haut-parleurs aptes à les restituer. Il se compose principalement de condensateurs, d'inductances et de résistances mais peut intégrer d'autres composants, en particulier pour la protection des transducteurs contre les excès de puissance. Le tout peut être soudé sur un circuit imprimé, câblé de façon traditionnelle, voire directement inséré sur le câblage interne de l'enceinte pour les réalisations les plus simples.

Le filtre passif d'une enceinte acoustique peut être très simple, se limitant à un condensateur en série sur le tweeter pour une enceinte deux voies. Dans ce cas, il constitue une cellule passe-haut à 6 dB/octave, le boomer n'étant pas filtré et voyant sa réponse s'atténuer naturellement dans le haut du spectre sonore. Ce type de filtrage est courant en entrée de gamme. Les filtres plus élaborés comportent généralement une cellule par voie, utilisant plusieurs composants afin d'obtenir des pentes de 12 dB/octave (deuxième ordre) ou 18 dB/octave (troisième ordre). Le filtre peut également intégrer des cellules de correction pour le transducteur employé. Le résultat devient assez rapidement complexe, aussi les filtrages très élaborés sont de plus en plus réalisés en actif. En effet, le filtrage passif est de plus en plus délicat à réaliser et les inductances nécessaires coûteuses au fur et à mesure que la fréquence de filtrage diminue. Pour cette raison, les caissons de grave sont presque exclusivement réalisés avec un filtrage actif.

Contrairement à ce que l'on pourrait penser, le filtrage passif ne concerne pas que les enceintes multivoies. Sur une enceinte une voie (généralement équipée d'un seul haut-parleur large bande), il est possible d'intégrer un filtre passif destiné à améliorer la réponse en fréquence du haut-parleur utilisé. Naturellement, l'opération s'effectue aux dépens de l'efficacité mais lorsque ce dernier point n'est pas critique cette technique peut apporter une amélioration sensible de la qualité sonore.

Connectique

Pour raccorder une enceinte acoustique à une source de signal audio, elle est munie d'un ou plusieurs connecteurs. Ces connecteurs diffèrent (du moins en principe) suivant qu'il s'agit d'une enceinte passive ou amplifiée. Dans le premier cas il s'agit de pouvoir transmettre une puissance qui peut être importante (plusieurs centaines de watts) et une tension élevée, éventuellement dangereuse. Dans le second la puissance est négligeable et la tension faible : les exigences sont très différentes. Par ailleurs, suivant l'utilisation prévue de l'enceinte (écoute domestique grand public, installation de sonorisation fixe, sonorisation mobile, musiciens), les connecteurs et les qualités requises varient fortement.

Enceintes passives

Connexions par bornes à pression (en sortie d'amplification)Connexions par bornes vissantes acceptant les fiches banane et par jack 6,35 mmLes enceintes passives, destinées à être raccordées à une amplification de puissance, doivent utiliser des connecteurs capables de transmettre de la puissance sans pertes sensibles et assurer une bonne sécurité à la fois pour l'utilisateur et pour le matériel (pas de risque de court-circuit).