-

-

-

-

-

Clavier d'ordinateur

Pour les articles homonymes, voir clavier.

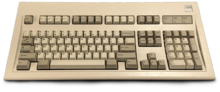

Clavier d’ordinateurClavier intégré sur un ordinateur portable.Caractéristiques Date d'invention Années 1960 Se connecte via PS/2, USB, DIN, ADB Un clavier d’ordinateur est une interface homme-machine munie de touches permettant à l'utilisateur d'entrer dans l'ordinateur une séquence de données, notamment textuelle.

Les touches sont généralement des boutons en plastique reliés chacun à un interrupteur électronique. D'un point de vue électronique, elles sont similaires aux boutons d’une souris, d’une télécommande ou d’une manette de console de jeu, mais d'un point de vue pratique, elles ont des qualités propres à leur fonction : un symbole, une lettre, un chiffre, un mot ou une image sont habituellement imprimées ou gravées sur la touche, afin de permettre à l'utilisateur de saisir les caractères, pour écrire du texte ou pour exécuter une fonction particulière.

Les claviers peuvent aussi être virtuels ou tactiles.

Un clavier est parfois accompagné de pédales, de la même manière que peut l’être le clavier d’un instrument de musique[Interprétation personnelle ?].

Afin d'assurer une certaine familiarité des usagers avec les différents modèles de clavier, ceux-ci sont l’objet de plusieurs normes1.

La technique de frappe au clavier se nomme dactylographie. Pour une meilleure efficacité, un dactylographe vise à utiliser tous ses doigts.

Histoire[modifier | modifier le code]

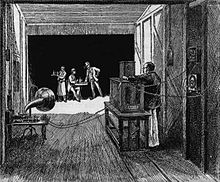

Au début des années 1960, les premiers claviers informatiques apparaissent, en même temps que les premiers systèmes d'exploitation utilisés en ligne de commande. Pour ne pas dérouter les utilisateurs, ces claviers se sont inspirés de ceux des téléscripteurs et des machines à écrire, qui se répartissaient en quatre classes :

- Terminaux à boules (la frappe au clavier fait tourner une boule portant les différents caractères qui s'impriment), avec ou sans mise en tampon d'une ligne de texte avant envoi (exemple : IBM 2741 (en)) ;

- Appareils de type télétype, avec ou sans lecteur-perforateur de ruban (exemple : ASR33, KSR33 (en)), très robustes, mais beaucoup plus bruyants, et lents (typiquement, 500 ms entre la frappe d'une touche et l'impression du caractère en mode local, parfois le triple en mode échoplex) ;

- Écrans associés à un tampon mémoire ;

- Claviers (couplés à des écrans « plein écran » ; full-screen), dont certaines touches ou combinaisons de touches sont programmables (exemple : série IBM 327x).

Vers la fin des années 1970, les claviers sont déclinés en fonction des pays, par les grands constructeurs ou des entreprises locales (il n'en coûtait que le gravage d'une ROM et la sérigraphie de quelques touches).

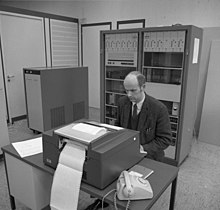

À la fin des années 1970 et au début des années 1980, le clavier est intégré au boîtier de l'ordinateur personnel qui contient l'unité centrale, chaque fabricant élaborant sa propre disposition des touches.

En 1981, l'IBM PC d'IBM reprend le clavier pré-existant de 83 touches, le Modèle F d'excellente qualité mécanique, mais dont la disposition des touches s'avère peu pratique2. Trois ans plus tard, pour le PC/AT, lui succède le Modèle F à 84 touches avec une disposition plus proche du standard actuel. Le clavier modèle M (commercialisé sous le nom d'« Enhanced Keyboard », « clavier amélioré » en français) à 101-106 touches suivra en 1985-19863.

La configuration de la plupart des claviers informatiques et bureautiques européens 105 touches est régie par la norme ISO 9995. Cette norme est initiée en 1984 par l'Association française de normalisation (AFNOR) sous la direction de Bernard Vaucelle, à la demande d'Alain Souloumiac4. La démarche est menée à son terme au sein de l'Organisation internationale de normalisation (ISO) sous la direction d'Yves Neuville5 qui propose une répartition des touches, comprenant le bloc alphabétique et des zones de blocs logiques : diacritique, lettres accentuées, ponctuation, numérique, arithmétique et informatique.

L'étude menée grâce au financement du ministère de l'Industrie français et l'Agence nationale d'amélioration des conditions de travail a permis une amélioration sensible des claviers bureautiques et informatiques.[réf. nécessaire] Les préconisations du rapport d'Yves Neuville5 sont adoptées lors d'une réunion de l'ISO à Berlin et sont immédiatement reprises par tous les constructeurs de compatibles PC.

Aujourd'hui, de nombreux autres types de claviers existent :

- claviers téléphoniques ;

- claviers tactiles ;

- pavés numériques optimisés pour la saisie des nombres ;

- claviers en forme de manette de jeu[réf. souhaitée] ;

- pédales pour faciliter la saisie du texte[Interprétation personnelle ?] ;

- etc.

L'industrie utilise des modèles très variés sur les machines-outils assistées par ordinateur : ce sont généralement de grands pavés de touches disposées en matrice et programmées pour des tâches spécifiques.

Principes de fonctionnement[modifier | modifier le code]

D'une façon simplifiée, l'appui sur une touche émet un code (appelé scan code) qui est récupéré par l'ordinateur ; le système d'exploitation associe ce code à un caractère, qui est par exemple affiché à l'écran si l'utilisateur utilise un traitement de texte. Un code peut aussi être associé à une action, par exemple l’augmentation ou la diminution du volume sonore. La gestion logicielle du clavier et de ses touches est spécifique à chaque système d’exploitation.

La partie électronique des claviers comprend en général un microcontrôleur, qui envoie les scan codes, qui filtre les éventuels rebonds (en), et qui contrôle l'allumage ou l'extinction des voyants du clavier.

Types de claviers[modifier | modifier le code]

Sinclair 48K ZX Spectrum, clavier chiclet aux touches caoutchouc.

Sinclair 48K ZX Spectrum, clavier chiclet aux touches caoutchouc. IBM : clavier modèle M.

IBM : clavier modèle M.La typologie des claviers correspond à diverses caractéristiques portant sur la technologie de détection de la frappe, la disposition des touches, leur géométrie, les caractéristiques visuelles et tactiles…

- Technologies de frappe. La détection de l'appui sur une touche peut être :

- à membrane : un clavier à membrane, ou clavier souple, est constitué de multiples couches de polyester imprimées, qui constituent le décor et les différents circuits : l'appui sur une touche va déformer une première membrane qui va entrer en contact avec une membrane située en dessous ; la connexion électrique permet, finalement, d'obtenir le code désiré ;

- à interrupteur mécanique : la première technologie de clavier mécanique est connue sous le nom buckling spring : l’appui d’une touche comprime un ressort jusqu'à un point critique où celui-ci sort brutalement de son axe ; ce comportement, où le ressort plie au lieu de continuer à se comprimer, est appelé « flambage » (anglais : buckling) et n'a rien d'aléatoire6 ; un interrupteur est actionné après dégagement latéral du ressort, ce qui permet d'envoyer un signal électrique et, finalement, de produire le code désiré. IBM a popularisé cette technologie dans les années 1980 avec ses modèles F puis avec ses modèles M7.

- à course « linéaire »[réf. nécessaire] quand une touche semble ne rencontrer aucun obstacle lors de la frappe ;

- à course « sensitive »[réf. nécessaire] quand une légère halte et un clic audible marquent la transition entre l'appui qui ne fait rien et l'appui qui provoque l'activation.

- optique : l’absence de pièces mécaniques assure à ce type de dispositifs une meilleure longévité, ainsi qu’une réduction de certains bruits électromagnétiques permettant de « lire » les touches utilisées à distance, surtout si couplé à une transmission optique[C'est-à-dire ?] ;

- logicielle : avec un clavier virtuel, les touches sont déclenchées indirectement par un dispositif de pointage (tel une souris ou un écran tactile), via le système d’exploitation.

- La plupart des claviers ne gèrent pas correctement la pression simultanée de certaines combinaisons de touches, par exemple trois touches alphabétiques. Dans ce cas, des touches pressées peuvent être ignorées, ou des touches peuvent être à tort considérées comme pressées. Ce phénomène de touches fantômes (en) est causé par un circuit électronique en grille. Il s’agit d’un problème bénin pour un usage bureautique — où l’usager presse rarement deux touches à la fois, hormis pour des raccourcis avec touches modificatrices — mais significatif pour certains jeux vidéos, où effectuer trois voire quatre actions simultanées n’est pas rare. Certains claviers dits anti-ghosting ou NKRO (pour l’anglais n-key rollover) proposent de résoudre ce problème en détectant individuellement chaque touche. Ces claviers sont typiquement plus chers, leur câblage étant plus complexe.

- Forme et agencement du clavier. Diverses altérations de l’agencement spatial des touches, ou de la disposition des caractères sur ces touches, peuvent améliorer considérablement l’ergonomie du clavier (voir les sections « #Disposition des touches » et « #Ergonomie et accessibilité ») :

- clavier chiclet : les touches sont espacées les unes des autres pour éviter des frappes multiples ;

- clavier matriciel : les touches sont disposées en grille plutôt qu’en quinconce8 ;

- clavier scindé : les touches sont réparties en deux blocs (un pour chaque main), qui sont soit fixés sur le même support mais orientés différemment (formant un V), soit sur des supports indépendants ; au sein d’un bloc, les touches peuvent être disposées en éventail ;

- clavier muni d’un coussinet repose-poignets ;

- disposition ergonomique des caractères : la répartition des caractères sur le clavier est optimisée pour la saisie d’une langue donnée (dispositions Dvorak pour l’anglais, BÉPO pour le français…) ;

- disposition accessible[C'est-à-dire ?].

- Les dimensions horizontale (distance entre le bord gauche de la touche Q et le bord droit de la touche M sur un clavier AZERTY) et verticale (distance entre le haut de la rangée numérique et le bas de la dernière rangée alphabétique) du clavier sont également des mesures importantes, bien que rarement indiquées. Quand on est amené à travailler sur plusieurs machines, si les claviers de celles-ci ne sont pas de dimensions similaires, les fautes de frappe se multiplient.[réf. nécessaire]

- Forme et matière des touches. Les touches peuvent revêtir différentes formes :

- touches souples ou gommées ;

- touches dures ;

- touches plates, sphériques, ovoïdes…

- La pression sur une touche s'exprime en centinewton (cN) ; un centinewton équivalant environ au poids d’un objet ayant une masse d’un gramme, la pression nécessaire pour enfoncer une touche est aussi notée en grammes.

- Aide visuelle. Un clavier peut signaler à son utilisateur la fonction de chaque touche par divers moyens :

- caractères sérigraphiés ou gravés sur les touches ;

- rétro-éclairage du clavier améliorant l'utilisation en environnements sombres ;

- touches pouvant s'allumer de plusieurs couleurs en fonction de leur état ou de leur utilité courante (par exemple lors d’un jeu vidéo) ;

- touches disposant d’un affichage LCD pour expliciter leur fonction courante ;

- LED d'activation reflétant l'état actuel du clavier (verrouillage des majuscules, du pavé numérique, langue en cours d’utilisation…).

- Touches de fonction. La plupart des claviers d’ordinateurs actuels présentent des touches de « fonction » associées à des actions plutôt qu’à des caractères, qui améliorent l'ergonomie (réduction de la nécessité de basculer du clavier vers un autre mode d'interaction) :

- touches « multimédia » permettant de contrôler le son, les pistes sonores ou vidéo ;

- touches « bureautique » permettant de lancer diverses applications usuelles ;

- touches spécifiques (défilement, zoom…) ;

- touche « souris » permettant de déplacer le curseur sans repasser par la souris.

- Connectique. La connectique est aussi un élément caractéristique des claviers, puisque ceux-ci doivent communiquer avec le système qui les utilise (voir la section « #Connectique »).

Disposition des touches[modifier | modifier le code]

Généralités[modifier | modifier le code]

Les claviers se caractérisent par leurs particularités techniques (touches muettes) et surtout nationales (caractères spécifiques, disposition…). Il existe de nombreuses dispositions des touches (AZERTY, QWERTY, QWERTZ, Dvorak, BÉPO, etc.), chacune pouvant avoir des variantes. Ainsi, l’AZERTY français n’est pas le même que l’AZERTY belge, et le QWERTZ allemand n’est pas le même que le QWERTZ suisse.

Claviers des compatibles PC[modifier | modifier le code]

Les claviers pour compatibles PC sont les plus répandus. Les modèles successifs de claviers pour ces ordinateurs ont été :

- le clavier modèle F XT (83 touches), équipant l'IBM PC/XT (1981) ;

- le clavier modèle F AT (84 touches), équipant l'IBM PC/AT (1984) : par rapport à son prédécesseur (avec lequel il était électroniquement incompatible), il séparait nettement les pavés alphabétique et numérique, et ajoutait une touche SysReq et trois diodes d'état (Verrouillage numérique, Verrouillage majuscules et Arrêt de défilement) ; il comprenait donc 10 touches F1 à F10 à gauche, 56 touches au centre, 18 touches de pavé numérique à droite ;

- le clavier modèle M (de 101 à 106 touches), équipant l'IBM PS/2 (1987) : les touches F1 à F12 passent en haut du clavier, les touches Ctrl et Alt sont dupliquées et placées sur la ligne du bas, la touche Verrouillage majuscules prend la place de l'ancienne touche Ctrl, la touche Échappement est déplacée du pavé numérique vers le coin supérieur gauche, et un pavé de flèches et un pavé de fonctions sont ajoutés à droite du bloc alphabétique, à gauche du pavé numérique ; ce modèle de claviers s'est décliné en plusieurs variantes, qui font l'objet de normes :

- le clavier américain, dit « ANSI » (101 touches) ;

- les claviers européens, dits « ISO » (102 touches) : ils ajoutent une touche à droite de la touche Maj de gauche, remplacent la touche Alt de droite par AltGr et changent la forme de la touche Entrée ;

- le clavier coréen (103 touches) : il ajoute deux touches autour de la barre d'espace et change la forme de la touche Entrée ;

- le clavier brésilien, dit « ABNT » (104 touches) : il ajoute une touche à droite de la touche Maj de gauche, une à gauche de la touche Maj de droite, et une sur le pavé numérique, et change la forme de la touche Entrée ;

- le clavier japonais, dit « JIS » (106 touches) : il ajoute une touche à gauche de la touche Retour arrière, une à gauche de la touche Maj de droite, une à gauche et deux à droite de la barre d'espace, et change la forme de la touche Entrée ;

- les claviers pour Windows 95 (1995) : à la sortie de ce système d'exploitation, trois touches sont ajoutées à la ligne de la barre d'espace des claviers modèle M (qui comptent désormais de 104 à 109 touches) : deux touches Windows (équivalant à un clic sur le bouton Démarrer de Windows), et une touche Menu (équivalant à un clic droit de la souris). IBM résiste plusieurs années au mouvement, y compris sur sa série ThinkPad, en jugeant contre-productives les réductions entraînées sur les largeurs des autres touches de la rangée (Majuscule, Alt et barre d'espace), et que Windows 95 s'utilise très bien par combinaison des touches existantes.

En 2018, la plupart des claviers vendus dans le commerce héritent toujours de cette architecture, leurs innovations concernant surtout l'ajout de touches de fonctions dédiées (contrôle du volume audio, raccourcis d'applications…). Les modèles de claviers sous-jacents sont fréquemment identifiés par leur nombre de touches.

Nombre de touches des différents modèles de claviers PC Modèle M avant 1995 Modèles pour Windows 95 (+ 3 touches) Modèles pour Windows 95 sans pavé numérique (− 17 touches) Clavier américain 101 104 87 Claviers européens 102 105 88 Clavier coréen 103 106 89 Clavier brésilien 104 107 89 (le pavé numérique brésilien comptant 18 touches) Clavier japonais 106 109 92 Touches les plus communes[modifier | modifier le code]

Partie gauche d'un clavier : tabulation, verrouillage des majuscules, majuscule, Ctrl, Windows, Alt.

Partie gauche d'un clavier : tabulation, verrouillage des majuscules, majuscule, Ctrl, Windows, Alt.Idéalement, l'utilisateur doit pouvoir écrire tous les caractères utilisés dans sa langue, que ce soit en appuyant sur une seule touche ou par combinaison de plusieurs touches ; cette commodité n'est pas forcément des plus faciles. En général, les touches les plus représentées sont :

- Touches de saisie de texte

- A, B, C, Б, Λ, etc. → Lettres courantes sans diacritique des différents alphabets (latin, cyrillique, grec, etc.)

- é, à, ç, ą, ß, etc. → Lettres avec diacritiques (accents, cédille, ogonek, etc.), caractères spécifiques d'un alphabet (ex. : eszett) (disposition variable en fonction des langues)

- :, !, §, €, etc. → Ponctuation, caractères spéciaux, symboles (disposition variable en fonction des langues)

- 1, 2, 3, etc. → Chiffres

- +, -, *, / → Opérateurs mathématiques

- Entrée ou Enter ou ↵ → Touche d'entrée

- Insert ou Inser ou Ins → Touche d'insertion

- Suppr. ou Delete ou Del. → Touche de suppression

- Tab ou ↹ → Touche de tabulation

- ← → Retour arrière, Effacement

- Espace ou Space bar ou Blanc → Barre d'espace, barre d'espacement

- / → Slash, barre oblique

- \ → Backslash, barre oblique inversée, contre-oblique

- - → Trait d'union, signe moins

- _ → Tiret bas, souligné, underscore

- | → Pipe, vertical bar, barre verticale

- (, ) → Parenthèse ouvrante et parenthèse fermante

- [, ] → Crochet ouvrant et crochet fermant

- {, } → Accolade ouvrante et accolade fermante

- Touches mortes → modifient la prochaine touche enfoncée (par exemple, sur un clavier AZERTY, l'appui sur ^ suivi d'une voyelle, correspond à la voyelle accentuée circonflexe)

- ^, ¨, `, ~, etc. → Accents divers (suivant pays du clavier)

- Compose ou ⎄ → Touche compose (DEC, SUN/Unix)

- Touches de combinaison

- Alt (Option ou ⌥ des Macintosh) → Touche alternative (appelée touche d'option par les utilisateurs Macintosh)

- Alt Gr → Touche Alternate Graphic(s), remplace la combinaison CTRL+ALT et permet l'accès au troisième signe (en bas à droite) sur une touche

- ◆ META → Touche méta du clavier Knight (en), présente à gauche et à droite à côté des touches Contrôle, équivalentes aux touches Alt et Alt Gr

- Contrôle ou Ctrl → Deux touches Contrôle présentes à gauche LCtrl et à droite RCtrl

- Maj ou Shift ou ⇧ → Touche majuscule à gauche LShift et à droite RShift, permet l'accès au deuxième signe (en haut) d'une touche ou la majuscule d'une lettre

- HYPER → Touche hyper du clavier space-cadet (en)

- SUPER → Touche super du clavier space-cadet (en), équivalente à la touche Logo

- Logo → Touche logo

- sur Windows ⊞ Win → Menu démarrer (ou autre fonction si combinée avec une autre touche)

- sur Apple ⌘ → Touche de commande

- Fn → Touche de fonction, permet l'accès à une fonction ou signe indiqué sur une autre touche, généralement de la même couleur (ne pas confondre avec les touches F1, F2, etc.)

- Touches directionnelles et de défilement

- Début ou Home ou ⇱ → Touche de début

- Fin ou End ou ⇲ → Touche de fin

- ↑ Up, ↓ Down, ← Left, → Right → Flèches directionnelles haut, bas, gauche, droite

- ⇞ ou Page Up, et ⇟ ou Page Down → Touche page précédente et page suivante

- Touches de verrouillage

- Arrêt défil ou Scroll Lock → Touche d'arrêt du défilement

- Verr num ou Num Lock → Touche de verrouillage du pavé numérique

- Verrouiller maj ou Caps Lock → Touche de verrouillage des majuscules

- Touches système

- F1, F2… jusqu'à F12 → touches de fonction (reprises des claviers de mainframes, où elles occupaient la place du pavé numérique, en 4 lignes de 3).

- Attn ou Pause ou Break → Touche pause pour stopper l'affichage et touche break (accès par combinaison Ctrl+Pause) pour stopper un programme

- Echap. ou Esc → Touche d'échappement

- Impr. écran ou Print Scrn ou ImpEcr → Impression d'écran

- Système ou SysReq ou SysRq → Requête système, accès par combinaison Ctrl+Impr. écran

- Logo → Touche logo utilisée soit seule, soit en combinaison

- ≣ Menu ou AppsKey → Menu contextuel (équivalent du clic droit de la souris)

Spécificités par constructeurs[modifier | modifier le code]

Certains constructeurs ont ajouté des touches à leurs claviers (produisant ainsi des modèles qui dépassent parfois 120 touches) pour offrir davantage de fonctions. Les ajouts les plus courants incluent

- un contrôle direct de l’alimentation (allumage, extinction, mise en veille, réveil),

- un contrôle de l’affichage (zoom, luminosité, contraste, etc.),

- des fonctions multimédias (volume sonore, mode muet, lecture ou pause, activation ou désactivation du microphone, etc.),

- des raccourcis d’applications (navigateur, courriel, chat, recherche, calculatrice, etc.),

- des commandes définies par l'utilisateur,

- etc.

Les marques les plus connues ont aussi ajouté des éléments spécifiques.

- Les claviers Apple disposent de deux touches Commande (appelées également touches Pomme ; équivalent de la touche méta des PC) de part et d’autre de la barre d'espace, et de deux touches Option (équivalent de la touche Alt), situées de part et d'autre des touches Commande ; la touche Ctrl, absente sur les premières générations de claviers, sert peu à la frappe ; sous Mac OS 8 et 9, elle faisait apparaître un menu contextuel (les souris Apple n'ayant à l'époque qu'un seul bouton). L'utilisateur peut saisir tous les diacritiques et ligatures utilisés en français : des touches mortes permettent d'accentuer les majuscules (accent circonflexe, tréma, accent grave à droite du « ù », accent aigu obtenu par la combinaison Alt + Maj + &), tandis que les combinaisons Option + a, Option + o et Option + ç donnent respectivement « æ », « œ » et « Ç ».

- Compaq et Apple ont fabriqué des claviers dont les voyants Verrouillage numérique, Verrouillage majuscules et Arrêt de défilement se trouvaient intégrés aux touches (plutôt qu'installés à part).

- Microsoft a ajouté deux touches Windows, qui ouvrent le « menu Démarrer » de son système d’exploitation et s'utilisent pour des raccourcis claviers, et une touche Menu, équivalant au clic sur le bouton droit de la souris ; les ordinateurs IBM ThinkPad n’avaient pas, jusqu’en 2006 et leur série 60, de touche Windows ; ainsi, il n’existe pas réellement de clavier Windows, même si plusieurs claviers de PC disposent de une à trois touches Windows.

- Sun a entre autres disposé un bloc de 10 touches sur la gauche, dont l'une sert à copier la sélection et une autre à coller (mécanisme de copier-coller) ; une touche Compose permet d’entrer des caractères spéciaux, notamment les caractères accentués de l’alphabet latin, en utilisant des combinaisons telles que Compose + o, puis e pour obtenir « œ », ou Compose + e puis ' pour « é ». Ce système, très répandu sur les machines tournant sous Unix telles que les stations Sun, est également mis en œuvre de façon logicielle sous Linux9.

Les claviers de type IBM se distinguent de ceux de type Unix par la séparation des touches de caractères (lettres, accents, chiffre, etc.) et des touches de fonction, servant à effectuer des opérations spécifiques ; au départ banalisées (nommés F1, F2, etc. jusqu’à F12), ces dernières ont progressivement été complétées par 13 touches débanalisées (trois touches système, un bloc de défilement (Insertion, Suppression, Origine, Fin, Page précédente, Page suivante), et quatre touches fléchées).

Spécificités par système d'exploitation[modifier | modifier le code]

Les systèmes d'exploitation ne permettent pas toujours de saisir correctement tous les caractères ; par exemple, pour certaines dispositions de clavier sous Windows, il n’existe pas de façon directe de faire un « É ». C’est le cas de la disposition AZERTY française de base, tandis que l’AZERTY belge, le clavier canadien multilingue standard ou le BÉPO le permettent. Il est en outre généralement difficile d'écrire directement les guillemets français (« »), l'apostrophe typographique « ’ », le e dans l’o « œ » ainsi que les tirets cadratins « — » avec les dispositions de clavier les plus courantes.

Le comportement du clavier peut être modifié après création et installation de nouveaux pilotes de clavier. Pour Windows, il existe à cet effet le logiciel Microsoft Keyboard Layout Creator (MSKLC)10 et des alternatives open source, portables et fonctionnant sans droits d'administrateur11,12.

Connectique[modifier | modifier le code]

Les claviers d'ordinateurs peuvent soit être intégrés à l'ordinateur, soit utiliser différents types de connectique pour être raccordés à la machine :

- ADB : pour les ordinateurs Mac, jusqu'à la fin des années 1990 ;

- DIN : 5 broches de raccordement + blindage rond, que l’on pouvait rencontrer sur les claviers des premiers PC (PC/G, PC/XT et PC/AT) et qui a complètement disparu ;

- PS/2 : 6 broches de raccordement + blindage rond ; apparu en 1987, il a remplacé le connecteur DIN dans les années 1990 ; seule la connectivité physique étant modifiée (assurant la compatibilité électrique), des adaptateurs permettaient une interconnexion dans un sens ou dans l’autre ;

- USB : rectangulaire à quatre broches + blindage ; omniprésent sur tous les ordinateurs depuis 1998, il a remplacé le connecteur PS/2 dans les années 2000 et permet d'ailleurs de relier à l'ordinateur la quasi-totalité des périphériques actuels. Étant tributaire du polling du contrôleur USB au lieu de fonctionner par interruptions, il est jugé parfois moins réactif que ses prédécesseurs. Par ailleurs les très anciens BIOS n'intègrent pas en ROM la complexe gestion de l'USB (assurée alors par l'OS) et ces claviers sont donc inaptes à intercepter ces anciens BIOS pour en changer les paramètres. Le problème ne se pose pas avec les UEFI.

En outre, différentes technologies sans fil se développent depuis 2004 : infrarouge IrDA (peu utilisé), Bluetooth, liaison radio propriétaire, USB sans fil… ; ces technologies utilisent un émetteur/récepteur bon marché de très faible portée, qui peut être intégré dans ou connecté à l'ordinateur.

Ergonomie et accessibilité[modifier | modifier le code]

Le choix d'un clavier dépend des priorités de l'utilisateur : prix, esthétique, précision des touches, rapidité de la frappe, liberté de mouvement, faible pollution électromagnétique (qui les interdisent dans certains endroits, comme les avions), accessibilité pour personnes handicapées et ergonomie générale. Les formes et les technologies clavier sont donc très différentes : les claviers à membranes sont peu chers à fabriquer ; les claviers mécaniques sont réputés fiables, résistants et précis13 ; les claviers sans fil améliorent la liberté de mouvement (mais le recyclage des piles nécessaires à l'alimentation en énergie provoque une pollution supplémentaire), etc.

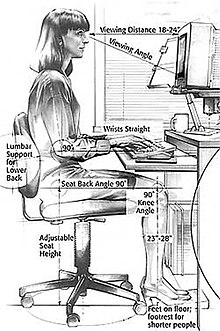

Par contre, l'ergonomie, malgré de multiples travaux, n'a pas beaucoup évolué et les dispositions alternatives restent actuellement peu usitées, malgré la sensibilisation croissante concernant les pathologies pouvant être favorisées par un usage intensif (microtraumatismes, troubles musculosquelettiques, syndrome du canal carpien). Les conseils d'ergonomie générale portent d'abord sur la position au poste de travail :

- la personne assise doit maintenir son dos droit devant l'ordinateur, la tête légèrement penchée vers l'écran (par exemple le haut de celui-ci étant à hauteur de l'œil). On ignore la raison de cette recommandation, personne ne faisant la même dans le cas de la lecture sur papier. Il est admis que le papier puisse se trouver sur le bureau, la lecture se faisant alors vers le bas ;

- les coudes doivent être près du corps et les mains ne pas former d'angle trop marqué avec les bras (d'où les claviers en V) ;

- le milieu de la barre d’espace doit être devant le visage, au milieu, et accessible par les pouces quelles que soient les positions des mains sur le clavier ;

- les huit doigts utilisés doivent se placer, au repos, au centre du clavier, index posés sur les touches repères marquées d'un ergot (pour un clavier azerty : F et J)14.

Plusieurs études ont aussi abouti à des propositions différentes des touches, parfois sévèrement critiquées15 ; pour diminuer la fatigue de la frappe et augmenter sa vitesse, elles prennent en compte la fréquence des lettres dans chaque langue et la physiologie de la main, proposant ainsi les variantes suivantes :

- agencement des touches en trois dimensions (et non dans un plan)16 ;

- alignement des touches en colonnes, pour supprimer le décalage entre les rangées de touches typique de la majorité des claviers actuels17, simple reflet de la nécessité du placement des barres sur les anciennes machines mécaniques. Ils sont dits « droits », alors que les touches ne sont alignées qu'en ligne, les lettres restant décalées en verticale) ;

- orientation courbée des touches (en une espèce de V plus ou moins marqué, avec parfois séparation nette entre touches pour la main gauche et pour la main droite), afin de pouvoir orienter les bras de façon plus naturelle et moins collées au corps, comme le Natural Keyboard de Microsoft ;

- changement de la disposition des touches comme avec la disposition Dvorak, la disposition Colemak, et pour le français : Marsan, Dvorak-fr, disposition bépo, etc.

Enfin, des assistances spécifiques ont été mises en œuvre pour aider les personnes handicapées à se servir d'un ordinateur :

- optimisations pour la saisie avec une seule main ;

- claviers à très peu de touches, fonctionnant par accords (pour le braille notamment) ;

- réduction des rebonds par des filtres logiciels (la fonction « touche filtre » permet d'éviter la répétition d'une lettre en cas d'appui prolongé d'une touche) ;

- développement de logiciels de saisie de texte par reconnaissance automatique de la parole, permettent de limiter l'usage du clavier.

Divers[modifier | modifier le code]

Le caractère « ⌨ » dans le jeu de caractères Unicode symbolise un clavier (U+2328).

Les claviers d'ordinateurs portables sont généralement munis d'un pavé tactile qui sert entre autres à activer le pointeur de la souris.

Les claviers d'ordinateurs sont le réceptacle de nombreux micro-débris (poils, débris de peau, restes de nourriture, etc.).

Des programmes informatiques se montrent capables de deviner si l'utilisateur d'un clavier est masculin ou féminin selon la manière dont les touches N, O et M sont frappées18.

Notes et références[modifier | modifier le code]

- © Gouvernement du Québec, Standard sur le clavier québécois (SGQRI 001) - Foire aux questions, Secrétariat du conseil du trésor du Québec, (lire en ligne [archive]).

- (en) « IBM Model F » [archive], Deskthority wiki.

- (en) « IBM Enhanced Keyboard : History » [archive], Deskthority wiki.

- Rapport Perspectives de l'Informatique dans l'administration, La Documentation française, 1983, p. 72.

- Yves Neuville, Le clavier informatique et bureautique, Cedic-Nathan, 1985.

- Voir Les lois de comportement des ressorts sur Wikibooks

- (en) Information page on the IBM model M keyboard, based on the design of mechanical typewriters [archive]

- (en) « « The Matrix Architecture (straight vertical key columns) increases typing accuracy and decreases wrist distortion » » [archive], sur Typematrix, (consulté le )

- (en) Linux Compose Key Sequences [archive]

- « Personnalisez votre clavier » [archive], 01net, (consulté le ).

- (en) « Portable Keyboard Layout » [archive], SourceForge.net.

- « Divers claviers pour améliorer le pauvre AZERTY » [archive], Site personnel.

- (en) Visual guide expertly explains mechanical keyboard switches [archive] de Geek.com

- Guides et documents en ergonomie de bureau [archive], sur l'espace des ressources humaines de l'Université Laval

- (fr) La fable du clavier [archive], (ISSN 0751-7971) (Titre original : The fable of the keys)

- Claviers Kinesis contoured [archive] ou Maltron [archive]

- Claviers Typematrix [archive], TrulyErgonomics [archive] ou Plum (n'est plus fabriqué).

- Kimberly Hickok (2018) What your keystrokes reveal about your gender [archive] ; O9 février 2018

Annexes[modifier | modifier le code]

Souris (informatique)

Pour les articles homonymes, voir Souris (homonymie).

Souris (informatique)Souris à fil,

avec deux boutons et une molette.Caractéristiques Date d'invention 1963 Inventé par Douglas Engelbart Se connecte via RS232, PS/2, USB, IrDA, Wi-Fi, Bluetooth Une souris est un dispositif de pointage pour ordinateur. Elle est composée d'un petit boîtier fait pour tenir sous la main, sur lequel se trouvent un ou plusieurs boutons, et une molette dans la plupart des cas.

La souris a été inventée en 1963 par Douglas Engelbart du Stanford Research Institute et présentée au public en 1968.

Pendant de nombreuses années les souris informatiques ne communiquaient avec l'ordinateur que par l'intermédiaire d'un fil, ce qui les faisait ressembler à des souris domestiques. Depuis, des modèles dont les communications avec l'ordinateur se font par ondes radio ou par liaisons infra-rouge sont courants.

Les dernières générations de souris offrent maintenant 6 degrés de liberté (avec une coque pivotante1) afin de naviguer plus intuitivement dans les environnements logiciels 3D (conception, médical...).

Souris Bluetooth donc sans fil.

Souris Bluetooth donc sans fil.Historique[modifier | modifier le code]

Le prototype de souris (boitier en bois) de Douglas Engelbart de 1968. Souris à trois boutons et à « boules » du Xerox Alto de 1973.

Souris à trois boutons et à « boules » du Xerox Alto de 1973.La souris a été inventée en 19632,3 et présentée au public en 19684 par Douglas Engelbart du Stanford Research Institute après des tests d'utilisation basés sur le trackball. Le premier ordinateur moderne à utiliser une souris fut le Xerox Alto, en 1973. Il utilisa successivement une souris à boules, puis une souris optique. Elle a été améliorée par Jean-Daniel Nicoud à l'EPFL dès 1979 grâce à l'adjonction d'une boule et de capteurs5,6 ; il fabriqua la souris Depraz qui fut à l'origine de l'entreprise Logitech.

Pendant plusieurs décennies, les souris étaient des trackballs inversées. La friction de la boule contre la table permettait le mouvement du pointeur sur l'écran. Le système mécanique à boule avait tendance à ramasser la poussière de la surface horizontale et à encrasser les rouleaux capteurs, ce qui exigeait un nettoyage interne régulier. L'absence de cet inconvénient dans les souris à capteur optique a expliqué leur succès et la disparition des souris à boule.

Les premières souris à capteur optique nécessitaient un tapis de souris spécial quadrillé.

Depuis 2000, ces dernières ont été progressivement remplacées par des souris optiques ne nécessitant plus ce tapis spécifique7.

Utilisation[modifier | modifier le code]

Pointage absolu et relatif[modifier | modifier le code]

De nombreux systèmes ont été imaginés pour déterminer les actions qui seront effectuées à l'écran : crayon optique, écran tactile, boule, joystick, tablette tactile, molettes diverses, tablette graphique, trackpoint.

Alors que certains d'entre eux donnent un pointage absolu (les écrans tactiles, par exemple), la souris détecte un déplacement. Celui-ci, par sommation, fournit donc une position relative : par exemple, un mouvement de la souris vers la droite provoque un mouvement du pointeur à l'écran vers la droite, indépendamment de la position absolue de la souris sur le plan de travail. Si le pointeur se trouve déjà à droite de l'écran, un mouvement de la souris vers la droite n'aura aucun effet (l'environnement graphique veille en effet à ce que le pointeur ne puisse apparaître que dans des zones autorisées).

La souris ne permettait au départ de fournir que deux informations de position (x et y). Ce dispositif ne convenait donc pas pour un déplacement spatial de précision exigeant trois coordonnées (x, y et z) quand ce n'était pas six (en y ajoutant les trois angles d'attaque). D'autres dispositifs, plus onéreux (ring, bat) ont été créés à cet effet. L'ajout d'une molette à la souris a cependant permis d'ajouter dans une certaine mesure cette troisième dimension qui lui manquait.

Des outils de pointage plus récents et plus abordables complètent la souris au lieu de chercher à la concurrencer.

Tenue en main[modifier | modifier le code]

Une souris se tient le corps dans la paume, les boutons sous les doigts (le fil, s'il y en a un, étant à l'opposé de l'utilisateur). Pour la tenue de la souris de la main gauche, l'index se situe sur le clic droit, le majeur sur le bouton molette centrale et l'annulaire sur le clic gauche. Le pouce et l'auriculaire se placent de chaque côté de la souris. Le mouvement sur la table est reproduit à l'écran. Il est bien de poser les coudes sur les accoudoirs afin de reposer les muscles. L'avant du bras et la main sont alignés et le poignet est non cassé.

Certains spécialistes conseillent de tenir la souris de la main gauche8 car la tension musculaire est plus faible de plus cela libère la main droite pour taper sur le clavier numérique. Quoique les claviers soient loin de tous avoir un pavé numérique (par exemple début 2009, Apple vend des claviers avec ou sans, et exclusivement sans pour les sans-fil), ce qui est le cas de certains ordinateurs portables. Il existe des pavés numériques externes qui peuvent être placés à gauche ou à droite du clavier alphabétique en fonction des préférences de placement de la souris.

Support[modifier | modifier le code]

Il est utile d'avoir un support bien homogène afin que la souris glisse facilement et régulièrement. On nomme ce support un tapis de souris, il peut être en papier, plastique, tissu, etc.

Des plaques de déplacement pour souris, faisant office de « tapis » rigides, furent fournies en standard avec les premières souris optiques au milieu des années 1980, ainsi avec la souris (optionnelle) « 5277 » de l'écran IBM 3179-G pour mainframe : elles étaient métalliques, vernies, et pourvues de cannelures noires permettant à l'électronique de l'époque de suivre le mouvement de la souris.

Le verre et les surfaces brillantes ou trop sombres ne sont pas recommandés pour les souris optiques. Si le pointeur à l'écran ne reproduit pas les mouvements de la souris, il est recommandé de placer une feuille rigide de papier clair sous la souris afin de réfléchir les rayons lumineux.

Souris symétriques et asymétriques[modifier | modifier le code]

Les interfaces graphiques modernes (Windows, Gnome, KDE, etc.) permettent aux gauchers d'inverser les boutons s'ils le désirent : le bouton droit devient le bouton principal, tandis que le bouton gauche devient le bouton accessoire. Il faut toutefois pondérer cet éventuel confort par la perte de généralité de l'interface, qui peut déstabiliser les quelques fois où on travaille sur un autre poste de travail que le sien. Quelques droitiers tiennent leur souris de la main gauche, ce qui est censé provoquer moins de troubles musculo-squelettiques8.

Certaines souris sont symétriques (dont celle d'Apple depuis 19849), se prêtant facilement à l'inversion des boutons (accessible dans la configuration du système), d'autres sont asymétriques, et les gauchers doivent veiller à choisir des souris inverses de celles des droitiers.

Les documentations mentionnant historiquement des boutons gauche et droit, il revient aux gauchers qui ont inversé les leurs d'inverser aussi ces termes.

Souris et handicap[modifier | modifier le code]

Utilisation par les personnes déficientes[modifier | modifier le code]

Certaines souris à retour de force sont conçues pour donner une sensation de résistance ou de dureté :

- lors du franchissement du bord des fenêtres ;

- lors du passage sur une zone cliquable, etc.

Ces souris permettent un usage plus commode par des personnes ayant des problèmes de vue.

Un paramètre du pilote aujourd'hui répandu permet de simuler le clic ou le double-clic au moyen de mouvements saccadés particuliers.

Source de handicap[modifier | modifier le code]

La souris est un accessoire peu dangereux quand le poste de travail est correctement configuré (bras de l'utilisateur à l'horizontale et surtout pas montant, même très légèrement). Comme tout ustensile utilisé intensivement, elle peut provoquer des lésions, en l'occurrence des tendinites. On peut en atténuer le risque en alternant l'usage de la main droite et de la main gauche, ce qui demande cependant un entraînement. Les activités professionnelles exigeant un usage permanent de la souris peuvent induire le syndrome du canal carpien, voire la formation de callosités, ou de capsulite rétractile de l'épaule, et même des déformations de la main et du poignet. Les constructeurs essaient avec plus ou moins de succès des formes de souris plus ergonomiques, existant en version droitier et gaucher.

Selon des chercheurs néerlandais, l'ensemble main/bras ou cou/épaule est affecté de manière proportionnelle au nombre d'heures passées en utilisant la souris, avec un risque plus important pour le bras et la main que pour la région cou/épaule. La souris aurait par ailleurs plus d'impacts négatifs sur la santé que l'utilisation de l'ordinateur sans souris, ou que le seul clavier sans souris11.

Connecteurs de souris[modifier | modifier le code]

Avec fil[modifier | modifier le code]

Les premières souris Macintosh avaient leur propre connecteur ; elles utilisèrent ensuite l'ADB (Apple Desktop Bus).

Les premières souris pour PC utilisaient soit un connecteur sur un port spécifique (VisiCorp), soit un port série (ou port RS-232) ; à partir d', celui-ci commença à être remplacé par le port PS/2. Par la suite ce port a été coloré en vert pour la souris et en violet pour le clavier.

Depuis 1998a, les souris pour Mac et PC sous Windows ou Linux utilisent essentiellement le port USBb ; ce type de connexion devient depuis le standard pour toutes les souris à câble.

Sous Unix, et particulièrement sous les systèmes X-Window, il est parfois nécessaire d'indiquer le périphérique et son protocole au fichier de configuration du serveur X. Ainsi, pour une souris USB, on indiquera le périphérique /dev/input/mice ; pour une souris PS/2 /dev/psaux ; et pour une souris Série /dev/tty0 à tty4 suivant le port.

Sans fil[modifier | modifier le code]

Les technologies actuelles permettent de s'affranchir d'une connexion physique entre la souris et l'ordinateur, en passant par une liaison infra-rouge ou radio. Un boîtier est relié au port classique destiné à la souris et transforme les signaux reçus par le capteur infra-rouge ou radio en signaux compréhensibles par le protocole standard de la souris. La technologie radio offre l'avantage de passer par-dessus les obstacles, par rapport aux infra-rouges. On utilise un système de canaux radio pour ne pas mélanger les signaux de différents appareils.

L'avenir semble à la technologie Bluetooth, standardisée pour tout type de périphérique, qui évite la profusion d'émetteurs/récepteurs et malgré les problèmes liés à la source d'énergie. La plupart des souris sans fils sont alimentées soit par des piles, soit par une batterie/accumulateurs (souvent appelés « piles rechargeables »), qui se rechargent lorsqu'on pose la souris sur son réceptacle. Les souris sans fil peuvent avoir un temps de réponse plus long que les souris filaires, selon la technologie employée. On parle aussi de latence ou de « lag » dans le jargon des joueurs.

Sans fil et avec pile[modifier | modifier le code]

Le gros inconvénient des souris sans fil est la nécessité de les alimenter en énergie, ce qui conduit à remplacer régulièrement les piles ou à les recharger. Il existe des souris magnétiques, qui nécessitent un tapis spécial relié au port USB la souris est donc rechargée par le tapis. Le tapis est chargé de détecter les mouvements de la souris et les transmet à l'ordinateur.

Les tablettes graphiques peuvent aussi utiliser une souris à la place du stylet, mais la zone de détection reste limitée à celle du tapis ou de la tablette.

Boutons et leur utilisation[modifier | modifier le code]

afficherCette section ne cite pas suffisamment ses sources (septembre 2020).Le geste du doigt sur les boutons droit et gauche d'une souris, appelé un « clic de souris » s'effectue en deux phases: l'appui, effectué par un léger effort du doigt, et la relâche, pendant laquelle le doigt cesse d'appuyer et un ressort accompagne le retour du bouton vers sa position de repos. Un son distinctif nommé « clic » accompagne chacune des deux phases du geste ; un « clic de souris » (le geste) fait donc entendre deux « clics » (sons). Certains clics s'effectuent sans déplacement de la souris ; d'autres actions exigent un déplacement de la souris pendant que le bouton est enfoncé. Dans tous les cas, le fait de relâcher le bouton envoie à l'ordinateur un signal qui termine l'action en cours. La succession rapide de clics, « double-clic » ou « triple-clic », est un raccourci utilisé dans les interfaces graphiques.

Les souris standard pour PC ont aujourd'hui une molette en plus de leurs deux boutons ; la molette (un bouton spécial) qui peut aussi bien être tournée (molettes mécaniques) que pressée (trackpoint, donnant respectivement un et deux degrés de liberté aux souris correspondantes) s'est répandue.

Les souris avec plus de deux boutons (voire deux molettes) remplissent différentes fonctions assignées à chacun par les applications, le pilote ou le système d'exploitation.

Par exemple, un utilisateur du bureau Windows, GNOME ou KDE utilisera le bouton de gauche dans le navigateur web pour suivre les liens, alors que celui de droite fera apparaître un menu contextuel permettant à l'utilisateur de copier des images ou un lien, d'imprimer, etc.

Apple a longtemps produit des ordinateurs avec des souris ne comptant « qu'un seul bouton », car leurs études montraient que les souris à un bouton sont plus faciles à utiliser[réf. nécessaire]. Pour obtenir le menu contextuel, ouvert par le bouton droit sur les PC, il faut maintenir la touche « Contrôle » — souvent « Ctrl » — appuyée pendant le clic. Néanmoins, en , Apple a sorti une souris à quatre boutons (droite, gauche, un trackpoint à la place d'une molette et un double-bouton latéral). En pratique, tous les Mac reconnaissent d'emblée n'importe quelle souris USB à deux boutons.

Dans le monde UNIX ou Linux (plus généralement utilisant X Window System), le troisième bouton est traditionnellement utilisé pour la fonction de collage : un simple balayage d'une zone de texte avec le bouton gauche enfoncé « copie » du texte, un clic sur le bouton central le « colle ».

Du fait que le troisième bouton est quasiment standard sous Unix, on lui a attribué de nombreuses autres fonctions dans les bureaux graphiques évolués : un clic central sur de nombreux éléments du bureau ou des fenêtres donne un accès facile à de nombreuses fonctions.

Sous la plupart des navigateurs web récents, un clic central sur un lien ouvre la page dans un nouvel onglet, un clic central sur un onglet ferme celui-ci.

Pour les souris qui n'ont que deux boutons, il est possible de simuler un troisième bouton par appui simultané sur les deux boutons.

Pour la plupart des souris actuelles, le troisième bouton se présente sous la forme d'une molette cliquable permettant de faire défiler les pages sans déplacer la souris.

On trouve facilement des souris ayant les deux boutons classique, une molette que l'on peut cliquer (soit déjà 5 actions possibles, que l'on appelle 5 boutons), plus encore deux boutons « précédent » et « suivant ». Ces deux derniers boutons servent par exemple à consulter la page précédente ou suivante dans un navigateur web ou un explorateur de fichiers. Ils sont parfois intégrés à la molette, qui peut basculer à droite et à gauche. Ce principe introduit par Apple (Mighty Mouse) pour Mac OS X a été reproduit par de nombreux fabricants (comme le méconnu Bazoo ou Trust) . Il est possible d'appliquer des actions à effectuer comme ouvrir des applications lorsque l'on clique sur un bouton.

Il existe également des souris ayant une multitude de boutons (une quinzaine par exemple). Ce genre de souris reste toutefois réservée au contrôle de certains jeux ou logiciels spécialisés, permettant d'accéder aux différentes fonctions depuis la souris.

Entretien[modifier | modifier le code]

Les souris sans boule demandent peu d'entretien.

Les modèles à boule doivent être fréquemment démontés, car de la poussière se met sur les rouleaux, gênant leur rotation. Cela se fait facilement à la main, mais il peut être nécessaire, dans les cas d'encrassement sévère, de recourir pour cette opération à un accessoire de nettoyage, tel qu'un coton-tige légèrement humide. Dans tous les cas, il est important de ne pas laisser tomber de saletés à l'intérieur du boitier de la souris, augmentant ainsi le risque de problèmes futurs.

De la saleté peut également se déposer sur les patin glisseurs, causant ainsi des problèmes de déplacements gênant les mouvements de la souris. Les patins en Téflon, sont fréquemment utilisés pour minimiser ce problème de frottement.

Les phénomènes d'encrassement sont diminués par les tapis en tissu, ou par une forme spéciale des rouleaux. Les rouleaux ont la fine zone directement en contact avec la boule d'un diamètre un peu plus grand que le reste du rouleau. La poussière se dépose donc autour de cette zone, lorsque le mouvement de la boule le permet. Le déplacement dans un axe de la souris nettoie le rouleau détectant le mouvement perpendiculaire.

Par précaution, un nettoyage périodique de celui-ci est toujours le bienvenu pour limiter l'encrassement des organes mécaniques de la souris.

Il peut aussi arriver que la molette d'une souris s'encrasse. La poussière s'introduit progressivement sur la roue codeuse chargée de détecter la rotation. Dans ce cas, un démontage plus profond de la souris est nécessaire.

Extensions du modèle de la souris[modifier | modifier le code]

L'usage d'applications en OpenGL qui demandent six degrés de liberté au lieu de trois conduisent à rechercher des dispositifs de pointage permettant de rentrer de façon analogique six informations simultanées12 (trois de position et trois d'orientation) : Spaceball, The bat, anneau radio orientable porté au doigt, etc.

Certains dispositifs s'ajoutent à la souris au lieu de la concurrencer. Par exemple le 3D SpaceNavigator, qui procure six degrés de liberté, s'utilise avec la main gauche tandis que la souris à molette continue à fournir trois degrés de liberté à la main droitec. Des logiciels comme Google Earth ou Google Sketchup supportent en standard ce dispositif, mais leur utilisation première se destine aux logiciels de CAO 3D, tels que CATIA ou ProEngineer.

D'autres dispositifs de navigation en 3D sont maintenant directement intégrés dans la souris, ce qui permet de ne pas mobiliser la seconde main. Par exemple la Lexip-3D, conçue par la société française E-Concept et qui a reçu la médaille d'or au concours Lépine européen 201413.

Représentation graphique : le pointeur[modifier | modifier le code]

Le pointeur de la souris est un graphisme (ou sprite) sur l'écran. Lorsque l'utilisateur déplace la souris, le pointeur se déplace. Sa représentation dépend des opérations offertes à l'utilisateur. Son apparence de base est une flèche. Il prend l'apparence de la capitale I lorsqu'il permet de sélectionner du texte. Sous Windows, il prend l'apparence d'une montre ou d'un sablier lorsqu'il faut attendre la fin d'une opération de l'ordinateur. Après avoir déplacé le pointeur sur un élément (caractère, mot, bouton, image…) affiché à l'écran, l'utilisateur peut ensuite le sélectionner d'un clic. Enfin, lors d'un redimensionnement, elle prend la forme d'une double flèche verticale, horizontale, les deux à la fois ou diagonale selon le sens du redimensionnement.

- Différents types de curseur

-

Indicateur de lien web.

Mesure des mouvements de la souris[modifier | modifier le code]

Plusieurs technologies sont ou ont été utilisées pour mesurer les mouvements de la souris.

Technologie mécanique[modifier | modifier le code]

Souris à boule :

Souris à boule :

1 : Mouvement de la boule

2 : Rouleau transmettant les mouvements latéraux de la souris

3 : Disque perforé

4 : Diode électroluminescente

5 : Capteur optique.La souris contient une boule en contact avec le support où elle est utilisée. Deux rouleaux perpendiculaires entre eux actionnés par cette boule permettent de capter les déplacements de la souris sur le sol. Un troisième rouleau permet de stabiliser la boule. Les rouleaux sont solidaires d'un axe au bout duquel se trouve un disque perforé laissant passer la lumière d'une diode électroluminescente ou au contraire la bloquant. Une cellule photoélectrique recevant cette lumière fournit quand la souris se déplace un signal alternatif, grossièrement {\displaystyle |\sin(x)|}, de fréquence proportionnelle à la vitesse. À l'aide d'un trigger de Schmitt, on peut obtenir un signal en créneaux, chaque impulsion créneau correspondant à une perforation, et on peut calculer la vitesse de déplacement de la souris selon chaque axe.

La résolution de la direction du déplacement (gauche-droite vs droite-gauche) se fait en utilisant deux cellules de réception décalées d'une demi perforation. Après conversion en signal en créneaux binaires (0 = pas de lumière, 1 = lumière), les booléens fournis par le couple de cellule prennent forcément la suite de valeurs (0, 0), (0, 1), (1, 1), (1, 0) dans cet ordre ou dans l'ordre inverse ; l'ordre indique la direction du déplacement. En effet, le placement décalé des deux cellules fait que l'on ne peut jamais passer directement d'un état où les deux sont éclairées à un état où les deux ne sont pas éclairées, ou vice-versa ; en d'autres termes, lorsque la souris se déplace, un seul des deux signaux booléens peut varier à la fois (Code Gray sur deux bits). On obtient ainsi une résolution de ½ perforation.

Pour obtenir une position absolue sur l'écran, la solution la plus immédiate est de totaliser les impulsions (déplacement relatif de ±1 en abscisse ou en ordonnée) ; ceci est généralement fait par logiciel. Certains systèmes permettent des manipulations plus complexes, comme un comportement non-linéaire vis-à-vis de l'accélération, censé faciliter la traversée de grandes zones d'écran par la souris sans fatigue de la main de l'utilisateur, les mouvements rapides (et peu précis) étant amplifiés plus que les mouvements lents.

Les premières souris comportaient des cylindres à la place de la boule. Cela rendait la souris moins précise car les déplacements horizontaux et verticaux s'effectuaient moins facilement quand ils étaient associés lors d'un déplacement oblique.

Le principal inconvénient de la souris mécanique est le dépôt de poussières qui s'accumulent sur les rouleaux, modifiant aléatoirement le transfert des mouvements de la boule aux rouleaux. En raison de ce phénomène, la plaque trouée supportant la boule dans la partie inférieure de la souris est démontable, permettant à l'utilisateur de nettoyer les rouleaux. Un chiffon imbibé d'eau savonneuse y suffit pour la boule, des bâtonnets à bout de coton du commerce sont en général nécessaires pour les rouleaux.

Technologies optiques[modifier | modifier le code]

La Diamondback Plasma de Razer.

La Diamondback Plasma de Razer.Il existe différents types de souris :

- Mouse Systems

- Développée par Mouse Systems (en) vers 1982, elle utilise un tapis métallique, solide, rigide et quadrillé. En envoyant un rayon de lumière et en captant le retour, la souris arrive à savoir qu'un déplacement a eu lieu.

Elle a été utilisée sur des PC, et quelque temps par IBM sur son écran 3179-G, mais surtout par Sun Microsystems pour ses stations de travail. Un inconvénient est que la mesure du mouvement dépend de l'alignement du tapis. Cette technique n'est plus utilisée.

- à DEL

- En 1999, Agilent commercialise la première souris optique.

Une micro-caméra filme le support et un processeur interprète le défilement des aspérités comme un mouvement.

Cette technologie ne nécessite pas de tapis spécial, mais il faut quand même éviter les supports réfléchissants (verre, plastique brillant, bois vernis…) ou trop sombres.

- laser

- Inventée par les ingénieurs de Logitech en remplacant la DEL de la souris optique par un petit laser, ainsi la source de lumière est plus intense et plus ciblée, permettant d'obtenir un meilleur cliché de la surface.

- infrarouge

- Inventée par les ingénieurs de Razer. Utilisée notamment sur les souris de la même marque, comme les Diamondbacks.

- BlueTrack

- La technologie développée par Microsoft14 et mise la première fois sur le marché en 2008. BlueTrack a été pensé pour remplacer les souris qui utilisent les technologies laser, infrarouge et LED car elles posaient problème pour fonctionner sur certaines surfaces. Les souris BlueTrack peuvent fonctionner sur presque tous les types de surfaces (par exemple, le granit, tapis, bois, etc.) sauf le verre clair et les miroirs. La LED utilisée par la technologie BlueTrack n'est plus rouge mais bleue car cette couleur est moins sensible à la poussière et aux taches que le rouge, fournit également des images avec un contraste et une résolution plus élevés ce qui assure une meilleure précision sur les surfaces granuleuses. Enfin, le faisceau utilisé par cette technologie est quatre fois plus grand afin que la lumière couvre une surface plus grande, ce qui entraîne une meilleure réflexion et représentation de la surface du capteur.

La tendance actuelle[Quand ?] est aux souris commutables instantanément du doigt entre trois sensibilités différentes. On peut ainsi à la fois bénéficier de déplacements très rapides du pointeur et d'une excellente précision sans effort de tension nerveuse chaque fois que l'on en a besoin.[réf. nécessaire]

Performances[modifier | modifier le code]

Les performances d'une souris dépendent du rapport du nombre de mesures effectuées par la souris sur la distance parcourue par celle-ci, le DPI (en anglais « Dots Per Inch » signifiant « Points par Pouce »). Un nombre élevé de DPI permet une précision accrue lors du déplacement du pointeur, pour un usage bureautique ainsi que pour la plupart des utilisations, une précision d'environ 800 à 1 600 DPI suffit ; des souris avec des performances plus élevées (de 2 000 à 16 000 DPI) sont surtout utilisé pour les jeux15.

Gadgets[modifier | modifier le code]

Certaines souris disposent d'un ventilateur au centre avec un bouton sur un côté pour l'activer ou l'éteindre. Certains ont introduit des souris « sensibles » : au passage d'un objet (lien hypertexte, bouton, changement de fenêtre…) la souris vibre légèrement, donnant une impression de relief.

- Une souris-stylo est un stylo numérique.

- Une souris de présentation, en anglais presenter Mouse, est une souris informatique ayant des possibilités de pilotage multi-media.

- Une souris d'air (traduction du terme anglais air mouse) est une souris d'ordinateur sans fil à détection de mouvements dans l'espace (trois dimensions). Elle est utilisable pour des simulations de mouvement ou des jeux vidéo. Elle peut permettre, par exemple, de simuler une partie de tennis ou un combat de boxe quand on dispose du logiciel adéquat.

Souris scanner[modifier | modifier le code]

Il existe des modèles de souris équipées d'un scanner16 permettant de numériser des documents (texte ou image). Cela peut par exemple être utile pour les enfants dyspraxiques, ces modèles étant suffisamment légers pour être transportés dans un sac d'école17.

Souris gamer[modifier | modifier le code]

La souris gamer, ou « souris de jeu vidéo », est une variante de la souris informatique conçue pour les jeux vidéo sur ordinateur. Elle prend principalement l'aspect d'une souris classique équipée de plusieurs boutons supplémentaires notamment dédiés à réaliser des actions spécifiques en cours de jeu. La souris gamer est en principe destinée à un PC gamer, un ordinateur conçu pour le jeu vidéo. Toutefois, il est possible également de l'utiliser sur un ordinateur ordinaire, dans la mesure où celui-ci est compatible avec la souris18.

Il existe différents types de souris pour gamer, destinées à la pratique de différents types de jeux. On retrouvera ainsi des souris orientées vers la pratique des MMO's (Jeu en ligne massivement multijoueur), qui ont généralement un grand nombre de boutons programmables, afin de faciliter les nombreuses actions possibles au sein de ce type de jeu. Des souris dédiées aux FPS (First Person Shooter) existent également, elles sont conçues pour accroître la réactivité du joueur19.

Souris ergonomique[modifier | modifier le code]

Les souris ergonomiques sont, quant à elles, des souris ayant un design qui permet d'éviter et/ou de prévenir les TMS (Trouble musculo-squelettique) et le syndrome du canal carpien. Ce type de souris aide à réduire les douleurs notamment aux poignets en raison de leur forme permettant une position naturelle du bras lors du travail sur poste.

Fabricants de souris[modifier | modifier le code]

La plupart des constructeurs de souris sont américains (Microsoft, Apple, Dell...), mais il y a aussi quelques constructeurs asiatiques (les Japonais Sony et Toshiba, le Coréen Samsung, le Taïwanais Acer) et un important constructeur suisse (Logitech).

Notes et références[modifier | modifier le code]

Notes[modifier | modifier le code]

- Depuis août 1998 pour les Macs, avec la sortie de l'iMac G3.

- Bien qu'il existe des adaptateurs PS2/USB.

- Ou l'inverse si l'on est gaucher.

Références[modifier | modifier le code]

- « Lexip 3D » [archive].

- (en) « 1963: Douglas Engelbart Invents the Mouse » [archive], sur coe.berkeley.edu.

- (en) « Father of the Mouse » [archive], sur dougengelbart.org.

- (en) The computer mouse turns 40 [archive], sur le site macworld.com.

- Pierre Schellingen, « Un mulot en forme de stylo pour remplacer la souris », Le Figaro, (lire en ligne [archive]).

- Anne-Sylvie Weinmann, « André Guignard, un virtuose de la micromécanique » [archive], sur Musée Bolo, (consulté le )

- La souris fête son quarantième anniversaire [archive], sur lemondeinformatique du 10 décembre 2008, consulté le 24 novembre 2017.

- Étude cinématique de diverses méthodes de manipulation de la souris d'ordinateur [archive], sur le site irsst.qc.ca.

- Voir l'avant-dernier paragraphe [archive], sur macg.co de mars 2014, consulté le 24 novembre 2017.

- Que le marketing de cette société présente comme étudiée pour minimiser les inconvénients dus à une utilisation intensive.

- Source : revue Occupational and environmental medicine, novembre 2006.

- (en) [PDF] Rapport technique [archive], sur le site de Hewlett-Packard.

- « Palmarès concours Lépine européen 2014 » [archive].

- Au-revoir le Laser : Souris Microsoft BlueTrack [archive], sur le site clubic.com.

- Razer lance la souris Taipan : 8200 dpi, avec ou sans fil [archive], sur le site razerzone.com, 6 novembre 2012.

- Troubles de l'attention avec ou sans hyperactivité [archive], Dr Anne Gramond, Laura Nannini.

- Enfants Dyspraxiques [archive], Claire Mouchard Garelli.

- « Souris gamer : Quel est le meilleur modèle, comment choisir ? » [archive], sur Guide High-Tech, (consulté le ).

- « Souris Gamer pour FPS : Comparatif des meilleures souris » [archive], sur Meilleure souris gamer, (consulté le ).

Voir aussi[modifier | modifier le code]

Articles connexes[modifier | modifier le code]

Microphone

Pour les articles homonymes, voir Micro.

Cet article possède un paronyme, voir Microfaune.

Le , trois microphones sont posés sur la table des participants de l’émission de Radio-Canada Le Mot S.V.P., animée par Roger Baulu.

Le , trois microphones sont posés sur la table des participants de l’émission de Radio-Canada Le Mot S.V.P., animée par Roger Baulu.Un microphone (souvent appelé micro par apocope) est un transducteur électroacoustique, c'est-à-dire un appareil capable de convertir un signal acoustique en signal électrique1.

L'usage de microphones est aujourd'hui largement répandu et concourt à de nombreuses applications pratiques :

- télécommunications (téléphone, radiotéléphonie, Interphone, systèmes d'intercommunication) ;

- sonorisation ;

- radiodiffusion et télévision ;

- enregistrement sonore notamment musical ;

- mesure acoustique.

On appelle également micro, par métonymie, les transducteurs électromagnétiques de guitare électrique (micro de guitare) et les transducteurs piézoélectriques (capteur piézo) utilisés pour des instruments dont le son est destiné à être amplifié.

Le composant électronique qui produit ou module la tension ou le courant électriques selon la pression acoustique, est appelé capsule. On utilise aussi le terme microphone par synecdoque. Un tissu ou une grille protège généralement cette partie fragile.

Origine du terme[modifier | modifier le code]

Le premier usage du terme microphone désignait une sorte de cornet acoustique. David Edward Hughes l'a le premier utilisé pour désigner un transducteur acoustique-électrique. Améliorant le dispositif de Graham Bell, Hugues fait valoir la capacité du dispositif qu'il a co-inventé à transmettre des sons beaucoup plus faibles2.

Symbole électronique d'un microphone.

Symbole électronique d'un microphone. Le microphone dynamique à main Shure SM58 (à gauche) et sa version supercardioïde, le BETA58 (à droite).

Le microphone dynamique à main Shure SM58 (à gauche) et sa version supercardioïde, le BETA58 (à droite).Conception et caractéristiques[modifier | modifier le code]

Une membrane vibre sous l'effet de la pression acoustique et un dispositif qui dépend de la technologie du microphone convertit ces oscillations en signaux électriques. La conception d'un microphone comporte une partie acoustique et une partie électrique, qui vont définir ses caractéristiques et le type d'utilisation.

Mode d'action acoustique[modifier | modifier le code]

Capteurs de pression (omnidirectionnels)[modifier | modifier le code]

Si la membrane est au contact de l'onde sonore d'un seul côté, tandis que l'autre est dans un boîtier avec une pression atmosphérique constante, elle vibre selon les variations de pression. On parle d'un capteur de pression acoustique. Ce type de capteur réagit à peu près de la même manière aux ondes sonores quelle que soit la direction d'origine. Il est insensible au vent. Il est à la base des microphones omnidirectionnels.

Les microphones à effet de surface sont des capteurs de pression fixés sur une surface de quelque étendue formant baffle, qui double la pression acoustique dans l'hémisphère limité par la surface d'appui (Voir PZM (microphone) (en)).

Capteurs de gradient de pression (bidirectionnels ou directivité en 8)[modifier | modifier le code]

Si la membrane est au contact de l'onde sonore des deux côtés, elle ne vibre pas lorsqu'une onde arrive en travers, puisque les surpressions sont égales des deux côtés. On appelle ce type de membrane un capteur de gradient de pression acoustique. C'est la base des microphones bidirectionnels ou à directivité en 8.

Types mixtes ou variables[modifier | modifier le code]

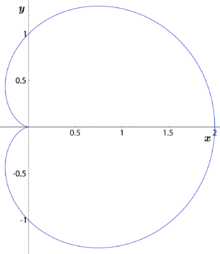

En associant ces deux types, soit par des moyens acoustiques, en contrôlant de façon plus subtile l'accès des ondes sonores à la face arrière de la membrane, soit par des moyens électriques, en combinant le signal issu de deux membranes, on obtient des directivités utiles, notamment cardioïde (dite aussi unidirectionnelle) :

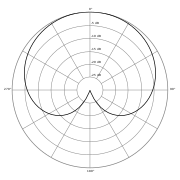

Directivité d'un micro cardioïde capsule omnidirectionnelle bidirectionnelle cardioïde rapport formule {\displaystyle \displaystyle {U=1}} {\displaystyle \displaystyle {U=\cos \theta }} {\displaystyle \displaystyle {U=1+\cos \theta }} son dans l'axe {\displaystyle \displaystyle {\theta =0}} {\displaystyle \displaystyle {U=1}} {\displaystyle \displaystyle {U=1}} {\displaystyle \displaystyle {U=2}} 100 %, 0 dB son de côté {\displaystyle \displaystyle {\theta ={\frac {\pi }{2}}}} (90°) {\displaystyle \displaystyle {U=1}} {\displaystyle \displaystyle {U=0}} {\displaystyle \displaystyle {U=1}} 50 %, -6 dB son arrière {\displaystyle \displaystyle {\theta =\pi }} (180°) {\displaystyle \displaystyle {U=1}} {\displaystyle \displaystyle {U=-1}} {\displaystyle \displaystyle {U=0}} 0 %, -∞ dB On construit des microphones de directivité cardioïde large, supercardioïde et hypercardioïde en changeant les proportions entre la composante omnidirectionnelle et la composante bidirectionnelle. Des microphones peuvent offrir un réglage ou une commutation de la directivité3.

Ces constructions permettent de donner plus d'importance à une source vers laquelle on dirige le micro et d'atténuer le champ sonore réverbéré, qui vient de toutes les directions. On définit un indice de directivité comme l'expression, en décibels du rapport entre un son venant dans l'axe du microphone et un son de même pression acoustique efficace venant d'une source idéalement diffuse (venant de partout autour du microphone)4.

Caractéristiques théoriques de directivité de cellules capsule formule indice de

directivitéangle pour une atténuation à niveau pour un angle de -3 dB -6 dB -∞ dB 90° (son latéral) 180° (son arrière) omnidirectionnelle {\displaystyle \scriptscriptstyle {U=1}} 0 dB - - - 0 dB 0 dB cardioïde {\displaystyle \scriptscriptstyle {U={\frac {1}{2}}+{\frac {1}{2}}\cos \theta }} 4,8 dB 65° 90° 180° -6 dB -∞ dB supercardioïde {\displaystyle \scriptscriptstyle {U={\frac {1}{3}}+{\frac {2}{3}}\cos \theta }} 5,7 dB 56° 75° 120° -9 dB -10 dB hypercardioïde {\displaystyle \scriptscriptstyle {U={\frac {1}{4}}+{\frac {3}{4}}\cos \theta }} 6,0 dB 52° 70° 110° -12 dB -6 dB bidirectionnelle {\displaystyle \scriptscriptstyle {U=\cos \theta }} 4,8 dB 45° 60° 90° -∞ dB 0 dB Tubes à interférences[modifier | modifier le code]

Les microphones à tube à interférences donnent des directivités accentuées, mais fortement dépendantes des fréquences. À cause de leur forme allongée, on les appelle micro canon.

Taille de la membrane[modifier | modifier le code]

La taille de la membrane influe sur la conversion en vibrations, puis en signal électrique.

Au contact d'une paroi perpendiculaire à la direction de propagation, une onde sonore développe une puissance proportionnelle à l'aire et au carré de la pression acoustique :

{\displaystyle P=S.{\frac {p'^{2}}{\rho _{0}\ c}}} - S est la surface de la paroi ;

- p est la pression acoustique ;

- {\displaystyle \rho _{0}} est la masse volumique de l'air (1,2 kg/m3 aux conditions normales de température et de pression) ;

- c est la vitesse du son, 343 m/s dans les mêmes conditions.

Exemple : puissance acoustique sur une membrane de microphone :soit une membrane de microphone de diamètre 20 mm atteint par une onde sonore perpendiculaire avec une pression de 1 Pa. L'aire de la paroi est de 3,14e-4 m², la puissance acoustique sur la membrane est de 0,76 μW.

On ne peut récupérer qu'une partie de cette puissance sous forme de signal électrique décrivant l'onde sonore. Plus la membrane est grande, moins il est nécessaire d'amplifier le signal, et par conséquent, moins on le soumet à un traitement amenant inévitablement une certaine quantité de bruit et de distorsion.

La taille de la membrane détermine par conséquent la sensibilité maximale du microphone. Mais dès que la plus grande dimension de la membrane devient significative par rapport à la longueur d'onde d'un son, elle constitue, pour les ondes sonore qui n'arrivent pas perpendiculairement, un filtre en peigne. Bien entendu, d'autres phénomènes comme la diffraction sur les bords interviennent, rendant la réponse réelle plus complexe.

La présence d'un entourage rigide autour de la membrane crée un effet de surface qui augmente la pression acoustique pour les fréquences dont la longueur d'onde est inférieure à la taille de l'ensemble membrane-entourage. Cet obstacle peut-être plat ou sphérique, il constitue autour d'une capsule capteur de pression un filtre acoustique, comme la grille de protection, qui délimite une cavité dont les caractéristiques influent sur la réponse du microphone, particulièrement aux plus hautes fréquences5.

Les applications (téléphone mobile, micro cravate) qui exigent des micros de petite taille limitent par là même la taille de la membrane.

Conversion vibration-signal électrique[modifier | modifier le code]

Microphone à charbon[modifier | modifier le code]

Les premiers microphones, employés d'abord dans les téléphones, utilisaient la variation de résistance d'une poudre granuleuse de carbone, quand elle est soumise à une pression. Quand on comprime la poudre, la résistance diminue. Si on fait passer du courant à travers cette poudre, il va être modulé suivant la pression acoustique sur la membrane qui appuie sur la poudre. On ne peut évidemment construire de cette manière que des capteurs de pression. Ces microphones sont peu sensibles, fonctionnent sur une plage de fréquence limitée, et leur réponse n'est que très approximativement linéaire, ce qui cause de la distorsion. Ils ont l'avantage de pouvoir produire une puissance assez élevée sans amplificateur. Ils ont été utilisés dans les combinés téléphoniques, où leur robustesse était appréciée, et à la radio avant l'introduction de procédés donnant de meilleurs résultats.

Microphone dynamique à bobine mobile[modifier | modifier le code]

Dans les microphones électromagnétiques à bobine mobile, une bobine est collée à la membrane, qui la fait vibrer dans le fort champ magnétique fixe d'un aimant permanent. Le mouvement crée une force électromotrice créant le signal électrique. Comme la conversion de l'énergie sonore dégagée par l'action de la pression acoustique sur la membrane donne directement un courant utilisable, ces microphones sont dits dynamiques, car contrairement aux micros à charbon et aux micros électrostatiques, ils n'ont pas besoin d'alimentation.

L'apparition dans les années 1980 d'aimants au néodyme a permis des champs magnétiques plus intenses, avec une amélioration de la qualité des microphones électromagnétiques.

Microphone à ruban[modifier | modifier le code]

Dans les microphones électromagnétiques à ruban, la membrane est un ruban gaufré souple installé dans le champ magnétique d'un aimant permanent. Il fonctionne comme le microphone électromagnétique à bobine mobile, avec l'avantage de la légèreté de la partie mobile. Il ne requiert pas d'alimentation. L'impédance de sortie est bien plus faible que celle des autres types, et il est assez fragile.

Microphone électrostatique[modifier | modifier le code]

Dans les microphones électrostatiques, la membrane, couverte d'une mince couche conductrice, est l'une des armatures d'un condensateur, chargé par une tension continue, l'autre armature étant fixe. La vibration rapproche et éloigne les armatures, faisant varier la capacité. La charge étant constante et égale au produit de la tension et de la capacité, la variation de la capacité produit une variation inverse de tension. L'impédance de sortie est très élevée. Les micros électrostatiques ont besoin d'une alimentation, d'une part pour la polarisation du condensateur, d'autre part pour l'amplificateur adaptateur d'impédance qui doit être proche de la membrane.

L'alimentation peut être fournie par un conducteur spécial relié à un boîtier d'interface qui assure aussi l'adaptation d'impédance. Cependant, ce n'est le cas que pour quelques microphones très haut de gamme. La plupart des modèles utilisent une alimentation fantôme, ainsi nommée parce qu'elle ne nécessite aucun conducteur supplémentaire.

La sensibilité des microphones électrostatiques est supérieure à celle des microphones dynamiques. Il y a besoin de moins de puissance sonore pour faire vibrer la membrane seule que l'appareil membrane-bobinage, et l'amplificateur adaptateur d'impédance prélève une puissance infime. Cet amplificateur est conçu pour le capteur et contrôle aussi la bande passante ; la réponse du condensateur seul est un filtre passe-bas (Rayburn 2012, p. 33). Ces amplificateurs furent d'abord composés d'un tube électronique et d'un transformateur. Plus récemment, leur niveau de bruit et de distorsion ainsi que leur sensibilité aux interférences ont été abaissés par l'emploi de transistors ou de transistors à effet de champ, sans transformateurs6.

Microphone électrostatique haute fréquence[modifier | modifier le code]

Le condensateur formé par la membrane et une armature fixe n'est pas polarisé par une tension continue, mais constitue, avec une résistance, un filtre dont la fréquence de coupure varie comme la capacité. Le niveau de modulation haute-fréquence suit donc la vibration de la membrane. L'étage suivant comporte une démodulation sur une diode qui conduit les transistors de sortie7.

Microphone électrostatique à électret[modifier | modifier le code]

Les microphones électrostatiques à électret tirent parti d'une propriété de certains matériaux de conserver une charge électrostatique permanente. Un matériau de cette sorte constitue une armature de condensateur, la membrane l'autre. Les microphones à électret n'ont pas besoin de tension de polarisation, mais ils ont néanmoins un amplificateur adaptateur d'impédance, qui requiert une alimentation. Si la tension de crête de sortie n'est pas trop élevée, cette alimentation peut être fournie par une pile.

La charge de polarisation diminue dans le temps, ce qui se traduit par une perte de sensibilité du micro au fil des années.

Transmission du signal[modifier | modifier le code]

- asymétrique sur courte distance (comme dans les téléphones mobiles ou les dictaphones). Le signal est la tension entre le conducteur unique et la masse.