Eau

Pour les articles homonymes, voir Eau (homonymie).

| Eau | |

|

|

|

|

| Identification | |

|---|---|

| Nom UICPA | eau |

| Synonymes |

monoxyde de dihydrogène, oxyde d'hydrogène, hydrogénol, hydroxyde d'hydrogène, oxyde dihydrogéné, oxydane |

| No CAS | |

| No ECHA | 100.028.902 |

| No CE | 231-791-2 |

| PubChem | 962 |

| ChEBI | 15377 |

| SMILES | |

| InChI | |

| Apparence | liquide incolorea, inodore et insipide |

| Propriétés chimiques | |

| Formule | H2O [Isomères] |

| Masse molaire2 | 18,015 3 ± 0,000 4 g/mol H 11,19 %, O 88,81 %, 18,015 28 g mol−1 |

| pKa | pKe = 14,0 |

| Moment dipolaire | 1,8546 D |

| Indice d’iode | gI2 100g−1 |

| Indice d’acide | mgKOH g−1 |

| Indice de saponification | mgKOH g−1 |

| Propriétés physiques | |

| T° fusion | 0 °C à 1,013 25 bar |

| T° ébullition | 100 °C à 1,013 25 bar3, 100,02 °C ± 0,044 |

| Solubilité | g l−1 |

| Masse volumique | 1 000,00 kg m−3 à 4 °C 998,30 kg m−3 à 20 °C 958,13 kg m−3 à 100 °C (liquide) 726,69 kg m−3 à 300 °C - 15,5 MPa3 |

| Pression de vapeur saturante | 6,112 mbar (glace, 0 °C)5 12,4 mbar (10 °C) |

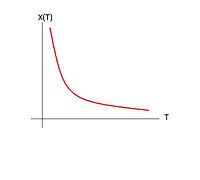

| Viscosité dynamique | 1,002 × 10−3 Pa s à 20 °C 0,547 × 10−3 Pa s à 50 °C 0,281 8 × 10−3 Pa s à 100 °C (liquide) 0,080 4 × 10−3 Pa s à 300 °C - 15 MPa3 |

| Point critique | 374,15 °C, 22,12 MPa3,4 |

| Point triple | 0,01 °C, 611,2 Pa3,4 |

| Conductivité thermique | 0,604 W m−1 K−1 à 20 °C |

| Vitesse du son | 1 497 m s−1 à 25 °C8 |

| Thermochimie | |

| S0gaz, 1 bar | 188,7 J K−1 mol−1 |

| S0liquide, 1 bar | 69,9 J K−1 mol−1 |

| S0solide | J K−1 mol−1 |

| ΔfH0gaz | −241,818 kJ mol−1 |

| ΔfH0liquide | −285,83 kJ mol−1 |

| ΔfH0solide | −291,84 kJ mol−1 |

| ΔfusH° | 6,01 kJ mol−1 |

| ΔvapH° | 44,2 kJ mol−1 à 20 °C, 43,990 kJ mol−1 à 25 °C, 40,657 kJ mol−1 à 100 °C, 2,26 MJ kg−1 à 100 °C |

| Cp | 4 185,5 J kg−1 K−1 à 15 °C et 101,325 kPa, 75,403 J mol−1 K−1 à 15 °C et 101,325 kPa, 75,366 J mol−1 K−1 à 20 °C et 101,325 kPa, 75,291 J mol−1 K−1 à 25 °C et 101,325 kPa |

| PCS | kJ mol−1 |

| PCI | kJ mol−1 |

| Propriétés optiques | |

| Indice de réfraction | 1,33 |

| Constante de Verdet | 4,10 rad T−1 m−1 à 480 nm9 |

| Écotoxicologie | |

| DL50 | > 90 ml kg−1 (rat, oral)10 |

| Unités du SI et CNTP, sauf indication contraire. | |

| modifier |

|

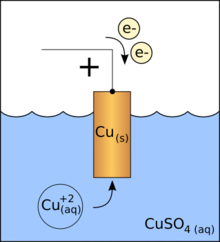

L'eau est une substance chimique constituée de molécules H2O. Ce composé, très stable, mais aussi très réactif, est un excellent solvant à l'état liquide. Dans de nombreux contextes, le terme eau est employé au sens restreint d'eau à l'état liquide, ou pour désigner une solution aqueuse diluée (eau douce, eau potable, eau de mer, eau de chaux, etc.).

L'eau est ubiquitaire sur Terre et dans l'atmosphère, sous ses trois états, solide (glace), liquide et gazeux (vapeur d'eau). L'eau extraterrestre est également abondante, sous forme de vapeur d'eau dans l'espace et sous forme condensée (solideb ou liquide) à la surface, près de la surface ou à l'intérieur d'un grand nombre d'objets célestes.

L'eau est un constituant biologique important, essentiel sous sa forme liquide pour tous les organismes vivants connusc. Compte tenu de son caractère vital, de son importance dans l'économie et de sa répartition inégale sur Terre, l'eau est une ressource naturelle dont la gestion est l'objet de forts enjeux géopolitiques.

Généralités

La formule chimique de l’eau pure est H2O. L’eau que l’on trouve sur Terre est rarement un composé chimique pur, l’eau courante étant une solution d'eau, de sels minéraux et d'autres impuretés. Les chimistes utilisent de l'eau distillée pour leurs solutions, mais cette eau n'est pure qu'à 99 % : il s'agit encore d'une solution aqueuse.

Majoritairement observable sur Terre à l'état liquide, elle possède les propriétés d'un puissant solvant : elle dissout facilement et solubilise rapidement de nombreux corps sous forme d'ions, ainsi que de nombreuses autres molécules gazeusesd, et par exemple les composants de l'air, en particulier l'oxygène ou le dioxyde de carbone. L'expression « solvant universel »11 est toutefois sujette à maintes précautions, beaucoup de matériaux naturels (roches, métaux, etc.) étant non solubles dans l'eau (dans la plupart des cas ou de manière infime).

La surface de la Terre est recouverte à 71 % d’eau12 (97 % d’eau salée et 3 % d’eau douce dans différents réservoirs) sous différentes formes :

- liquide, dans les océans, les lacs, les fleuves et les rivières. Ailleurs que dans les zones humides plus ou moins tourbeuses ou marécageuses, dans les mers et océans, l'eau est présente dans les lagunes, lacs, étangs, mares, fleuves, rivières, ruisseaux, canaux, réseaux de fossés, de watringues ou comme eau interstitielle du sol ;

- gazeuse, sous forme de vapeur d'eau dans l'air. L'humidité de l'air provient de l'évaporation des mers, des plans d'eau et de l'évapotranspiration des plantes ;

- solide, sous forme de glace dans les glaciers dans la banquise, les icebergs, etc.

La circulation de l’eau au sein des différents compartiments terrestres est décrite par le cycle de l'eau. En tant que composé essentiel à la vie, l’eau a une grande importance pour l'Homme13 mais aussi pour toutes les espèces végétales et animales. Source de vie et objet de culte depuis les origines de l'Homme, l'eau est conjointement, dans les sociétés d'abondance comme la France, un produit de l'économie et un élément majeur de l'environnement.

Le corps humain est composé à 65 % d’eau pour un adulte, à 75 % chez les nourrissons et à 94 % chez les embryons de trois jours. Les cellules, quant à elles, sont composées de 70 % à 95 % d'eau. Les animaux sont composés en moyenne de 60 % d'eau et les végétaux à 75 %. On trouve néanmoins des extrêmes : la méduse (98 %) et la graine (10 %)14. L'eau de boisson passe la barrière intestinale et est diffusée par les réseaux sanguins et lymphatiques. Dans les membranes cellulaires, des pores spéciaux dits aquaporines permettent le passage de l'eau de part et d'autre de la membrane, tout en empêchant les ions de pénétrer dans la cellule. En 2009, environ 500 aquaporines étaient identifiées chez les plants et animaux, dont 1315 chez l'humain. Ces pores protéiques complexes « trient » les molécules ayant la même taille que la molécule d’eau, et ne laissent passer que l'eau16.

L'eau a la propriété particulière de présenter une anomalie dilatométrique : sa phase solide est moins dense que sa phase liquide, ce qui fait que la glace flotte17.

Étymologie et usage du mot

Le terme eau est un dérivé très simplifié du latin aqua via les langues d'oïl. Le terme aqua a été ensuite repris pour former quelques mots comme aquarium. Un mélange aqueux est une solution dont le solvant est l'eau. Le préfixe hydro dérive quant à lui du grec ancien ὕδωρ (hudôr) et non pas de ὕδρος (hudros) lequel signifie « serpent à eau » (d'où l'hydre ![]() ).

).

Par « eau », on comprend souvent liquide incolore constitué en majorité d'eau, mais pas uniquement d'eau pure. Suivant sa composition chimique qui induit son origine ou son usage, on précise :

- eau minérale, eau de Seltz, eau de source, eau de mer, eau douce, eau potable, eau de pluie, eau du robinet, eau de table, eau gazeuse, eau plate, etc. ;

- en chimie, on parle d'eau lourde, eau tritiée, eau dure, eau distillée ;

- pour un usage plus ancien, on parle de l'eau-forte pour l’acide nitrique dilué, de l'eau régale pour un mélange d'acides qui dissout l'or, mais aussi d'eau-de-vie constituée d'éthanol dilué d'eau potable ;

- une femme perd ses eaux avant l'accouchement.

Géophysique : l'eau sur Terre et dans l'Univers

L'eau dans l'Univers

L'eau a été trouvée dans des nuages interstellaires dans notre galaxie, la Voie lactée. On pense que l'eau existe en abondance dans d'autres galaxies aussi, car ses composants, l'hydrogène et l'oxygène, sont parmi les plus abondants dans l'Univers.

Les nuages interstellaires se concentrent éventuellement dans des nébuleuses solaires et des systèmes stellaires tels que le nôtre. L'eau initiale peut alors être trouvée dans les comètes, les planètes, les planètes naines et leurs satellites.

La forme liquide de l'eau est seulement connue sur Terre, bien que des signes indiquent qu'elle soit (ou ait été) présente sous la surface d'Encelade, l'un des satellites naturels de Saturne, sur Europe et à la surface de Mars. Il semblerait qu'il y ait de l'eau sous forme de glace sur la Lune en certains endroits, mais cela reste à confirmer. La raison logique de cette assertion est que de nombreuses comètes y sont tombées et qu'elles contiennent de la glace, d'où la queue qu'on en voit (quand les vents solaires les touchent, laissant une traînée de vapeur). Si l'on découvre de l'eau en phase liquide sur une autre planète, la Terre ne serait alors peut-être pas la seule planète que l'on connaît à abriter la vie.

Origine de l'eau sur Terre

Les avis divergent sur l'origine de l’eau sur la Terre.

Formes de l'eau sur Terre

Le cycle de l'eau (connu scientifiquement sous le nom de cycle hydrologique) se rapporte à l'échange continu de l'eau entre l'hydrosphère, l'atmosphère, l'eau des sols, l'eau de surface, les nappes phréatiques et les plantes.

L'eau liquide est trouvée dans toutes sortes d'étendues d'eau, telles que les océans, les mers, les lacs, et de cours d'eau tels que les fleuves, les rivières, les torrents, les canaux ou les étangs. La majorité de l'eau sur Terre est de l'eau de mer. L'eau est également présente dans l'atmosphère en phase liquide et vapeur. Elle existe aussi dans les eaux souterraines (aquifères).

Répartition de l'eau sur Terre

| Réservoirs | Volume (106 km3) | Pourcentage du total |

|---|---|---|

| Océans | 1 320 | 97,25 |

| Calottes glaciaires et glaciers | 29 | 2,05 |

| Eau souterraine | 9,5 | 0,68 |

| Lacs | 0,125 | 0,01 |

| Humidité des sols | 0,065 | 0,005 |

| Atmosphère | 0,013 | 0,001 |

| Fleuves et rivières | 0,0017 | 0,000 1 |

| Biosphère | 0,000 6 | 0,000 04 |

Le volume approximatif de l'eau de la Terre (toutes les réserves d'eau du monde) est de 1 360 000 000 km3. Dans ce volume :

- 1 320 000 000 km3 (97,2 %) se trouvent dans les océans ;

- 25 000 000 km3 (1,8 %) se trouvent dans les glaciers et les calottes glaciaires ;

- 13 000 000 km3 (0,9 %) sont des eaux souterraines ;

- 250 000 km3 (0,02 %) sous forme d'eau douce dans les lacs, les mers intérieures et les fleuves ;

- l'équivalent de 13 000 km3 (0,001 %) d'eau liquide sous forme de vapeur d'eau atmosphérique à un moment donné.

Si la fraction d'eau sous forme gazeuse est marginale, la Terre a perdu au cours de son histoire un quart de son eau dans l'espace19.

On sait depuis 2014 qu'une partie notable du manteau terrestre principalement constituée de ringwoodite, entre 525 et 660 km de profondeur, pourrait contenir jusqu'à trois fois le volume d'eau des océans actuels (et en serait la source principale). La quantification n'est pas encore définitive mais pourrait faire varier énormément le volume d'eau disponible sur Terre, même si son exploitabilité et sa disponibilité spontanée sont douteuses20,21.

Rôle de l'eau dans l'apparition de la vie

L'eau liquide semble avoir joué, et continue à jouer, un rôle primordial dans l'apparition et la persistance de la vie sur Terre. La forme liquide, contrairement aux états gazeux ou solide, maximise les contacts entre atomes et molécules, augmentant de fait leurs interactions. L'eau est une molécule polaire et un bon solvant, capable de solubiliser de nombreuses molécules. Le cycle de l'eau joue un rôle majeur, notamment par l'érosion des continents, qui permet d'apporter de grandes quantités de minéraux nécessaires à la vie dans les rivières, les lacs et les océans. Le gel de l'eau permet d'éclater les roches et augmente la disponibilité de ces minéraux22.

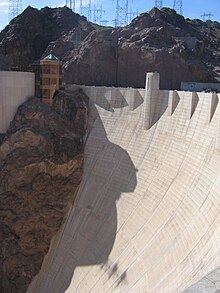

L'eau durant l'« Anthropocène »

Durant l'« Anthropocène »23, l'humanité a bouleversé le cycle de l'eau, par la surexploitation de certaines nappes, la déforestation, le dérèglement climatique, la canalisation de grands cours d'eau, les grands barrages, l'irrigation à grande échelle24. Elle l'a fait à une vitesse et à une échelle qui ne sont pas comparables avec les événements historiques passés, et avec des effets qui dépassent ceux des grandes forces géologiques24.

Propriétés

Propriétés physiques

Générales

La température de vaporisation de l'eau dépend directement de la pression atmosphérique, comme le montrent ces formules empiriques :

- pression normalisée dans la troposphère (0–11 km) :

- P r e s s i o n [ P a ] = 101 325 × ( 288 , 15 − 0 , 0065 × A l t i t u d e [ m ] 288 , 15 ) 5 , 255

- P o i n t d ′ e ´ b u l l i t i o n [ K ] ≈ 26 , 307 × ln ( P r e s s i o n [ P a ] ) + 69 , 771

Son point d'ébullition est élevé par rapport à un liquide de poids moléculaire égal. Ceci est dû au fait qu'il faut rompre jusqu'à trois liaisons hydrogène avant que la molécule d'eau puisse s'évaporer. Par exemple, au sommet de l'Everest, l'eau bout à environ 68 °C, à comparer aux 100 °C au niveau de la mer. Réciproquement, les eaux profondes de l'océan près des courants géothermiques (volcans sous-marins par exemple) peuvent atteindre des températures de centaines de degrés et rester liquides.

L'eau est sensible aux fortes différences de potentiel électrique. Il est ainsi possible de créer un pont d'eau liquide de quelques centimètres entre deux béchers d'eau distillée soumis à une forte différence de potentiel25.

Un nouvel « état quantique » de l’eau a été observé quand les molécules d’eau sont alignées dans un nanotube de carbone de 1,6 nanomètre de diamètre et exposées à une diffusion de neutrons. Les protons des atomes d’hydrogène et d’oxygène possèdent alors une énergie supérieure à celle de l’eau libre, en raison d’un état quantique singulier. Ceci pourrait expliquer le caractère exceptionnellement conducteur de l’eau au travers des membranes cellulaires biologiques26.

Radioactivité : elle dépend des métaux et minéraux et de leurs isotopes présent dans l'eau, et peut avoir une origine naturelle ou artificielle (retombées des essais nucléaires, pollution radioactive, fuites, etc.). En France, elle est suivie par l'Institut de radioprotection et de sûreté nucléaire (IRSN), y compris pour l'eau du robinet27.

L'eau comme fluide thermodynamique

L'eau est un fluide thermodynamique d'usage courant, efficace et économique3 :

- l'eau est stable en température jusqu'à une valeur élevée ;

- l'eau a une masse volumique maximale de 1 000 kg/m3 (soit 1 kg/l à l'origine la définition du kilogramme ; exactement 999,975 kg/m3 à 3,98 °C) ;

- l'eau a la capacité thermique à pression constante la plus élevée de tous les liquides (75,711 J mol−1 K−1 soit 4,202 6 kJ kg−1 K−1 à 20 °C). Les océans sont de bons accumulateurs de la chaleur ;

- l'eau a une très faible conductivité thermique (0,604 W/(m⋅K) à 20 °C) ;

- l'eau a la chaleur latente d'évaporation la plus élevée de tous les liquides (44,22 kJ/mol soit 2 454,3 kJ/kg à 20 °C), d'où l'efficacité de la transpiration comme moyen de rafraîchissement ;

- l'eau a une chaleur latente de fusion élevée (6,00 kJ/mol soit 333,0 kJ/kg) ;

- l'eau a la tension superficielle la plus élevée de tous les liquides (72 mN/m à 20 °C) à l'exception du mercure ; dans l'air humide, la formation de gouttelettes est facilitée ; l'eau monte dans un tube capillaire, telle la sève dans les arbres ;

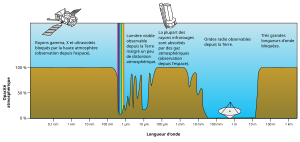

- l'eau est transparente à la lumière visible, ainsi les organismes aquatiques peuvent vivre car la lumière du soleil peut les atteindre ; elle est cependant opaque au rayonnement infrarouge, absorbé par l'hydrogène, l'oxygène et leur liaison ;

- La couleur de l'eau est naturellement bleue en raison de sa vibration moléculaire.

Radiolyse

La radiolyse de l'eau est la dissociation, par décomposition chimique de l'eau (H2O) (liquide ou de vapeur d'eau) en hydrogène et hydroxyle respectivement sous forme de radicaux H· et HO·, sous l'effet d'un rayonnement énergétique intense (rayonnement ionisant). Elle a été expérimentalement démontrée il y a environ un siècle. Elle se fait en passant par plusieurs stades physicochimiques et à des conditions particulières de température et de pression, de concentration du soluté, de pH, de débit de dose, de type et énergie du rayonnement, de présence d'oxygène, de nature de la phase de l'eau (liquide, vapeur, glace). C'est un phénomène encore incomplètement compris et décrit qui pourrait, dans le domaine du nucléaire, des voyages dans l'espace ou pour d'autres domaines, avoir dans le futur des applications techniques nouvelles, entre autres pour la production d'hydrogène28.

Référence dans le système métrique

Référence massique

À l’origine, un décimètre cube (litre) d’eau définissait une masse de un kilogramme (kg). L’eau avait été choisie car elle est simple à trouver et à distiller. Dans notre système actuel de mesure – le Système international d'unités (SI) – cette définition de la masse n’est plus valable depuis 1889, date à laquelle la première Conférence générale des poids et mesures définit le kilogramme comme la masse d’un prototype de platine iridié conservé à Sèvres. Aujourd’hui à 4 °C, la masse volumique est de 0,999 95 kg/L. Cette correspondance reste donc une excellente approximation pour tous les besoins de la vie courante.

Référence de température

- Le système centigrade défini par Celsius (légèrement différent du degré Celsius actuel - voir ci-dessous) fixe le degré 0 sur la température de la glace fondante et définit comme degré 100 la température de l’eau en ébullition sous pression atmosphérique normalee. L’échelle est ensuite graduée de 0° à 100°. C’est ainsi que la température normale du corps humain est en moyenne de 37 °C.

- Le système Fahrenheit fixe originellement le point de solidification de l’eau à 32 °F et son point d’ébullition à 212 °F ; il est désormais aligné sur la température Celsius selon la formule T[°F] = 1,8 T[°C] + 32, la différence avec la première définition étant extrêmement faible.

- Le système kelvin sert pour la mesure absolue de la température thermodynamique ; son unité était jusqu'en 2019 égale à 1/273,16 fois la température absolue du point triple de l’eau (laquelle vaut donc, par réciproque de la définition, 0,01 °C).

- Le système Celsius est défini arbitrairement par une translation d'exactement 273,15 unités par rapport au kelvinf, pour se rapprocher au plus près du degré centigradeg.

Référence de densité

Propriétés chimiques

Forme

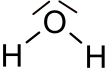

La molécule d'eau possède une forme coudée due à la présence de deux doublets non-liants : les deux orbitales non-liantes et les deux orbitales liantes (liaisons O−H) se repoussent et s'approchent de la symétrie tétraédrique (en) que réalisent les quatre orbitales liantes de la molécule CH4. Elle possède donc une structure tétraédrique (type AX2E2 en méthode VSEPR) ; l'angle H-O-H est de 104,5°h et la distance interatomique dO-H vaut 95,7 pm soit 9,57 × 10−11 m.

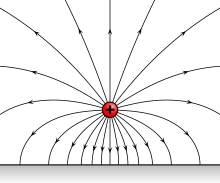

Polarité

L'eau étant une molécule coudée, sa forme joue un rôle important dans sa polarité. En effet, du fait de sa forme coudée, les barycentres des charges partielles positives et négatives ne sont pas superposés. Cela entraîne une répartition inégale des charges ce qui donne à l'eau ses propriétés de molécules polaires29.

De là il vient que :

- l'électronégativité de l'atome O étant plus haute que celle de H, il y a une polarisation de cette molécule, ce qui en fait un bon solvant. Elle possède, en règle générale, un dipôle électrique permanenti. La polarité de la molécule H2O lui permet de réaliser des liaisons hydrogène intermoléculaires (+20 -25 kJ/mol). Les liaisons hydrogène sont des liaisons faibles, donc très mobiles, qui donnent à l'eau une structure ordonnée à l'origine de ses propriétés particulières ;

- on observe 2 charges partielles négatives (δ−), sur les doublets non liants de l'oxygène qui forment chacune une liaison hydrogène avec un atome d’hydrogène d'une autre molécule portant charge partielle positive (δ+) ;

- et une charge partielle positive (δ+), sur chaque atome d'hydrogène ce qui permet des liaisons hydrogène avec un oxygène d'une autre molécule portant une charge (δ−).

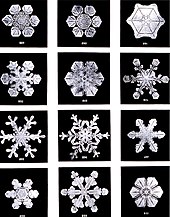

Ce qui explique, par exemple la forme particulièrement ordonnée des cristaux de glace. À quantité égale, la glace flotte sur l'eau (sa densité solide est plus faible que celle liquide).

Solvant

L'eau est un composé amphotère, c'est-à-dire qu'elle peut être une base ou un acide. L'eau peut être protonée, c'est-à-dire capter un ion H+ (autrement dit un proton, d'où le terme protonée) et devenir un ion H3O+ (voir Protonation). À l'inverse, elle peut être déprotonée, c'est-à-dire qu'une autre molécule d'eau peut capter un ion H+ et la transformer en ion OH−. Cependant, ces réactions se produisent très rapidement et sont minimes.

- 2H2O → H3O+ + HO−

Les solvants protiques ou polaires y sont solubles (grâce aux liaisons hydrogène) et les solvants aprotiques ou non-polaires ne le sont pas.

Alimentation humaine

L’eau est le principal constituant du corps humain. La quantité moyenne d’eau contenue dans un organisme adulte est d'environ 65 %, ce qui correspond à environ 45 litres d’eau pour une personne de 70 kilogrammes. Ce pourcentage peut néanmoins varier, plus une personne est maigre, plus la proportion d’eau de son organisme est importante. L'eau dépend également de l’âge : elle diminue avec les années, car plus les tissus vieillissent, plus ils se déshydratent, l’eau étant remplacée par de la graisse.

Dans l’organisme la concentration en eau varie d'un organe à l’autre et selon les cellules31 :

L'organisme humain a besoin d'environ 2,5 litres d'eau par jour (1,5 litre sous forme liquide et 1 litre acquis dans la nourriture absorbée), davantage en cas d'exercice physique ou de forte chaleur ; il ne faut pas attendre d'avoir soif pour en absorber, surtout pour les femmes enceintes et pour les personnes âgées chez qui la sensation de soif est retardée. Sans eau, la mort survient après 2 à 5 jours, sans fournir aucun effort (40 jours sans nourriture en étant au repos).

Chaque jour l'organisme absorbe en moyenne32,j :

- 3 litres pour l'homme ou 2,2 litres pour la femme, d'eau sous forme de boisson ;

- 0,7 litre pour l'homme ou 0,5 litre pour la femme, d'eau contenue dans les aliments ;

- 0,25 litre d'eau produite par le métabolisme des nutriments énergétiques.

Chaque jour, l'organisme en rejette33,j :

- 1 à 2 litres par l'urine (avec un minimum de 0,5 litre pour une personne correctement hydratée en conditions normales) ;

- 0,45 litre par la perspiration et la transpiration (valeurs augmentées avec la chaleur et/ou à l'activité physique) ;

- 0,3 litre (± 20 %) à 0,55 litre (± 10 %) dans un contexte d'activité physique, par la respiration ;

- 0,15 litre (± 10 %) par les selles.

On distingue huit types :

Les contrôles de qualité y recherchent d'éventuels polluants et substances indésirables, dont depuis peu, des médicaments, résidus de médicaments ou perturbateurs endocriniens34 pour limiter les risques environnementaux et sanitaires des résidus de médicaments sur les milieux aquatiques.

Production d'eau potable

De l'eau relativement pure ou potable est nécessaire à beaucoup d’applications industrielles et à la consommation humaine.

En France, le nombre de paramètres qualitatifs de la potabilité est passé entre 1989 et 2003 de 63 à 48 dont 2 paramètres microbiologiques, 26 paramètres chimiques, 18 paramètres indicateurs et 2 paramètres de radioactivité. Rapporté aux quelque 143 000 substances chimiques présentes en Europe, le taux de contrôle est donc de moins de 0,02 %35.

Eau du robinet et eau en bouteille

La communication des acteurs de la chaîne de l'eau en France aborde souvent l'opposition entre consommation d'eau en bouteille ou du robinet, qui est source de quelques polémiques :

- les producteurs d'eau en bouteille mettent en avant la qualité gustative de cette eau (absence de nitrate, entre autres) et l'absence de métaux lourds (plomb, etc.) parfois retrouvés dans l'eau du robinet en présence de canalisations anciennes. Les enjeux économiques relatifs à la commercialisation de l'eau en bouteille ont parfois conduit à distinguer le calcaire et le carbonate de calcium CaCO3 en réalité identiques ; le calcaire étant aussi composé de carbonate de magnésium MgCO3, et tous deux indispensables à l'organisme ;

- les distributeurs d'eau du robinet mettent en avant le mauvais écobilan des bouteilles en plastique (pollution à la production, libération de produits chimiques lors de périodes de chauffe) et de leur transport, etc., ainsi que le coût, plus élevé, de l'eau en bouteille.

En France, les deux types d'eau contiennent des polluants36.

Par ailleurs, l'eau sert aussi à nettoyer la nourriture et les vêtements, à se laver mais aussi pour remplir des piscines (et il faut 60 m3 d'eau pour remplir une piscine privée moyenne37).[source insuffisante]

Prélèvements et consommation par secteur

En France, de 2008 à 2015 les distributeurs d'eau de France métropolitaine fournissent environ 5,5 milliards de mètres cubes d’eau potable par an38, soit, en moyenne, 85 m3 par habitant et par an38, ou 234 litres d’eau par personne et par jour38 dont un tiers vient des eaux de surface38 (20 % de cette eau est perdue via les fuites du réseau de distribution38) ; et au total « plusieurs dizaines de milliards de m3 d’eau sont prélevés chaque année »39 et utilisés comme eau potable (embouteillée ou non), mais aussi pour l'irrigation, l'industrie, l'énergie, les loisirs, le thermalisme, les canaux, l'entretien de voiries, la production de neige artificielle ou bien d'autres activités, mais c'est la production d'énergie qui en utilise le plus (59 % de la consommation totale) devant la consommation humaine (18 %), l'agriculture (irrigation) (12 %) et l'industrie (10 %)40. Une banque nationale des prélèvements sur l'eau41 (BNPE) est disponible en ligne pour le grand-public comme les experts depuis 2015. Elle doit permettre le suivi des prélèvements quantitatifs (par environ 85 000 ouvrages connus en 2015) et d'évaluer la pression sur la ressource en eau (métropole et outre-mer français), avec des données détaillées ou de synthèse téléchargeables (mais « encore à consolider » en 2015)42).

D'un point de vue économique, le secteur de l'eau est généralement considéré comme partie prenante du secteur primaire car exploitant une ressource naturelle ; il est même parfois agrégé au secteur agricole43.

Secteur domestique

Secteur agricole

L’agriculture est le premier secteur de consommation d’eau, notamment pour l’irrigation.

En France, l’agriculture absorbe plus de 70 % de l’eau consommée44, ce qui peut s’expliquer par différentes raisons :

- l’élevage dont le régime alimentaire implique la mobilisation de grandes quantités d’énergie et d’eau par ration produite ;

- l’irrigation massive dans le but d’assurer des rendements maximaux pour des cultures nécessitant énormément d'eau44 ;

- l’accroissement de la population qui nécessite la production de plus grandes quantités de denrées alimentaires ;

- des régimes alimentaires plus riches dus à une orientation croissante du mode de vie « à l’occidentale ».

De ce fait, au début des années 1960, les agriculteurs, pour accroître de manière conséquente leurs rendements, ont eu recours à l’agriculture intensive (utilisation d’engrais chimiques, de pesticides et de produits phytosanitaires). Cette agriculture intensive a eu pour conséquence de polluer les eaux des sols avec de fortes concentrations en azote, phosphore et molécules issues des produits phytosanitaires44. Aujourd’hui, les traitements pour éliminer ces polluants sont complexes, onéreux et souvent difficiles à appliquer. Par conséquent, on s’oriente vers d’autres pratiques agricoles plus respectueuses de l’Homme et de l’environnement comme l’agriculture « intégrée » ou « biologique ». L'agroforesterie et les bocages sont des solutions pour construire des micro-climats et permettre la circulation de l'eau jusqu'à l'intérieur des terres grâce aux phénomènes d'évapotranspiration des végétaux. Pour exemple un hectare de hêtraie, qui consomme de 2 000 à 5 000 tonnes d’eau par an, en restitue 2 000 par évaporation45.

Secteur industriel

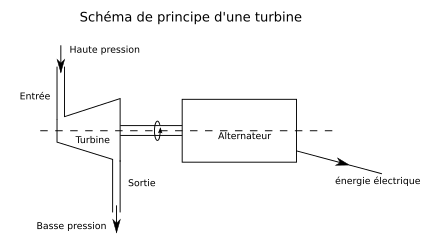

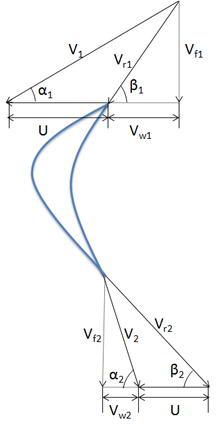

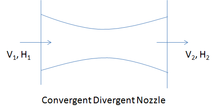

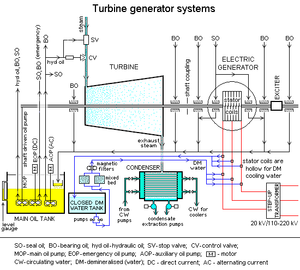

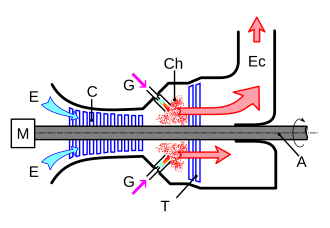

L’eau est aussi utilisée dans nombre de processus industriels et de machines, telles que la turbine à vapeur ou l’échangeur de chaleur. Dans l'industrie chimique, elle est utilisée comme solvant ou comme matière première dans des procédés, par exemple sous forme de vapeur pour la production d'acide acrylique46,47,48. Dans l’industrie, les rejets d’eau usée non traitée provoquent des pollutions qui comprennent les rejets de solutions (pollution chimique) et les rejets d’eau de refroidissement (pollution thermique). L’industrie a besoin d’eau pure pour de multiples applications, elle utilise une grande variété de techniques de purification à la fois pour l’apport et le rejet de l’eau.

L’industrie est ainsi grande consommatrice d’eau :

- en Asie du Sud-Est et Pacifique, elle représente plus de 30 % des prélèvements d’eau49. Dans ces régions l'industrie assure désormais 48 % du PIB total et cette proportion est en augmentation constante. La pollution et les déchets industriels mettent en danger les ressources en eau parce qu'ils dégradent et détruisent des écosystèmes à travers le monde. Ce phénomène menace la sécurité de l'eau50 ;

- les industries extractives consomment de plus en plus d'eau, et en particulier l'industrie pétrolière et gazière qui l'utilisent pour augmenter la pression dans les puits afin d'extraire plus d'hydrocarbures et plus rapidement, notamment avec la fracturation hydraulique. Une étude publiée en 2016 ayant porté sur 129 pays a porté sur l'empreinte eau de notre consommation énergétique : elle a montré d'importantes différences (selon les pays et les secteurs) en termes de dépendance aux ressources internationales en eau douce.

Par exemple, si l'industrie pétrolière a une ampleur comparable en Amérique du Nord et en Chine elle consomme en Amérique du Nord trois fois plus d'eau douce internationale. De même selon les données disponibles pour l'UE-28 avec, en moyenne, 86 % de la consommation d'eau douce associée au secteur pétrolier se faisant hors du pays de consommation. Un pays comme la France ne menace pas ses propres ressources puisque son pétrole est importé. Il peut être tenté d'accorder moins d'importance à ce phénomène que la Chine où cette question relève de la sécurité intérieure. Les pressions exercées par des pays riches sur des pays pauvres peuvent conduire à aggraver ou créer des pénuries d'eau et déstabiliser certains équilibres géostratégiques, au détriment de la paix, de la sécurité de l'eau et de l'énergie51. Les agrocarburants ne sont pas de ce point de vue une solution, car quand ils sont issus de plantes cultivées, ou de cultures artificielles d'algues, ils consomment aussi beaucoup d'eau51. Le nucléaire consomme aussi de l'eau, qu'il réchauffe, ainsi en France, environ 60 % des prélèvements d’eau (industrie) servent au refroidissement des centrales nucléaires[réf. nécessaire] ; - en Suisse, la population s'est accrue depuis 1975 mais sa consommation totale d'eau a diminué : en 1981, 500 litres par habitant et par jour étaient consommés ; en 2011, cette consommation est de 350 litres environ. Cette baisse est due notamment aux efforts de l'industrie52. Une bonne gestion de l’eau est donc possible avec une maîtrise des coûts53. Cependant, avec les canons à neige, l'industrie des loisirs pour les sports d'hiver utilise de plus en plus d'eau en la dégradant54,55.

Interconnexion eau énergie

Lutte contre les incendies

C’est parce que les combustibles se combinent avec l’oxygène de l’air qu’ils brûlent et dégagent de la chaleur. L’eau ne peut pas brûler puisqu’elle est déjà le résultat de la réaction de l’hydrogène avec l’oxygène.

Elle aide à éteindre le feu pour deux raisons :

- lorsqu’un objet est recouvert d’eau, l’oxygène de l’air ne peut pas parvenir jusqu’à lui et activer sa combustion ;

- la seconde est que l’eau peut absorber une grande quantité de chaleur lorsqu’elle se vaporise et, de ce fait, abaisser la température de la matière en combustion au-dessous de son point d’ignition.

Le craquage de l'eau ayant lieu à partir de 850 °C, on évite d'utiliser de l'eau sans additif si la température du brasier dépasse cette température. [réf. nécessaire]

Eaux usées

L'assainissement et l'épuration sont les activités de collecte et traitement des eaux usées (industrielles, domestiques, ou autres) avant leur rejet dans la nature, afin d’éviter la pollution et les nuisances sur l’environnement. L'eau après un premier traitement souvent est désinfectée par ozonation, chloration ou traitement UV, ou encore par microfiltration (sans ajout de produit chimique dans ces derniers cas).

Politique et économie

La protection de ce bien commun qu'est la ressource en eau a motivé la création d'un programme de l'ONU (UN-Water), et d'une évaluation annuelle Global Annual Assessment of Sanitation and Drinking-Water (GLAAS)56, coordonné par l'OMS.

La multiplicité de ses usages fait de l'eau une ressource fondamentale des activités humaines. Sa gestion fait l’objet d'une surveillance permanente et affecte les relations entre les États.

Pour faire face à ces questions, un conseil mondial de l'eau, dont le siège est à Marseille, a été fondé en 1996, réunissant des ONG, des gouvernements et des organisations internationales. De manière régulière, un forum mondial de l'eau est organisé pour débattre de ces sujets, mais pas toujours dans la même ville. En parallèle au forum mondial de l'eau, un forum alternatif mondial de l'eau est organisé par des mouvements alternatifs.

En France, les nombreux acteurs de l'eau et leurs missions diffèrent selon les départements et les territoires. Il existait cinq polices de l'eau aujourd'hui coordonnées par les Missions interservice de l'eau57 (MISE). Les Agences de l'eau sont des établissements publics percevant des redevances qui financent des actions de collectivités publiques, d'industriels, d'agriculteurs ou d'autres acteurs pour épurer ou protéger la ressource en eau. La distribution d'eau potable est un service public gérée au niveau communal ou EPCI, soit directement en régie, soit déléguée à une société privée (affermage, concession). L'ONEMA remplace le conseil supérieur de la pêche, avec des missions étendues.

La nouvelle « loi sur l'eau et les milieux aquatiques » (LEMA) de 2007 modifie en profondeur la précédente loi et traduit dans la législation française la « directive-cadre de l'eau » (DCE) européenne.

La gestion de l’eau couvre de nombreuses activités :

- la production agricole (irrigation et drainage) ;

- la production d'eau potable ;

- l'assainissement (ou épuration) ;

- la production d'énergie et le transport ;

- la restauration, protection et gestion des milieux naturels et forestiers (zones humides et milieux aquatiques).

La France est le pays des grandes entreprises de l'eau (Suez, Veolia, etc.). Celles-ci prennent une importance mondiale depuis les années 1990. Mais avec le Grenelle de l'Environnement et du grenelle de la mer, et sous l'égide de personnalités telles que Riccardo Petrella, la question de l'eau comme bien public reste posée.

En 2009, un colloque58 a porté sur la régulation et une plus grande transparence des services d'eau en France.

Problématique de l'eau en montagne

Les montagnes couvrent une part importante de la Terre. En Europe (35,5 % du territoire en Europe, 90 % en Suisse et en Norvège) et plus de 95 millions d’Européens y vivaient en 2006. Elles sont de véritables châteaux d’eau et jouent un rôle capital dans la gestion des ressources aquifères car elles concentrent une part importante des précipitations et tous les grands fleuves et leurs principaux affluents y prennent leur source.

En montagne, l'eau est une richesse écologique mais aussi source d'hydroélectricité et de commerce (mise en bouteille d’eau minérale), et le support de sports et loisirs en eaux vives. En Europe, 37 grandes centrales hydrauliques sont implantées en montagne (sur 50, soit 74 %) auxquelles s’ajoutent 59 autres grandes centrales sur 312 (18,9 %).

Les montagnes présentent des situations particulières, car elles sont tout d’abord des zones de risques :

- avec la pente et le relief, conjugués à une végétation souvent rase et fragile du fait d’un climat plus rude, elles sont des zones d’intenses érosions et de concentration rapide des eaux qui forment les crues et les inondations qui peuvent être ravageuses pour les parties basses des bassins et des plaines. Le phénomène est accentué par le surpâturage et la déforestation, par l’imperméabilisation du sol par les constructions, les aires de stationnement et les routes, en particulier dans les zones de fort développement urbain et touristique ;

- à l’inverse, l’abandon des secteurs les plus difficiles par les populations qui pratiquent des activités économiques traditionnelles comme le pastoralisme, a pour conséquences l’arrêt de l’entretien et la destruction des ouvrages collectifs, des zones de terrasses et des systèmes de drainage.

Mais l’eau en montagne, est surtout une source de richesse et de développement. Une meilleure valorisation de ce potentiel par l’aménagement du territoire peut être la source de nouvelles richesses pour l’économie des zones de montagne, mais dans le cadre d’un comportement économe et responsable. Avec le réchauffement climatique, les situations d’évènements extrêmes comme les sécheresses, les inondations et l’érosion accélérée, risquent de se multiplier et d’être, avec la pollution et le gaspillage, d’ici une génération un des principaux facteurs limitant le développement économique et social dans la plupart des pays du monde.

Selon les experts réunis à Megève en dans le cadre de l’« Année internationale de la montagne » avec la participation de la FAO, de l’UNESCO, du Partenariat mondial de l'eau et du Réseau international des organismes de bassin, afin de tirer un diagnostic et de formuler les propositions présentées au forum mondial de l'eau de Kyoto () : « La « solidarité amont-aval » reste trop faible : il vaut mieux aider les montagnes dans le cadre de politiques intégrées de bassins, pour qu’ils assurent la gestion et l’équipement nécessaires des hauts bassins versants. […] Il est impératif en effet de conduire en montagne des actions particulières renforcées d’aménagement et de gestion pour mieux se protéger contre les inondations et l’érosion, lutter contre les pollutions et optimiser les ressources en eau disponibles pour les partager entre les usagers, tant en amont que dans les plaines en aval. »[réf. souhaitée]

Problématique de l'eau et l'urbanisme

Certains territoires connaissent un développement important induit par la mise en service d’infrastructures routières nouvelles et un dynamisme économique. En France, les documents d’urbanisme sont révisés fréquemment pour permettre la construction d’espaces nouveaux[réf. nécessaire]. Or, l'extension des territoires urbanisés génère des impacts sur l’environnement : accroissement des prélèvements pour l’alimentation des populations en eau potable, augmentation des rejets (eaux pluviales et eaux usées), fragmentation des milieux naturels, etc.[réf. souhaitée] Ceux-ci ne sont pas toujours correctement appréhendés au niveau des documents d'urbanisme, qui structurent et planifient l'espace[réf. nécessaire]. Ces réflexions ont été au cœur du Grenelle de l’Environnement en 2007.

Ces impacts doivent être pris en compte en amont, dès la définition des projets structurants à l’échelle d’un territoire. Aussi convient-il de les intégrer dans l’élaboration des documents de planification urbaine (plans locaux d’urbanisme, cartes communales, etc.).

Enjeu géopolitique

L'eau est un objet et un vecteur de confrontations importantes. A ce titre, cette ressource est analysée sous le prisme de la géopolitique afin de rendre compte de son rôle dans le déclenchement de guerres59.

En 2017, sur 6,4 milliards d'êtres humains, 3,5 milliards de personnes boivent chaque jour de l’eau dangereuse ou de qualité douteuse60. De plus, 2,4 milliards ne disposent pas de système d'assainissement d'eau. En 2018, 2 milliards d'êtres humains dépendent de l'accès à un puits. Il faudrait mobiliser 37,6 milliards de dollars par an pour répondre au défi de l'eau potable pour tous, quand l'aide internationale est à peine de trois milliards60.

L'impossibilité d'accès à l'eau potable d'une grande partie de la population mondiale a des conséquences sanitaires graves. Ainsi, un enfant meurt toutes les cinq secondes de maladies liées à l’eau et à un environnement insalubre61 ; des millions de femmes s'épuisent en corvées d’eau ; entre 40 et 80 millions de personnes ont été déplacées à cause des 47 455 barrages construits dans le monde, dont 22 000 en Chine62[réf. incomplète]. Selon l’ONG Solidarités International, 361 000 enfants de moins de cinq ans meurent chaque année de diarrhée causée par un accès inadéquat à l’Eau, l'Hygiène et l'Assainissement (EHA)63. Toutes causes confondues (diarrhées, choléra, gastro-entérites infectieuses aigües et autres infections), ces maladies hydriques64 représentent selon l'Unicef 1,8 million de victimes chez les moins de cinq ans65. Chaque année, 272 millions de jours de scolarité sont perdus à cause d'infections transmises par l'eau insalubre60.

Symbolique

- Dans la théorie des humeurs corporelles, l’eau était associée au flegme, aussi dénommée pituite en physiologie antique.

- Dans la symbolique occidentale, l’eau symbolise la purification, le renouveau : par exemple, l’eau coulante d’un fleuve.

- L'eau est aussi un symbole de la tradition française dans la célébration des 100 ans de mariage (même si à ce jour aucun couple n'a été recensé comme ayant atteint ce stade).

L’eau a longtemps revêtu plusieurs aspects dans les croyances et les religions des peuples. Ainsi, de la mythologie gréco-romaine aux religions actuelles, l’eau est toujours présente sous différents aspects : destructrice, purificatrice, source de vie, guérisseuse, protectrice ou régénératrice.

L'eau dans les cultures, mythes et religions

Les sciences laissent penser que l’eau est indispensable à la vie. La mythologie et certaines religions ont lié l'eau à la naissance, à la fécondité, à la pureté ou à la purification.

- L’eau est un des quatre éléments classiques mythiques avec le feu, la terre et l’air, et était vue par Empédocle comme l’élément de base de l’univers. Les caractéristiques de l’eau dans ce système sont le froid et l’humidité.

- Plusieurs dieux et déesses romains et grecs sont issus des eaux : ainsi Océan, un Titan, le fleuve qui entoure le monde et son épouse Téthys, une titanide, tous deux issus de l’eau, donnèrent naissance aux dieux fleuves et à plus de trois mille Océanides, leurs filles. D’autres plus célèbres ont leur vie liée à l’eau, tels Vénus (« celle qui sort de la mer ») issue de la mythologie romaine et Amphitrite (déesse de la mer), Poséidon ou Nérée (divinité marine), tous issus de la mythologie grecque.

- Avant Empédocle, Bouddha considérait les quatre éléments comme base de l’univers. Les caractéristiques de l’eau dans ce système sont le lien, le transport, la transmission, la communication, la synthèse. Les molécules d'eau s'allient et se délient des milliards de fois à chaque seconde. Du point de vue de l'unité dans l'approche symbolique, les quatre éléments forment une unité, qui peut être perçue comme la quintessence des quatre éléments. Dans cette perception, la symbolique de la terre (le solide, la structure), du feu (la température) et de l'air (le mouvement) peuvent être vus dans l'eau.

- C’est aussi l’un des cinq éléments chinois avec la terre, le feu, le bois et le métal, associé au Nord et à la couleur noire, et l’un des cinq éléments japonais.

- Pour les chrétiens, l'eau représente un « élément essentiel de purification et de vie », comme le rappelle le pape François dans son message pour la quatrième journée mondiale de prière pour la sauvegarde de la Création consacrée au thème de l'eau. Il mentionne le baptême, sacrement de la renaissance, où l'eau sanctifiée par l’Esprit est la matière par laquelle Dieu nous a vivifiés et renouvelés ; c’est la source bénie d’une vie qui ne meurt plus66.

L'eau destructrice

L’eau revêt cet aspect destructeur notamment lorsqu’on parle de fin du monde ou de genèse. Mais cela ne se limite pas aux religions monothéistes. Ainsi, dans l’épopée de Gilgamesh, une tempête qui dura six jours et sept nuits était à l’origine des inondations et de la destruction de l’humanité. Les Aztèques ont eux aussi cette représentation de l’eau puisque le monde du Soleil d’Eau placé sous le signe de l’épouse de Tlaloc est détruit par un déluge qui rasera même jusqu’aux montagnes. « Et l’Éternel dit : J’exterminerai de la face de la terre l’homme que j’ai créé, depuis l’homme jusqu’au bétail, aux reptiles, et aux oiseaux du ciel ; car je me repens de les avoir faits. » : c’est par cela qu’est désignée la fin du monde dans la genèse judéo-chrétienne, et d’ajouter : « Les eaux grossirent de plus en plus, et toutes les hautes montagnes qui sont sous le ciel entier furent couvertes »67. Le mythe des aborigènes d’Australie est, quant à lui, attaché à l’idée de punition et non pas de destruction, puisqu’une grenouille géante aurait absorbé toute l’eau et asséché la terre mais aurait tout recraché en rigolant aux contorsions d’une anguille. Les marées contribuent lentement aux phénomènes d'érosion et d'engraissement sur les littoraux mais ce sont les grandes inondations et tsunamis qui marquent périodiquement les esprits. Depuis l'ère industrielle, de nombreuses usines et autres facteurs de risques ont été concentrés dans les vallées et sur les littoraux, faisant que le risque technologique peut se combiner avec les risques liés aux manques ou excès d'eau. Le Genpatsu shinsai est par exemple au Japon l'association du risque nucléaire au risque de tsunami, l'occurrence simultanée de deux événements de ce type aggravant fortement leurs conséquences respectives.

L'eau purificatrice

Cet aspect donne à l’eau un caractère presque sacré dans certaines croyances. En effet, outre la purification extérieure que confère l’eau, il y a aussi cette faculté d’effacer les difficultés et les péchés des croyants à son contact et de laver le croyant de toute souillure. Les exemples sont nombreux, allant de la purification dans le Gange dans l’hindouisme (où beaucoup de rituels sont exécutés au bord de l’eau tels que les funérailles) ou les ablutions à l’eau dans l’Islam jusqu’au baptême dans le christianisme ou l’initiation des prêtres shintoïstes.

L'eau guérisseuse et protectrice

Outre l’aspect purificateur, l’eau s’est étoffée au cours des siècles et des croyances d’une faculté de guérison. Plusieurs signes de culte et d’adoration datant du Néolithique ont été retrouvés près de sources d’eau en Europe. Longtemps, des amulettes d’eau bénite ont été accrochées à l’entrée des maisons pour protéger ses occupants du Mal. On considère que le contact avec certaines eaux peut aller jusqu’à guérir de certaines maladies. L’exemple le plus proche est celui du pèlerinage à Lourdes en France où chaque année des milliers de gens se rendent pour se baigner dans sa source. Parmi les cas de guérison par l’eau de Lourdes, 67 ont été reconnus par l’Église catholique. Les rituels thérapeutiques christianisés des bonnes fontaines en constituent une autre illustration68. Du point de vue de la science, les propriétés curatives ont été démontrées car aujourd’hui l’hydrothérapie est courante dans les soins de certaines maladies.

Le canular du monoxyde de dihydrogène (DHMO)

Le canular du monoxyde de dihydrogène, conçu par Eric Lechner, Lars Norpchen et Matthew Kaufman, consiste à attribuer à l’eau la dénomination scientifique de monoxyde de dihydrogène (DHMO), inconnue des non-initiés, et à tenir à son sujet un discours solennellement scientifique de manière à créer chez l’auditeur une inquiétude injustifiée.

Notes et références

Notes

- L'eau pure est légèrement bleue, mais elle est si transparente que cette couleur n'est perceptible qu'à partir de plusieurs mètres d'épaisseur. Pour plus de détails, voir Couleur de l'eau1.

- À grande profondeur dans les deux planètes géantes glacées du Système solaire, dans les satellites des deux planètes géantes gazeuses et dans les planètes naines, l'eau solide n'est pas de la glace ordinaire mais l'un de ses nombreux polymorphes.

- On ne sait pas quelles formes peut prendre la vie extraterrestre, mais il est probable que l'eau liquide lui soit également indispensable.

- L’eau pure est parfois désignée sous le nom de « solvant universel ». D'où la teneur en matière sèche ou gazeuse des eaux minérales. L'eau fortement minéralisée perd cette capacité de dissolution importante. Elle relargue parfois sa charge de matière transportée, par exemple sous forme de tartres ou roches chimiques dites évaporites.

- Au moment de la création de cette échelle, c'était le contraire : le 0 était sur l'eau en ébullition, et le 100 sur la glace fondante (Leduc et Gervais 1985, p. 26)(Parrochia 1997, p. 97-98)

- Par construction, un écart d'un degré Celsius est donc strictement égal à un écart d'un kelvin.

- La différence entre les deux échelles n'est que de quelques centièmes de degré de 0 à 100 °C.

- Dans la molécule CH4 les quatre doublets sont identiques et forment deux à deux des angles de 109,5° ; dans la molécule H2O les deux doublets liants se repoussent un peu moins que les autres couples de doublets, ce qui explique cet angle de 104,5°, un peu plus faible que celui de la symétrie tétraédrique (en).

- Une molécule d'eau peut cependant n'avoir aucun dipôle électrostatique lorsque ses atomes d'hydrogène sont délocalisés par effet tunnel. C'est le cas pour une unique molécule d'eau piégée dans la structure cristalline d'un béryl à des températures de quelques kelvins30.

- Pour un Américain moyen

Références

- Mathieu, « Dossier - pourquoi la couleur de l'océan est-elle bleue? » [archive], sur Podcast Science, (consulté le ).

- Masse molaire calculée d’après « Atomic weights of the elements 2007 » [archive], sur www.chem.qmul.ac.uk.

- Properties of Water and Steam in SI-Units - 1969 Prepared by Ernst Schmidt, Springer, Verlag Berlin Heidelberg New York - R. Oldenburg München

- (en) « eau » [archive], sur NIST/WebBook [archive]

- (en) Philip E. Ciddor, « Refractive index of air: new equations for the visible and near infrared », Applied Optics, vol. 35, no 9, , p. 1566-1573 (DOI 10.1364/AO.35.001566).

- (en)Entrée water sur GESTIS [archive].

- (en) T. E. Daubert et R. P. Danner, Physical And Thermodynamic Properties Of Pure Chemicals, Pennsylvania, Taylor & Francis, , 736 p. (ISBN 1-56032-270-5).

- (en) W. M Haynes, Handbook of chemistry and physics, CRC, 2010-2011, 91e éd., 2610 p. (ISBN 9781439820773), p. 14-40

- (en) Marvin J. Weber, Handbook of optical materials, CRC Press, , 536 p. (ISBN 978-0-8493-3512-9, lire en ligne [archive]).

- « Substance Name: Water » [archive], sur ChemIDPlus

- « Decouvrir l'eau : proprietes » [archive], sur sagascience.cnrs.fr (consulté le ).

- (en) « World » [archive], sur The World Factbook, Central Intelligence Agency.

- Voir Géopolitique de l'eau pour plus de détails.

- Programme BCPST.

- Pierre Laszlo, « Les aquaporines » dans La Science au présent 2009. Ed. Encyclopaedia Universalis, 2009.

- Passage trans membranaire d'une molécule d'eau [archive], via la protéine aquaporine, Animation produite par le NIH ("Center for Macromolecular Modeling and Bioinformatics")

- « Pourquoi la glace prend-elle plus de place que l'eau liquide ? » [archive], sur Futura, (consulté le ).

- (en) Chapter 8: Introduction to the Hydrosphere [archive], sur PhysicalGeography.net (consulté le 25 mars 2015).

- (en) Sybille Hildebrandt, « The Earth has lost a quarter of its water » [archive], sur http://sciencenordic.com [archive], (consulté le ).

- De gigantesques quantités d'eau enfouies sous nos pieds ? [archive], Science et vie, 19 mars 2014.

- (en) Nathalie Bolfan-Casanova, « Water in the Earth's mantle », Mineralogical magazine, vol. 69, no 3, , p. 229-257 (DOI 10.1180/0026461056930248).

- Francis Rocard, « Système solaire : la ruée vers l’eau » [archive], sur France Culture, (consulté le ).

- (en) « Anthropocene » [archive], sur Encyclopedia of Earth (en) et Welcome to the anthropocene [archive] sur anthropocene.info.

- (en) IGBP ; international Geosphere Biosphere Program [archive] (2013), Visuation de données L'eau dans l'anthropocène [archive] ; document pédagogique produit par IGBP et Globaia illustrant la manière dont l'humanité a bouleversé le cycle global de l'eau sur la planète durant l'anthropocène (animation de 3 min commandé par le Global Water System Project ; http://www.gwsp.org [archive] GWSP]) pour la conférence « open science » Water in the Anthropocene (L'eau dans l'Anthropocène [archive] de Bonn, en 2013)

- En vidéo : de l'eau sculptée avec des champs électriques [archive], Futura-Sciences, 4 octobre 2007 (consulté le 27 avril 2012).

- La Recherche, no 451, avril 2011.

- « La qualité radiologique de l'eau du robinet en France » IRSN, 2008-2009, 43 p., février 2011.

- Christiane Ferradini, Jean-Paul Jay-Gerin, « La radiolyse de l'eau et des solutions aqueuses : historique et actualité », Revue canadienne de chimie, vol. 77, no 9, septembre 1999, résumé [archive]

- Jane Reece, Lisa Urry, Michael Cain, Steven Wassermann, Peter Minorsky, Robert Jackson, Biology, Campbell, , 1263 p. (ISBN 978-0-321-55823-7)

- (en) « Focus: Water Molecule Spreads Out When Caged » [archive], sur physics.aps.org,

- Site du CNRS, page sur l'eau dans l'organisme [archive]

- (en) 4 Water | Dietary Reference Intakes for Water, Potassium, Sodium, Chloride, and Sulfate | The National Academies Press (DOI 10.17226/10925, lire en ligne [archive]), p. 73-

- (en) 4 Water | Dietary Reference Intakes for Water, Potassium, Sodium, Chloride, and Sulfate | The National Academies Press (DOI 10.17226/10925, lire en ligne [archive]), p. 80-

- [PDF] « Campagne nationale d’occurrence des résidus de médicaments dans les eaux destinées à la consommation humaine - Ressources en eaux brutes et eaux traitées »(Archive.org • Wikiwix • Archive.is • http://www.anses.fr/Documents/LABO-Ra-EtudeMedicamentsEaux.pdf" rel="nofollow" class="external text">Google • Que faire ?), rapport ANSES

- Benoît Saint Girons, La qualité de l'eau, Paris, Médicis, , 218 p. (ISBN 978-2-85327-695-5), p. 26

- Sophie Landrin, « L’eau minérale n’est plus épargnée par la pollution », Le Monde, (lire en ligne [archive])

- « 12 euros pour remplir sa piscine » [archive], le Ravi, mars 2013

- La France puise 5,5 milliards de mètres cubes d’eau par an [archive], Journal Le Monde, 16.10.2015, citant une l’étude BIPE 2015 [archive] (15 octobre 2015) sur les services publics d’eau et d’assainissement.

- ONEMA, Communiqué 2015 en ligne : Ouverture de la banque nationale des prélèvements en eau [archive].

- Chiffres de la consommation d'eau en France par secteur sur le site Eaufrance [archive]

- Banque nationale des prélèvements quantitatifs en eau [archive]

- voir p 2/4 chap : « Journée technique du 27 janvier 2015 Connaître et apprendre à utiliser la BNPE », synthèse de journée technique sur la banque nationale des prélèvements en eau (BNPE), dans la lettre Rés'eau Infos de l'ONEMA, no 12, mai 2015.

- « Enseignement agricole - Des débouchés principalement dans les métiers de l'aménagement paysager et de la production agricole » [archive], INSEE (consulté le ).

- Eau et agriculture [archive], sur eaufrance.fr

- « Comprendre la forêt » [archive], sur onf.fr

- (en) « The reaction network in propane oxidation over phase-pure MoVTeNb M1 oxide catalysts », Journal of Catalysis, vol. 311, , p. 369-385. (lire en ligne [archive])

- « Surface chemistry of phase-pure M1 MoVTeNb oxide during operation in selective oxidation of propane to acrylic acid », Journal of Catalysis, vol. 285, , p. 48-60 (lire en ligne [archive])

- (en) Kinetic studies of propane oxidation on Mo and V based mixed oxide catalysts, Berlin, (lire en ligne [archive])

- Banque mondiale 2002 et UN-Water.

- L'eau, une responsabilité partagée, 2e rapport mondial des NU sur la mise en valeur des ressources en eau.

- Petroleum industry’s freshwater use puts pressure on areas with water scarcity issues [archive], "Science for Environment Policy": European Commission DG Environment News Alert Service, edited by SCU, The University of the West of England, Bristopublié 2016-03-10, consulté 2016-03-13

- Indicateur Consommation d'eau - Industrie et artisanat [archive], sur bafu.admin.ch (consulté le 27 avril 2012)

- Introduction aux thématiques de l'Eau [archive], 19 novembre 2012, sur cms2.unige.ch

- Documentaire : La montagne, nouvel Ibiza [archive], ZDF pour Arte, 2014, rediffusé en 2016 (90 min)]

- Felix Hahn, CIPRA-International L’enneigement artificiel dans l’arc alpin [archive] Rapport de synthèse, CIPRA, Alpmedia, PDF, 18 p, consulté 2016-03-13

- GLASS, 2008 [archive]

- « Mission inter-services de l’eau (MISE) - DREAL Centre-Val de Loire » [archive], sur www.centre.developpement-durable.gouv.fr (consulté le )

- Colloque organisé à l’Assemblée nationale le 12 mars 2009, à l’initiative de la Fondation France-Libertés, de la Fédération des distributeurs d’eau indépendants (FDEI) et des Entreprises publiques locales de l’eau, regroupées au sein de l’association Arpege (Propositions faites lors du colloque [archive] et programme [archive])

- Patrice Gourdin, Géopolitiques manuel pratique, Choiseul éd, dl 2010 (ISBN 978-2-36159-000-0 et 2-36159-000-X, OCLC 690353450, lire en ligne [archive])

- « Baromètre de l'eau 2018 », Baromètre de l'eau, (lire en ligne [archive] [PDF]).

- « Le baromètre de l'eau, de l'hygiène et de l'assainissement », Le baromètre de l'eau, de l'hygiène et de l'assainissement, (lire en ligne [archive] [PDF]).

- François Anctil, L'eau et ses enjeux, De Boeck Supérieur, , 264 p. (ISBN 9782807307049, lire en ligne [archive]).

- « L'Eau » [archive], sur solidarites.org

- « Combattre les maladies hydriques » [archive], sur solidarites.org.

- Suzanne Dionnet-Grivet, Géopolitique de l'eau, Paris, Ellipses, , 253 p. (ISBN 978-2-7298-6404-0), p. 45

- Message pour la Journée Mondiale de Prière pour la Sauvegarde de la Création, 1er septembre 2018 [archive]

- Livre de la Genèse, (VI, 7)/ (VII, 19)

- Les fontaines à thérapie en France sont présentées dans : Brigitte Caulier, « L'eau et le sacré - Les cultes thérapeutiques autour des fontaines en France du Moyen Âge à nos jours » [archive], Beauchesne éd., presses de l'université Laval, 1990 (ISBN 2-7010-1214-7)

Voir aussi

Bibliographie

- Écologie politique de l'eau, sous la direction de Jean-Philippe Pierron avec la collaboration de Claire Harpet, Hermann Éditeurs, 2017.

- Olivier Hoedeman et Satoko Kishimoto (trad. de l'anglais), L’Eau, un bien public, Paris, éditions Charles Léopold Mayer, , 322 p. (ISBN 978-2-84377-158-3, présentation en ligne [archive], lire en ligne [archive])

- Erik Orsenna, L'Avenir de l'eau, Paris, Fayard, , 411 p. (ISBN 978-2-213-63465-4)

- (fr + pt + ar) Mohamed Larbi Bouguerra, Les Batailles de l'eau : pour un bien commun de l'humanité, Paris, éditions de l'Atelier (en coédition avec onze éditeurs francophones de dix pays), , 240 p. (ISBN 2-7082-3692-X, présentation en ligne [archive])

- Needham, Paul, « Water and the Development of the Concept of Chemical Substance », dans T. Tvedt, and T. Oestigaard, éd., « A History of Water Vol. 4: The Ideas of Water from Antiquity to Modern Times », I.B. Tauris, Londres, 2010, texte intégral [archive].

- Vazken Andréassian et Jean Margat, Rivières & rivaux : les frontières de l'eau, Versailles, Éditions Quae, , 134 p. (ISBN 978-2-7592-1706-9, lire en ligne [archive])

- Pierre-André Magnin et Mirko Saam, « Eaux-là-là! - Tous liés par l'eau!? », Services cantonaux de l'énergie et de l'environnement, 2013. En 16 pages illustrées, cette brochure fait le tour de la problématique de l'eau, également en liaison avec l'énergie. (http://www.energie-environnement.ch/fichiers/eau-la-la/brochure_fr.pdf [archive])

- Éditions Sonobook, « L'Eau dans le monde », livre audio d'après l'ouvrage de La Petite Encyclopédie Larousse, durée : 3 h 42 min, 1 CD MP3, www.sonobook.fr

- Richard Leduc et Raymond Gervais, Connaître la météorologie, Presses Universitaires du Québec, , 305 p. (ISBN 978-2-7605-2044-8, lire en ligne [archive])

- Daniel Parrochia, Météores : Essai sur le ciel et la cité, Editions Champ Vallon, , 250 p. (ISBN 978-2-87673-238-4, lire en ligne [archive])

- Ghislain de Marsily, L'eau, Flammarion, , 129 p.

Articles connexes

Sciences

- Pluie, rosée, goutte, liquide

- Cours d'eau, mer, océan, nappe phréatique

- Brouillard, nuage, brume, glace, neige

- Alcalinité de l'eau

- Inondation, sécheresse, soif

- Hydromorphologie

- Canular du monoxyde de dihydrogène

- Teneur en eau, hygrométrie, humidité

- Épuration des eaux, dessalement

- Pollution de l'eau, marine, par les produits phytosanitaires

- Turbidité, filtration

- Stratification de l'eau

Dans le Wikilivre de Tribologie, on peut trouver des données concernant le frottement sur la glace.

Utilisations

Gestion et réglementation

- Schéma directeur d'aménagement et de gestion des eaux (SDAGE) et Schéma d'aménagement et de gestion des eaux (SAGE), parc naturel marin

- Police de l'eau

- Technicien de rivière

- Eau virtuelle

Art et culture

Liens externes

- Ressources relatives à la santé

- :

- ChEMBL

- DrugBank

- (en) Medical Subject Headings

- (en) National Drug File

- (no + nn + nb) Store medisinske leksikon

- Ressource relative à la musique

- :

-

Notices dans des dictionnaires ou encyclopédies généralistes

-

:

- Brockhaus Enzyklopädie [archive]

- Enciclopedia italiana [archive]

- Encyclopædia Britannica [archive]

- Encyclopædia Universalis [archive]

- Encyclopedia of Chicago [archive]

- Encyclopedia of the Great Plains [archive]

- Encyclopédie Treccani [archive]

- Gran Enciclopedia Aragonesa [archive]

- Gran Enciclopèdia Catalana [archive]

- Swedish Nationalencyklopedin [archive]

- Store norske leksikon [archive]

- The West Virginia Encyclopedia [archive]

- Tout savoir sur l'eau [archive], sur lesagencesdeleau.fr

Cellule photovoltaïque

Une cellule photovoltaïque, ou cellule solaire, est un composant électronique qui, exposé à la lumière, produit de l’électricité grâce à l’effet photovoltaïque. La puissance électrique obtenue est proportionnelle à la puissance lumineuse incidentea et elle dépend du rendement de la cellule. Celle-ci délivre une tension continue et un courant la traverse dès qu'elle est connectée à une charge électrique (en général un onduleur, parfois une simple batterie électrique).

Les cellules photovoltaïques les plus répandues sont constituées de semi-conducteurs, principalement à base de silicium et plus rarement d’autres semi-conducteurs : séléniure de cuivre-indium (CuIn(Se)2, ou CIS), séléniure de cuivre, d'indium et de gallium (CuInGa(Se)2, aussi appelé CIGS), tellurure de cadmium (CdTe), etc. Elles se présentent généralement sous forme de fines plaques d’une dizaine de centimètres de côté.

Les cellules sont souvent réunies dans des modules photovoltaïques ou panneaux solaires, en fonction de la puissance recherchée.

Histoire

XIXe siècle

Le principe de l'effet photoélectrique (transformation directe d'énergie portée par la lumière en électricité) est appliqué dès 1839 par Antoine Becquerel1 et son fils Edmond Becquerel qui note qu'une chaîne d'éléments conducteurs d'électricité donne naissance à une tension électrique quand elle est éclairée.

La fabrication de la première cellule solaire en matériaux semi-conducteurs est attribuée à Charles Fritts en 18832,3. Cette cellule atteignait un rendement de près de 1 %, et utilisait de l'or et du sélénium, des matériaux coûteux4.

XXe siècle

Le sélénium puis le silicium (qui a finalement supplanté le cadmium-tellure ou le cadmium-indium-sélénium également testés pour des raisons de coût) se sont montrés propice à la production des premières cellules photovoltaïques : posemètres pour la photographie dès 1914, puis générateurs[réf. nécessaire]. Hassan Kamel Al-Sabbah a alors eu pour projet, en 1928, de faire du Moyen-Orient un « Sahara vert », qui plus tard a inspiré le projet Desertec5.

Les faibles rendements des cellules à cette époque ne permettent pas d'applications concrètes des cellules photovoltaïques. Cela change en 1954, où les travaux de Gerald Pearson, Darryl Chapin et Calvin Fuller pour les laboratoires Bell permettent enfin d'aboutir6 à un rendement de 6 %4.

C'est en 1958 que la première application réelle des cellules photovoltaïques est trouvée, avec l'alimentation des émetteurs radio du satellite Vanguard 1. Le rendement de ces panneaux solaires était alors de 9 %4.

Les années 1960 voient le développement du photovoltaïque avec l'essor des satellites spatiaux, puis dans les années 1970 c'est l'alimentation en électricité des lieux reculés qui permet les premières applications au sol7.

XXIe siècle

La recherche porte aujourd'hui sur de nombreux types de matériaux et de structures, ayant pour objectif l'un ou plusieurs de ces buts :

- augmenter l'efficacité de conversion énergétique ;

- diminuer du prix de l'énergie solaire ;

- améliorer la flexibilité d'application ou exploiter une niche de marché ;

- améliorer fiabilité et durée de vie.

Les techniques utilisées vont des polymères/matériaux organiques (éventuellement souples)8 aux matériaux dont les composants sont abondants dans la croûte terrestre, en passant par des technologies telles que les points quantiques et beaucoup d'autres encore.

Principe de fonctionnement

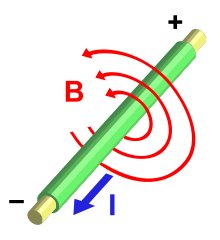

Dans un semi-conducteur exposé à la lumière, un photon d'énergie suffisante arrache un électron à la matrice et crée ainsi un « trou ». En l'absence de dispositif supplémentaire, l'électron trouve rapidement un trou pour se recombiner et l'énergie apportée par le photon est ainsi dissipée. Le principe d'une cellule photovoltaïque est de forcer les électrons et les trous à se diriger chacun vers une face opposée du matériau au lieu de se recombiner en son sein : il apparaîtra une différence de potentiel et donc une tension entre les deux faces, comme dans une pile. L'une des solutions pour atteindre cet objectif, couramment utilisée, est de générer un champ électrique au moyen d'une jonction P-N, c'est-à-dire entre deux couches dopées respectivement P et N.

Typiquement, la couche supérieure de la cellule est composée d'un semi-conducteur dopé Nb. Dans cette couche, il existe une quantité d'électrons libres supérieure à celle du matériau intrinsèque (i.e. non dopé), d'où l'appellation de dopage N, comme négatif (charge de l'électron). Le matériau reste électriquement neutre : c'est le réseau cristallin qui supporte globalement une charge négative. La couche inférieure de la cellule est généralement composée d'un semi-conducteur dopé Pc. Cette couche possédera donc en moyenne une quantité d'électrons libres inférieure à celle du matériau intrinsèque (i.e. non dopé), les électrons sont liés au réseau cristallin qui, en conséquence, est chargé positivement. La conduction électrique est assurée par des trous, positifs (P).

Au moment de la création de la jonction P-N, les électrons libres de la région N diffusent dans la couche P et se recombinent avec les trous de la région P. Il existera ainsi, pendant toute la vie de la jonction, une charge positive de la région N au bord de la jonction (parce que les électrons en sont partis) et une charge négative dans la région P au bord de la jonction (parce que les trous en ont disparu) ; l'ensemble forme la Zone de Charge d'Espace (ZCE) et il existe un champ électrique entre les deux, de N vers P. Ce champ électrique fait de la ZCE une diode, qui ne permet le passage du courant que dans un sens : les électrons peuvent passer de la région P vers la région N, mais pas en sens inverse ; inversement les trous ne passent que de N vers P.

En fonctionnement, un photon arrache un électron à la matrice, créant un électron libre et un trou. Ces porteurs de charge diffusent jusqu'à la zone de charge d'espace. Là, sous l'effet du champ électrique, ils partent chacun à l'opposé : les électrons s'accumulent dans la région N (qui devient le pôle négatif), tandis que les trous s'accumulent dans la couche dopée P (qui devient le pôle positif). Ce phénomène est plus efficace dans la ZCE, où les porteurs de charges (électrons ou trous) sont séparés immédiatement par le champ électrique. Le phénomène est aussi efficace à proximité immédiate de la ZCE : lorsqu'un photon y crée une paire électron-trou, ils se séparent et ont peu de chance de rencontrer leur opposé, alors que si la création a lieu plus loin de la jonction, le nouvel électron (respectivement le trou) conserve une grande chance de se recombiner avant d'atteindre la zone N (respectivement la zone P). La ZCE est très mince, il est ainsi souvent possible de fabriquer des cellules finesd.

D'un point de vue électrique, une cellule photovoltaïque est l'équivalent d'un générateur de courant auquel on a adjoint une diode. Il faut ajouter des contacts électriques (qui laissent passer la lumière en face éclairée : en pratique, on utilise souvent un contact par une grille), une couche antireflet pour assurer une bonne transmission des photons vers l'absorbeur. Pour que la cellule fonctionne, et produise le maximum de courant, on ajuste le gap du semi-conducteur au niveau d'énergie des photons. On peut éventuellement empiler les jonctions, de façon à exploiter au mieux le spectre d'énergie des photons, ce qui donne les cellules multi-jonctions, aussi appelées « cellules tandem ».

Matériau : silicium

Le silicium est actuellement le matériau le plus utilisé pour fabriquer les cellules photovoltaïques. On l'obtient par réduction à partir de silice, composé le plus abondant dans la croûte terrestre et notamment dans le sable ou le quartz. La première étape du processus est la production de silicium dit métallurgique, pur à 98 % seulement, obtenu à partir de morceaux de quartz provenant de galets ou d'un gisement filonien (la technique de production industrielle ne permet pas de partir du sable). Le silicium de qualité photovoltaïque doit être purifié jusqu'à plus de 99,999 %, ce qui s'obtient en transformant le silicium en un composé chimique qui sera distillé puis retransformé en silicium.

Le silicium est produit sous forme de lingots de section ronde ou carrée. Ces lingots sont ensuite sciés en fines plaques, le cas échéant mises au carré, de près de 200 µm d'épaisseur, appelées « wafers ». Après un traitement visant à l'enrichir en éléments dopants (P, As, Sb ou B) et ainsi obtenir du silicium semi-conducteur de type P ou N, les wafers sont « métallisés » : des rubans de métal sont incrustés en surface et reliés à des contacts électriques. Une fois métallisés, les wafers deviennent des cellules photovoltaïques.

La production des cellules photovoltaïques nécessite de l'énergie, et on estime qu'un module photovoltaïque doit fonctionner environ deux à trois ans pour compenser l’énergie nécessaire à sa fabrication (durée qu'on appelle retour énergétique)9,10, selon sa technique de fabrication, c'est-à-dire pour produire autant d'énergie qu'il en a été consommée pour sa fabrication. Les techniques de fabrication et les caractéristiques des principaux types de cellules à base de silicium sont décrits dans les trois paragraphes suivants.

Il existe d'autres types de cellules : les films photovoltaïques ou cellules solaires en couche mince, souples et prometteurs, mais leur utilisation est minoritaire après une baisse drastique des parts de marché dans les années 200011.

Les matériaux et procédés de fabrication font l'objet de programmes de recherche ambitieux pour réduire les coûts de fabrication et de recyclage des cellules photovoltaïques. De fait, en 2006 et 2007, la croissance de la production mondiale de panneaux solaires a été freinée par manque de silicium et les prix des cellules n'ont pas baissé autant qu'espéré. L'industrie cherche donc à faire baisser la quantité de silicium utilisé. Les cellules monocristallines sont passées de 300 μm d'épaisseur à 200, puis 150 μm en 2019, diminuant la quantité de matière et d'énergie nécessaires, mais aussi les prix. En 2019, des cellules de seulement 0,2 μm d'épaisseur sont produites avec un rendement de 20 %, mais le coût des procédés mis en œuvre ne les rendent accessibles que pour les applications spatiales12.

Silicium amorphe

Les cellules photovoltaïques en silicium amorphe sont fabriquées par dépôt sous vide, à partir de plusieurs gaz. L'une des techniques les plus utilisées est le dépôt chimique en phase vapeur assisté par plasma (PECVD). La cellule est gris très foncé. C'est la cellule des calculatrices et des montres dites « solaires ».

Cette technique a comme avantages :

- de fonctionner avec un éclairement faible ou diffus (même par temps couvert, y compris sous éclairage artificiel de 20 à 3 000 lux) ;

- d'être un peu moins chère que les autres techniques ;

- d'être intégrable sur supports souples ou rigides.

Elle a cependant pour inconvénients :

- un rendement faible en plein soleil, de 5 à 7 %13 ;

- une nécessité de couvrir des surfaces plus importantes que lors de l’utilisation de silicium cristallin (ratio Wc/m2 plus faible, environ 60 Wc/m2)14 ;

- une performance qui diminue avec le temps dans les premiers temps d'exposition à la lumière naturelle (3 à 6 mois), pour se stabiliser ensuite (-10 à -20 % selon la structure de la jonction).[réf. nécessaire],15,16

Silicium monocristallin

Lors du refroidissement, le silicium fondu se solidifie en ne formant qu'un seul cristal de grande dimension, sans joint de grains. On découpe ensuite le cristal en fines tranches qui donneront les cellules. Ces cellules sont en général d'un bleu uniforme.

Cette technique a comme avantage un bon rendement, de 16 à 24 % (en 2015) (~150 Wc/m2)14,13,17,18, et un nombre de fabricants élevé. Cependant, elle a un coût élevé, un rendement plus faible sous un faible éclairement ou un éclairement diffus19, et baisse du rendement quand la température augmente.

Silicium polycristallin

Pendant le refroidissement du silicium dans une lingotière, il se forme plusieurs cristallites. La cellule photovoltaïque est d'aspect bleuté, mais pas uniforme, on distingue des motifs créés par les différents cristallites et les joints de grains.

Elle a comme avantages :

- une forme de cellule carréee permettant un meilleur foisonnement dans un module ;

- un bon rendement de conversion, environ 100 Wc/m2 (voire plus)14, cependant un peu moins bon que celui du silicium monocristallin ; rendement de 14 à 18 %17,18 ; et un lingot moins cher à produire que le monocristallin. Cependant, elle a un rendement faible sous un faible éclairement ou soleil diffus.

Le terme « silicium multicristallin » est utilisé par la Commission électrotechnique internationale (réf. IEC TS 61836, vocabulaire international photovoltaïque). Le terme polycristallin est utilisé pour les couches déposées sur un substrat (en petits grains).

Fabrication

Cellule photovoltaïque tandem

Une cellule photovoltaïque tandem est un empilement de deux cellules simples. En combinant deux cellules (couche mince de silicium amorphe sur silicium cristallin par exemple) absorbant dans des domaines spectraux différents, on améliore le rendement théorique par rapport à des cellules simples distinctes, qu'elles soient amorphes, cristallines ou microcristallines. Elle a une sensibilité élevée sur une large plage de longueur d'onde, et un rendement élevé. Son coût est cependant plus élevé et sa réalisation est plus complexe. Des cellules tandem organiques ont atteint un rendement de 12 %20 et 18 % pour un tandem de perovskite et de silicium21.

Cellule photovoltaïque organique

Les cellules photovoltaïques organiques ont au moins leur couche active constituée de molécules organiques. Un rendement de plus de 15 % a été atteint22.

Cellule photovoltaïque multi-jonction

Les cellules multi-jonctions ont été développées pour des applications spatiales, pour lesquelles le paramètre clef n'est pas le rapport puissance/prix (Wc/$) mais la puissance massique, soit le rapport Wc/kg. Le développement a donc porté sur des cellules d'une grande efficacité de conversion. Cette technologie se retrouve également dans la filière photovoltaïque à concentration (CPV), qui bénéficie aussi particulièrement de l'utilisation de cellules de haut rendement.